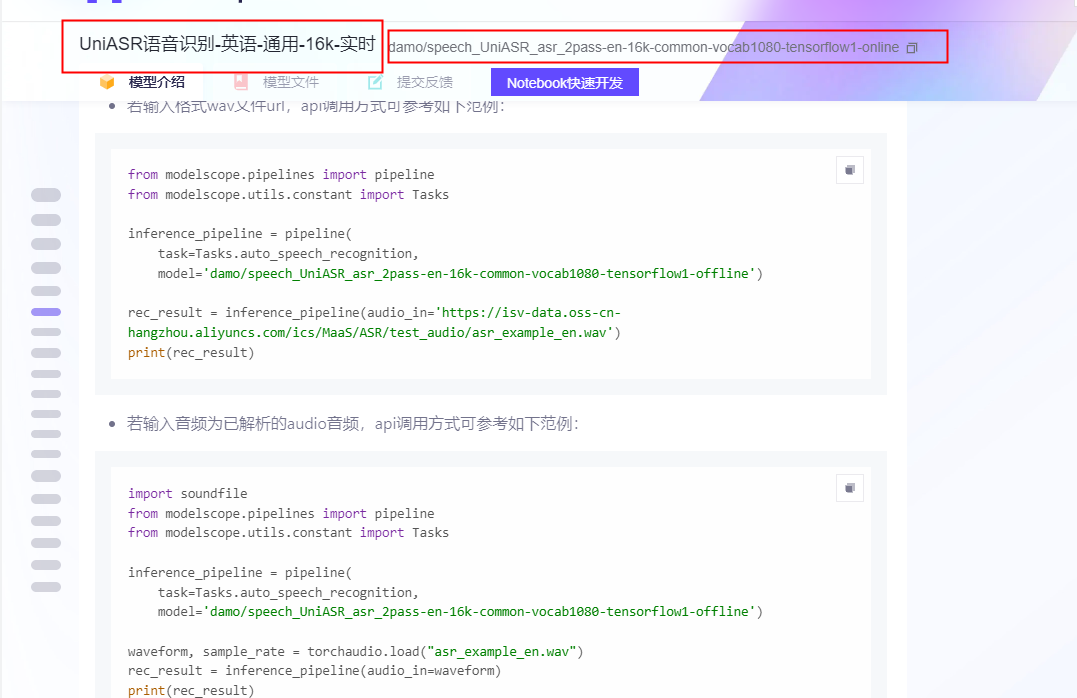

modelscope-funasr如何使用【UniASR语音识别-英语-通用-16k-实时】这个模型做流式的英文语音识别呢?文档中的范例,看着是一句话的语音识别。

要在ModelScope-FunASR中使用【UniASR语音识别-英语-通用-16k-实时】模型进行流式英文语音识别,可以按照以下步骤操作。尽管文档中的范例可能展示的是一句话的语音识别,但通过调整配置和代码逻辑,可以实现流式处理。

首先,确保您的开发环境满足以下要求: - Python版本:3.7或更高。 - 安装PyTorch和其他依赖包。

安装ModelScope-FunASR工具包的具体步骤如下:

# 克隆FunASR代码仓库

git clone https://github.com/alibaba-damo-academy/FunASR.git

cd FunASR

# 安装依赖包

pip install -r requirements.txt

# 安装FunASR及其扩展功能

pip install funasr[clip]

验证安装是否成功:

python -c "import funasr.utils.cli_utils; funasr.utils.cli_utils.print_info()"

如果安装成功,您将看到一条消息,提示FunASR已正确安装。

为了实现流式语音识别,需要对模型和输入数据进行特定配置。以下是关键步骤:

在FunASR中,可以通过指定模型名称加载预训练模型。对于【UniASR语音识别-英语-通用-16k-实时】模型,您可以直接使用其对应的模型标识符。

示例代码:

from funasr import AutoModel

# 加载模型

model = AutoModel(

model="UniASR-English-General-16k-Realtime", # 模型名称

disable_update=True, # 禁用模型更新以提高性能

streaming=True # 启用流式模式

)

注意:streaming=True 是启用流式语音识别的关键参数。

流式语音识别需要逐块读取音频数据,而不是一次性加载整个文件。推荐使用麦克风实时采集音频,或者将长音频分割为小块进行处理。

示例代码(从麦克风读取音频):

import pyaudio

import numpy as np

# 音频参数

CHUNK = 1024 # 每次读取的音频块大小

FORMAT = pyaudio.paInt16 # 音频格式

CHANNELS = 1 # 单声道

RATE = 16000 # 采样率(与模型匹配)

# 初始化PyAudio

p = pyaudio.PyAudio()

stream = p.open(format=FORMAT,

channels=CHANNELS,

rate=RATE,

input=True,

frames_per_buffer=CHUNK)

print("开始录音...")

try:

while True:

# 读取音频块

audio_data = stream.read(CHUNK)

audio_array = np.frombuffer(audio_data, dtype=np.int16)

# 将音频块传递给模型进行识别

result = model.generate(input=audio_array, is_final=False)

print("部分结果:", result["text"])

except KeyboardInterrupt:

print("停止录音...")

finally:

stream.stop_stream()

stream.close()

p.terminate()

重要提示: - is_final=False 表示当前音频块不是最终输入,模型会持续累积上下文信息。 - 当音频结束时,调用 is_final=True 通知模型完成识别。

流式语音识别的结果是逐步生成的,因此需要根据实际需求对中间结果进行处理。例如,可以在每次接收到部分结果时更新用户界面,或者在最终结果生成后执行后续操作。

示例代码(处理最终结果):

# 假设音频输入已完成

final_result = model.generate(input=audio_array, is_final=True)

print("最终识别结果:", final_result["text"])

CHUNK 参数)。以下是一个完整的流式语音识别示例代码:

from funasr import AutoModel

import pyaudio

import numpy as np

# 加载模型

model = AutoModel(

model="UniASR-English-General-16k-Realtime",

disable_update=True,

streaming=True

)

# 音频参数

CHUNK = 1024

FORMAT = pyaudio.paInt16

CHANNELS = 1

RATE = 16000

# 初始化PyAudio

p = pyaudio.PyAudio()

stream = p.open(format=FORMAT,

channels=CHANNELS,

rate=RATE,

input=True,

frames_per_buffer=CHUNK)

print("开始录音...")

try:

while True:

# 读取音频块

audio_data = stream.read(CHUNK)

audio_array = np.frombuffer(audio_data, dtype=np.int16)

# 流式识别

result = model.generate(input=audio_array, is_final=False)

print("部分结果:", result["text"])

except KeyboardInterrupt:

print("停止录音...")

finally:

stream.stop_stream()

stream.close()

p.terminate()

# 最终结果

final_result = model.generate(input=audio_array, is_final=True)

print("最终识别结果:", final_result["text"])

通过以上步骤,您可以成功使用【UniASR语音识别-英语-通用-16k-实时】模型实现流式英文语音识别。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352