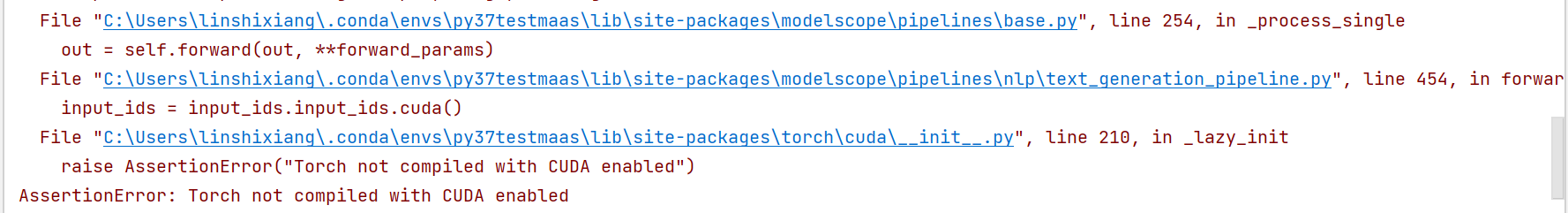

ModelScope中seqgpt一定要启用cuda才可以吗?

在ModelScope中,seqgpt模型是否一定要启用CUDA取决于具体的运行环境和需求。以下是详细分析和解答:

seqgpt是一个文本生成模型,其参数量较大(如知识库中提到的iic/nlp_seqgpt-560m模型大小为1.06GB)。对于这种规模的模型,通常需要高性能计算资源来支持推理或训练任务。如果使用CPU进行推理,可能会导致性能瓶颈,尤其是在处理长文本或高并发请求时。

因此,推荐在GPU环境下运行seqgpt模型,以充分利用CUDA加速能力,提升推理效率和响应速度。

虽然理论上可以在CPU上运行seqgpt模型,但实际效果可能不理想: - 性能问题:CPU的计算能力远低于GPU,尤其是对于深度学习模型中的矩阵运算。这会导致推理时间显著增加。 - 内存限制:如果模型较大,CPU的内存可能不足以加载整个模型,导致运行失败。

如果您确实需要在CPU上运行seqgpt,可以通过以下方式尝试:

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

# 加载模型和分词器

model_name = "iic/nlp_seqgpt-560m"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

# 确保模型运行在CPU上

device = torch.device("cpu")

model.to(device)

# 推理示例

input_text = "人工智能是什么?"

inputs = tokenizer(input_text, return_tensors="pt").to(device)

outputs = model.generate(**inputs)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

注意:这种方式仅适用于小规模测试或低性能需求场景,生产环境中不建议使用。

启用CUDA后,seqgpt模型可以利用GPU的并行计算能力,显著提升推理速度。以下是启用CUDA的关键步骤: 1. 确认环境支持CUDA: - 确保安装了支持CUDA的PyTorch版本。 - 检查GPU驱动和CUDA工具包是否正确配置。 2. 修改代码以启用CUDA:

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

# 加载模型和分词器

model_name = "iic/nlp_seqgpt-560m"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

# 确保模型运行在GPU上

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

# 推理示例

input_text = "人工智能是什么?"

inputs = tokenizer(input_text, return_tensors="pt").to(device)

outputs = model.generate(**inputs)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

torch.autocast可以减少显存占用并加速推理。seqgpt模型,并启用CUDA以获得最佳性能。如果您有更多关于模型部署或性能优化的问题,请随时补充说明!