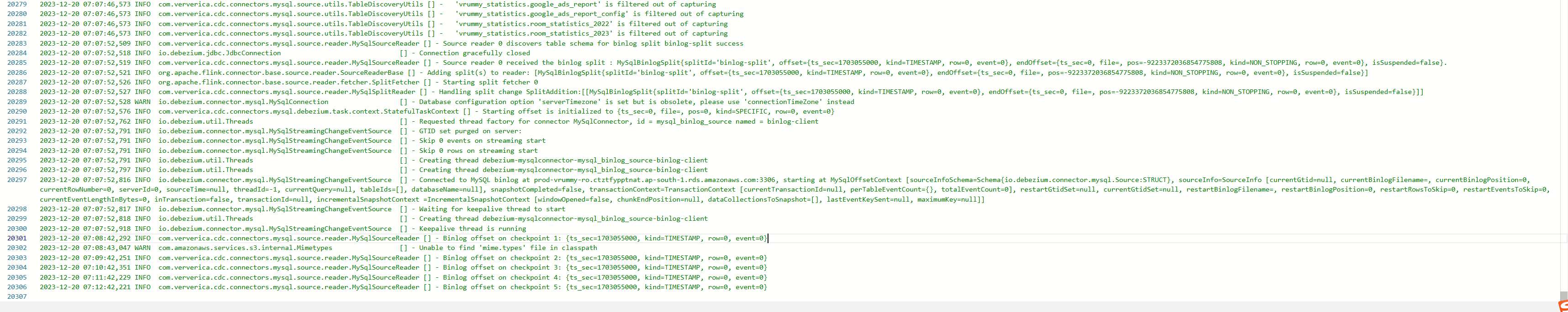

Flink CDC中timestamp模式启动任务,然后日志一直输出这个是啥问题呀?

Flink CDC中timestamp模式启动任务,然后日志一直输出这个是啥问题呀?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用Flink CDC以timestamp模式启动任务时,如果日志中一直输出某些信息,可能是由于以下原因导致的。以下是详细分析和解决方案:

1. 问题可能的原因

(1) 时间戳设置不合理

在timestamp模式下,Flink CDC会从指定的时间戳开始读取Binlog事件。如果指定的时间戳超出了Binlog的范围(例如早于最早可用的Binlog时间或晚于当前时间),可能会导致日志中持续输出错误或警告信息。

(2) Binlog格式或权限问题

Flink CDC依赖MySQL的Binlog来捕获变更数据。如果Binlog格式不正确(例如未设置为ROW模式)或用户权限不足,可能导致CDC无法正常读取数据,从而在日志中持续输出相关错误信息。

(3) 表结构变更导致解析失败

如果目标表在指定时间戳之后发生了表结构变更(如新增列、修改列类型等),Debezium读取器可能会因为无法解析早期的Binlog数据而报错,导致日志中持续输出异常信息。

(4) 日志级别设置过高

如果日志级别设置为DEBUG或TRACE,Flink CDC会输出大量调试信息,包括Binlog解析过程中的详细步骤。这可能会让用户误以为是异常信息。

2. 解决方案

(1) 检查时间戳设置

- 确保

scan.startup.timestamp-millis参数设置的时间戳在Binlog的有效范围内。 - 可以通过以下SQL查询MySQL的Binlog最早和最晚时间:

SHOW MASTER STATUS; SHOW BINLOG EVENTS IN 'binlog_file_name'; - 如果时间戳超出范围,请调整为合理的值。

(2) 验证Binlog配置

- 确保MySQL的Binlog格式为

ROW模式:SHOW VARIABLES LIKE 'binlog_format';如果不是

ROW模式,请修改MySQL配置文件并重启服务:binlog_format=ROW - 确保Flink作业使用的MySQL用户具有

REPLICATION SLAVE和REPLICATION CLIENT权限:GRANT REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'username'@'host';

(3) 处理表结构变更问题

- 如果目标表在指定时间戳之后发生了表结构变更,建议使用

initial模式重新启动任务,以确保全量数据和增量数据的一致性。 - 如果必须使用

timestamp模式,可以尝试跳过表结构变更前的数据,将时间戳设置为变更后的时间点。

(4) 调整日志级别

- 如果日志中输出了大量调试信息,可以通过以下方式调整日志级别:

- 在Flink配置文件

log4j.properties中,将日志级别设置为INFO:

log4j.rootLogger=INFO, console- 或者在代码中动态设置日志级别:

Logger.getLogger("org.apache.flink").setLevel(Level.INFO); - 在Flink配置文件

3. 重要提醒

- 避免重复消费:在

timestamp模式下,如果未正确设置消费位点,可能会导致重复消费数据。建议结合consumerGroup参数记录消费进度,并在必要时启用consumeFromCheckpoint功能。 - 监控日志输出:如果问题仍未解决,可以通过SLS或其他日志存储工具查看完整的日志内容,定位具体错误信息。

4. 总结

通过以上步骤,您可以逐步排查并解决Flink CDC在timestamp模式下日志持续输出的问题。如果问题仍然存在,建议提供具体的日志内容以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。