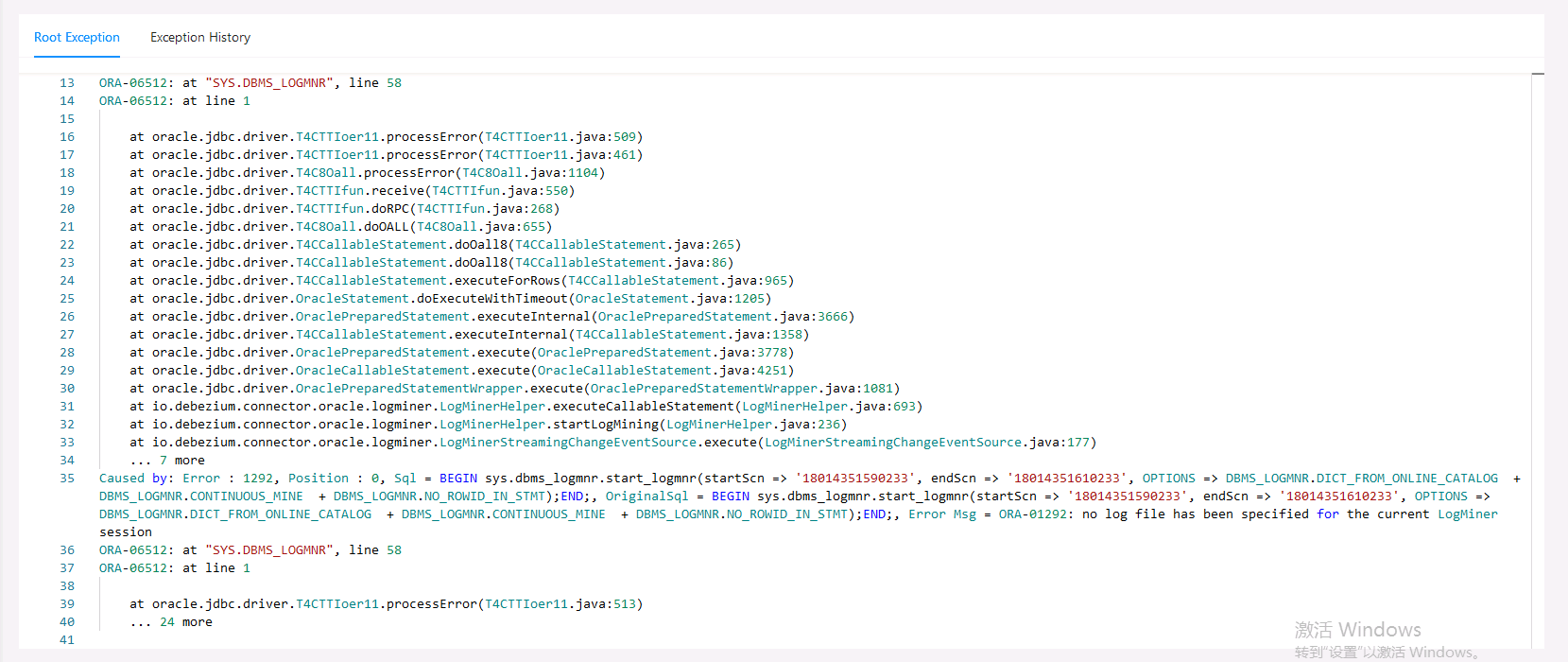

flinkcdc连接oracle报这个错误怎么解决?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的错误信息和知识库中的相关资料,以下是针对 Flink CDC 连接 Oracle 报错 的解决方案。由于您未明确具体的错误内容,我将从常见问题及可能的解决方案出发,帮助您排查和解决问题。

SELECT * FROM dba_log_groups WHERE table_name = 'PF_ID_NAME_PK';

如果未开启补偿日志,请执行以下命令启用:

ALTER DATABASE ADD SUPPLEMENTAL LOG DATA;

ALTER DATABASE ADD SUPPLEMENTAL LOG DATA (PRIMARY KEY) COLUMNS;

debezium.database.pdb.name 参数。debezium.database.pdb.name=your_pdb_name

SELECT * FROM DBA_SYS_PRIVS WHERE GRANTEE = 'C##DBZUSER';

SELECT TABLE_NAME FROM DBA_TAB_PRIVS WHERE GRANTEE = 'C##DBZUSER';

SELECT ANY TRANSACTIONLOGMININGSELECT_CATALOG_ROLESELECT 权限ALTER SESSION SET CONTAINER = CDB$ROOT;

ORA-00942: table or view does not exist,可能是 Oracle CDC 2.4 的一个已知 bug。LOG_MINING_FLUSH 表。以上是针对 Flink CDC 连接 Oracle 报错的常见问题及解决方案。建议您根据具体的错误信息逐一排查,并参考上述步骤进行调整。如果问题仍未解决,请提供更详细的错误日志,以便进一步分析和定位问题。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。