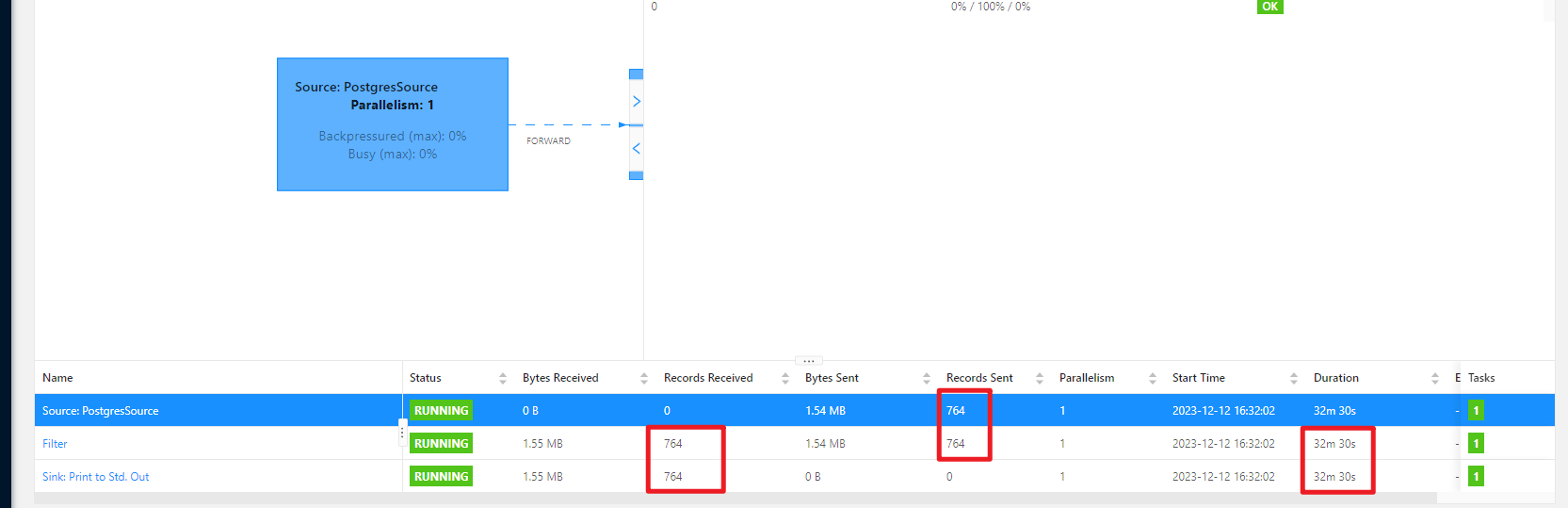

Flink CDC2.4.1同步pg半个小时只跑了7百多条数据, 用2.2.1版本时每秒将近10000条?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您提到在使用 Flink CDC 2.4.1 同步 PostgreSQL 数据时,性能显著下降(半小时仅同步700多条数据),而使用 2.2.1 版本时性能较高(每秒接近10,000条)。这种性能差异可能与以下几个方面有关:

以下将从这些方面逐一分析并提供解决方案。

Flink CDC 2.4.1 和 2.2.1 在功能和性能上可能存在显著差异。根据知识库中的信息,Flink CDC 的某些版本可能存在特定的限制或优化不足。例如: - Flink CDC 2.4.0 不支持同步 PostgreSQL 备库的数据,这表明该版本对 PostgreSQL 的支持可能存在局限性。 - 新版本可能引入了额外的校验逻辑或默认配置,导致性能下降。

建议: - 检查 Flink CDC 2.4.1 的发布说明,确认是否存在已知的性能问题或限制。 - 如果可能,尝试回退到 2.2.1 版本以验证是否为版本本身的问题。

PostgreSQL 的配置可能影响增量数据的读取效率。例如: - WAL(Write-Ahead Logging)配置:如果 WAL 日志级别设置较低(如 minimal),可能导致增量数据无法被高效捕获。 - 主备库配置:Flink CDC 2.4.0 不支持从 PostgreSQL 备库读取增量数据,因此如果您的数据源是备库,则会导致性能问题。

建议: - 确保 PostgreSQL 的 WAL 配置为 logical,以支持逻辑解码(Logical Decoding)。 - 确认数据源为主库,而非备库。 - 检查 PostgreSQL 的网络带宽和 I/O 性能,确保其不会成为瓶颈。

Flink CDC 的性能高度依赖于配置参数。以下是一些可能影响性能的关键参数:

parallelism.default 参数为更高的值。scan.incremental.snapshot.enabled 参数启用增量快照功能,从而提升全量和增量数据同步的效率。'scan.incremental.snapshot.enabled' = 'true'

source.fetch.max-bytes 或 source.fetch.max-rows 参数的值。PostgreSQL 的增量数据读取方式可能影响性能。例如: - Binlog 过滤器:MySQL 中可以通过 Binlog_Do_DB 和 Binlog_Ignore_DB 配置过滤增量数据,而 PostgreSQL 的逻辑复制槽(Logical Replication Slot)也可能存在类似限制。 - 表结构变更:如果表结构频繁变更(如新增列),可能导致同步性能下降。

建议: - 检查 PostgreSQL 的逻辑复制槽配置,确保其未被过滤或限制。 - 确认表结构是否稳定,避免频繁变更。

为了进一步定位问题,可以使用 Flink 的调试功能进行验证: - 模拟运行:使用作业调试功能模拟作业运行,检查输出结果是否符合预期。 - 日志分析:通过配置作业日志输出,分析同步过程中的瓶颈或错误信息。

建议: - 启用调试功能,验证 SELECT 或 INSERT 逻辑的正确性。 - 配置日志输出到 OSS 或 SLS,分析同步过程中的性能瓶颈。

根据上述分析,您可以按照以下步骤排查和优化性能问题:

logical。'scan.incremental.snapshot.enabled' = 'true'。通过以上步骤,您应能有效提升 Flink CDC 2.4.1 同步 PostgreSQL 的性能。如果问题仍未解决,请提供更多上下文信息(如配置文件、日志片段等),以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。