"modelscope我昨天试了在win10系统上布置https://www.modelscope.cn/models/damo/text-to-video-synthesis/summary, 总是提醒我CUDA设备找不到,但我通过系统检查,CUDA已经成功安装。我想请问存在pytorch与CUDA驱动版本冲突的问题吗?这是我遇到的错误信息提示(我使用的是win10系统):https://www.modelscope.cn/models/damo/text-to-video-synthesis/summary

raise RuntimeError('Attempting to deserialize object on a CUDA '

RuntimeError: Attempting to deserialize object on a CUDA device but torch.cuda.is_available() is False. If you are running on a CPU-only machine, please use torch.load with map_location=torch.device('cpu') to map your storages to the CPU. "

pytorch检查一下cuda是否可用 import torch

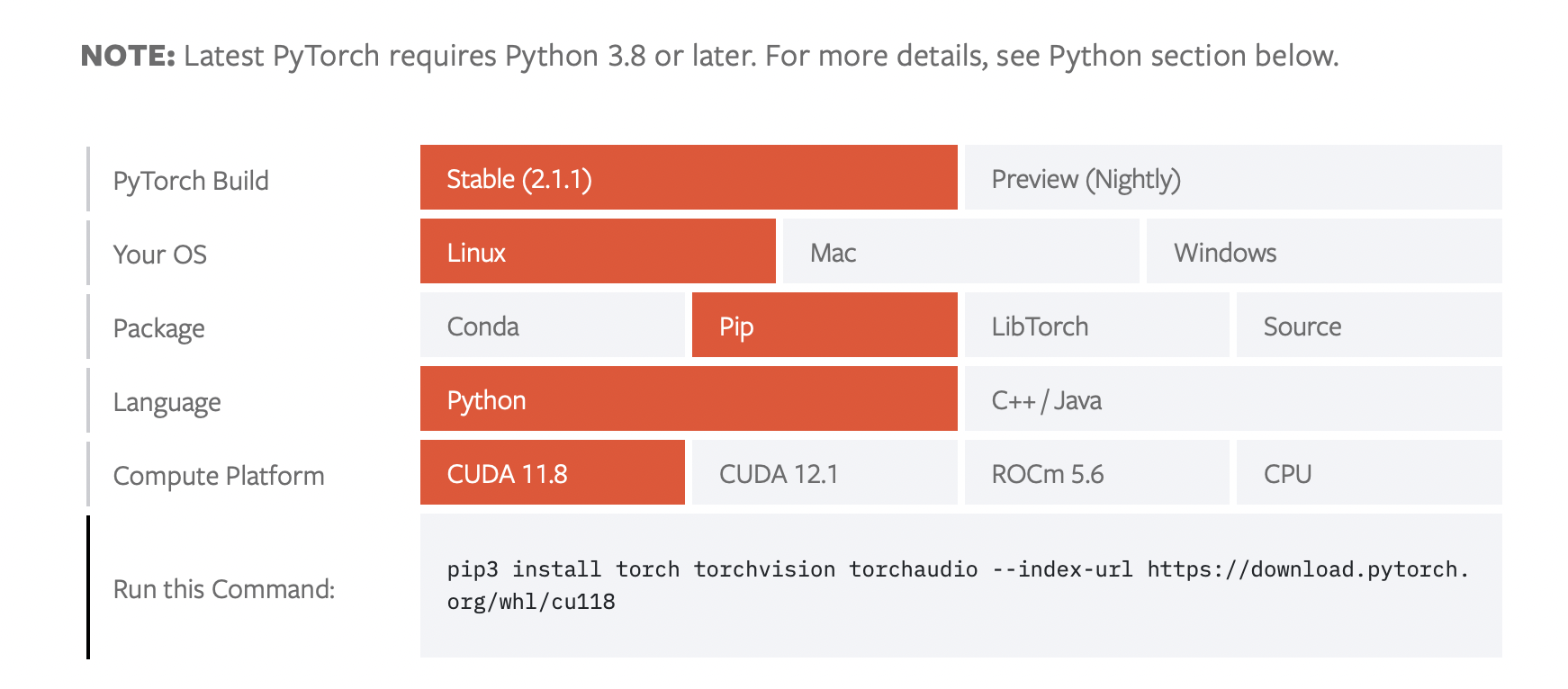

torch.cuda.is_available() 您用pytorch官网生成的命令,重装一下torch,还报错的话,降一下cuda版本12.1,https://pytorch.org/get-started/locally/  此回答整理自钉群“魔搭ModelScope开发者联盟群 ①” "

此回答整理自钉群“魔搭ModelScope开发者联盟群 ①” "

问题一和问题二看起来是同一个问题,即CUDA设备在运行模型时无法被找到。以下是一些可能的解决方法:

检查CUDA版本与PyTorch兼容性:

确保你的CUDA驱动版本和PyTorch版本是兼容的。你可以在PyTorch的官方文档中查看版本兼容性信息:https://pytorch.org/get-started/locally/

设置环境变量:

确保你的系统环境变量中包含了CUDA的路径。你可以将以下路径添加到系统环境变量中(根据你的实际安装路径进行修改):

检查CUDA设备:

使用以下Python代码检查CUDA设备是否能被正确识别:

import torch

print(torch.cuda.is_available())

如果返回False,那么CUDA设备可能没有被正确识别。

使用CPU运行模型:

如果你在CPU-only的机器上运行模型,你需要在加载模型时指定设备为CPU。例如:

model = torch.load('model.pth', map_location=torch.device('cpu'))

关于问题三,虽然Win10系统可以运行PyTorch和CUDA,但是文本生成视频大模型可能会对硬件资源要求较高,包括GPU、内存和存储空间。如果你的硬件配置足够强大,理论上在Win10系统上运行这个模型是可行的。对于复杂的深度学习任务,通常推荐使用Linux操作系统,因为Linux在性能、稳定性以及与深度学习框架的兼容性方面通常表现更好。如果你在Win10系统上遇到问题,可以考虑在Linux环境下尝试运行该模型。