新版本flink1.17-1.19写入ES,官方例子报错 java.lang.IllegalStateException: The elasticsearch emitter must be serializable.

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

以下方法可能解决问题

版本兼容性:确保Flink版本与Elasticsearch版本之间兼容。不同版本的Elasticsearch可能有不同的API和期望的数据格式,因此需要确保您的Flink作业与Elasticsearch版本相匹配。

错误的写入操作:在官方例子中,确保您正确实现了写入操作。例如,使用正确的写入方法、提供了正确的Elasticsearch连接参数等。

资源限制:如果您的Flink作业在写入大量数据时耗尽了资源(如内存或CPU),可能会导致写入失败。请检查您的Flink作业配置,并确保为其分配了足够的资源。

Elasticsearch节点问题:如果Elasticsearch节点遇到问题(如宕机或网络中断),Flink作业可能会失败。请检查Elasticsearch集群的状态,并确保所有节点正常运行。

依赖问题:确保您的项目中包含了正确版本的依赖库,并且没有与其他库发生冲突。有时,库之间的版本不匹配可能导致运行时错误。

错误的日志信息:检查Flink的日志文件,查找有关错误的详细信息。日志中可能包含有关失败原因的线索,可以帮助您诊断问题所在。

自定义代码问题:如果您在官方例子的基础上进行了自定义修改,请仔细检查代码,确保没有逻辑错误或配置错误。

数据格式问题:确保您的数据格式与Elasticsearch所期望的格式相匹配。例如,确保您使用正确的字段名称、数据类型和结构。

连接问题:检查Flink与Elasticsearch之间的网络连接是否正常。确认您的Flink作业可以访问Elasticsearch的节点,并且没有防火墙或其他网络问题阻止连接。

版本兼容性:确保Flink版本与Elasticsearch版本之间兼容。不同版本的Elasticsearch可能有不同的API和期望的数据格式,因此需要确保您的Flink作业与Elasticsearch版本相匹配。

错误的写入操作:在官方例子中,确保您正确实现了写入操作。例如,使用正确的写入方法、提供了正确的Elasticsearch连接参数等。

资源限制:如果您的Flink作业在写入大量数据时耗尽了资源(如内存或CPU),可能会导致写入失败。请检查您的Flink作业配置,并确保为其分配了足够的资源。

在Apache Flink中,当你在使用Elasticsearch Sink时遇到“java.lang.IllegalStateException: The elasticsearch emitter must be serializable”这样的错误,通常是因为你的Elasticsearch Sink类或其内部使用的某些对象不是可序列化的。

为了解决这个问题,你需要确保以下几点:

Elasticsearch Sink类是可序列化的:

确保你的Elasticsearch Sink实现是java.io.Serializable。如果你继承了某个类或使用了某些对象,确保它们也是可序列化的。

使用transient关键字:

对于任何非序列化的字段或对象,使用transient关键字来标记它们。这样,在序列化时,这些字段将被忽略,而在反序列化时,它们将被重新创建。

检查依赖和库:

确保你使用的所有Flink、Elasticsearch和相关库的版本都是相互兼容的。有时候,版本不匹配可能导致序列化问题。

避免使用本地方法或匿名内部类:

如果Elasticsearch Sink类内部使用了本地方法或匿名内部类,这可能导致序列化问题。尽量避免使用它们,或者确保它们是可序列化的。

测试和验证:

在你认为已经解决了问题之后,尝试在一个简单的环境中重现问题。这可以帮助你验证解决方案是否有效,并确保没有其他隐藏的问题。

查看Flink和Elasticsearch的文档:

有时,官方文档或更新说明中可能已经提到了关于序列化的更改或注意事项。确保你遵循了所有相关的最佳实践和要求。

楼主你好,看了你的报错信息,报错java.lang.IllegalStateException: The elasticsearch emitter must be serializable的原因是elasticsearch emitter没有实现Serializable接口。具体如下所示:

因为在Flink中,所有需要在网络传输或持久化的对象都需要实现Serializable接口,以便能够在分布式环境下进行序列化和反序列化操作。

在Flink的计算环境中,所有的operator和emitter都需要是可序列化的,因为它们需要在不同的节点之间传输。

可以使用如下代码对Elasticsearch emitter的可序列化。

import java.io.Serializable;

// 假设这是你的Elasticsearch emitter类

public class SerializableElasticsearchEmitter implements Serializable {

// 实现序列化接口

}

// 在Flink中使用

public class MyElasticsearchSink extends RichSinkFunction<MyType> {

private SerializableElasticsearchEmitter emitter;

@Override

public void open(Configuration parameters) {

emitter = new SerializableElasticsearchEmitter();

// 初始化emitter...

}

@Override

public void invoke(MyType value, Context context) {

// 使用emitter发送数据到Elasticsearch...

}

}

——参考链接。

可能是由于Flink版本和ES版本不兼容导致的。建议升级Flink版本或者降级ES版本,先查看一下版本号,再看看官方介绍文档的配置

Flink 1.17-1.19版本写入ES官方例子报错的原因可能是由于Elasticsearch客户端的版本不兼容导致的。在Flink 1.17-1.19版本中,Elasticsearch客户端需要使用与Flink版本相匹配的Elasticsearch客户端库。

建议检查使用的Elasticsearch客户端库是否与Flink版本匹配,如果不匹配,请下载并使用与Flink版本相匹配的Elasticsearch客户端库。同时,还需要检查代码中是否正确配置了Elasticsearch的相关参数,例如连接地址、索引名称等。

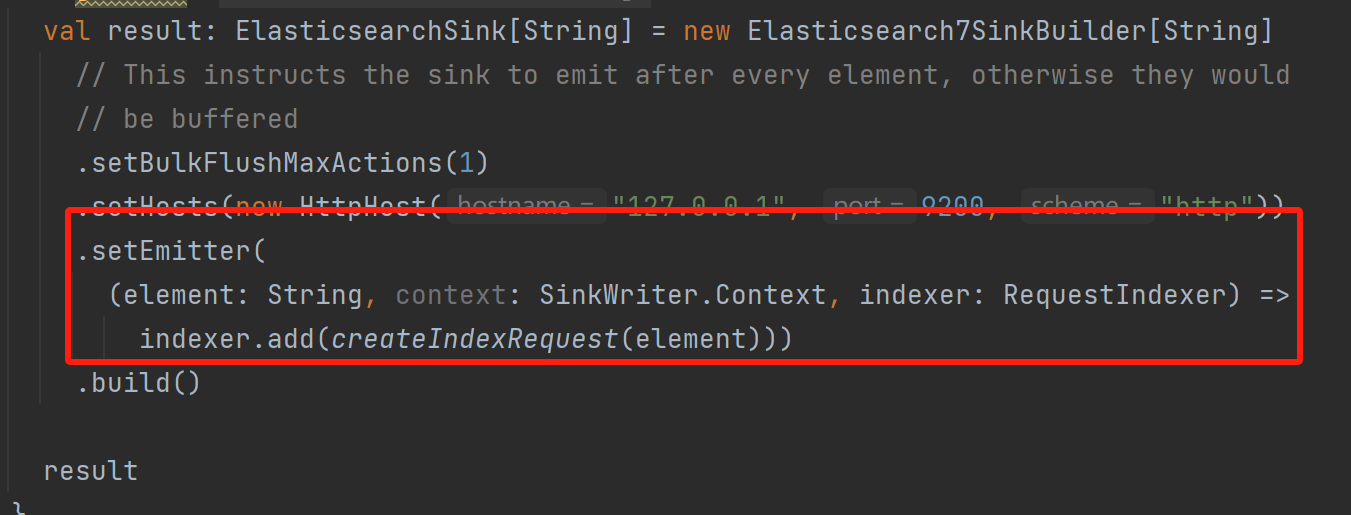

在 Flink 1.17 到 1.19 版本之间,ElasticsearchSink API 发生了一些变化,导致了你现在看到的 "The Elasticsearch emitter must be serializable." 错误。这可能是因为新的 Emitter 实现需要序列化才能工作。

解决这个问题的一种常见做法是对 SinkWriter.Context 和 RequestIndexer 对象进行序列化处理。然而,这种做法并不总是可行,因为它涉及到大量的对象状态共享以及复杂的依赖关系。

幸运的是,有一个简单的解决方案可以帮助你绕过这个问题。你可以重载 setEmitter 方法以接受一个函数作为参数,该函数负责接收来自 sink 的元素并将之转换为 Elasticsearch 请求。这种方法允许你完全控制整个流程,而不必担心序列化的复杂性。

下面是如何重构 setEmitter 方法的例子:

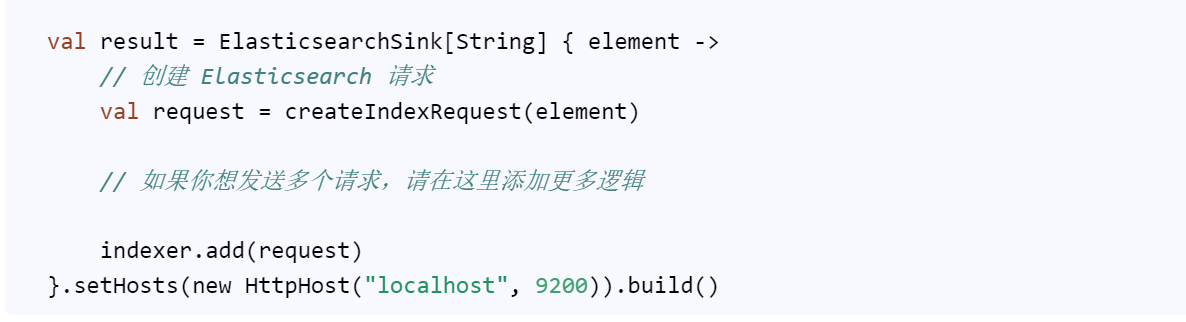

val result = ElasticsearchSink[String] { element ->

// 创建 Elasticsearch 请求

val request = createIndexRequest(element)

// 如果你想发送多个请求,请在这里添加更多逻辑

indexer.add(request)

}.setHosts(new HttpHost("localhost", 9200)).build()

现在,每次 sink 接收到来自 source 的 String 元素时,它都会自动转换为 Elasticsearch 请求并发送给 ES。这种方式消除了对序列化的需求,同时又保留了原有的功能。

问题可能是由于 ElasticsearchSink 的实现不支持序列化导致的。在 Flink 1.17 及更高版本中,ElasticsearchSink 使用了新的实现方式,要求 ElasticsearchSink 的元素必须是序列化的。而在官方例子中,可能没有正确地实现序列化。

为了解决这个问题,您可以尝试以下方法:

确保您的输出数据(String 类型)实现了序列化接口。通常,这可以通过在数据类上添加 `Serializable` 接口来实现。例如:`public class MyData implements Serializable`。

如果您使用的是 Flink 1.17-1.19,可以考虑降级到 Flink 1.16,因为在 Flink 1.16 中,ElasticsearchSink 并没有强制要求元素实现序列化。但是请注意,这可能会导致其他功能在未来的 Flink 版本中无法正常工作。

如果可能的话,尝试使用 Elasticsearch 6 或更早的版本,这样可以避免使用新的 ElasticsearchSink 实现,从而避免序列化问题。但是请注意,这可能会导致 Elasticsearch 的一些新功能无法正常工作。

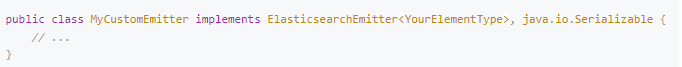

当使用 Apache Flink (1.17 - 1.19 版本) 将数据写入 Elasticsearch,并遇到 java.lang.IllegalStateException: The elasticsearch emitter must be serializable 错误时,这通常是由于 ElasticsearchSink 中使用的 Emitter 实例没有实现序列化接口造成的。

Flink 在分布式执行过程中需要能够序列化所有参与计算和状态管理的对象,包括自定义的 Emitter。Emitter 是 ElasticsearchSink 中负责构建批量请求的一个组件,在并行任务之间进行网络传输时必须能够被序列化。

要解决这个问题,请确保您自定义的 Emitter 类实现了 java.io.Serializable 接口:

public class MyCustomEmitter implements ElasticsearchEmitter<YourElementType>, java.io.Serializable {

// ...

}

如果是在使用官方提供的 ElasticsearchSink 且未自定义 Emitter 的情况下遇到此错误,则可能是因为配置或创建 ElasticsearchSink 时采用了不正确的构造方式。请确保遵循官方文档给出的例子,正确初始化 ElasticsearchSinkBuilder 并设置好必要的参数,例如:

// 创建一个 ElasticsearchSink.Builder

final ElasticsearchSink.Builder<YourElementType> esSinkBuilder = new ElasticsearchSink.Builder<>(

// 设置 Elasticsearch 集群节点列表

ElasticsearchSink.CONFIG_KEY_HOSTS, "http://localhost:9200")

.setEmitter(new ElasticsearchEmitter<YourElementType>() { ... } /* 如果有自定义的 Emitter */)

.setBulkFlushMaxActions(1000) // 设置批量大小等其他参数

.setBulkFlushInterval(MINUTES.toMillis(5)); // 设置批量刷新间隔

// 添加 ElasticsearchSink 到 Flink 程序

stream.addSink(esSinkBuilder.build());

若无自定义 Emitter,则不需要设置 .setEmitter() 部分。请检查您的代码以确认是否直接或间接导致了非可序列化的 Emitter 被传递给 ElasticsearchSink。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。