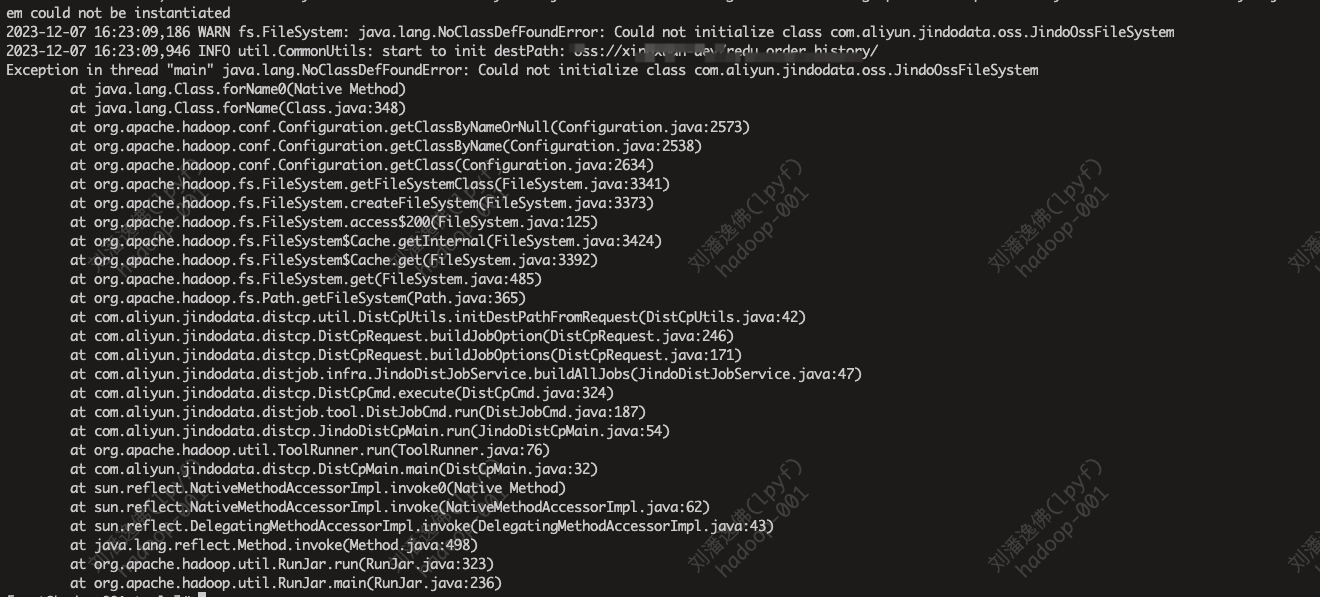

请问阿里云E-MapReduce报这个错是什么原因?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的错误信息,虽然未明确指出具体的错误内容,但结合阿里云E-MapReduce常见问题的知识库资料,我可以为您总结可能的原因及解决方案。以下是针对不同错误场景的详细分析和处理方法:

如果您的错误与ResourceManager(RM)组件的内存溢出相关,可能是以下原因导致的: - 原因:RM所在节点上的线程数达到系统上限,无法创建新线程。 - 解决方法: 1. 检查当前系统的线程数限制: bash ulimit -a | grep "max user processes" cat /proc/sys/kernel/pid_max 2. 如果线程数配置过低,调整系统配置以增加可用线程数。通常小规格节点需配置数万量级,大规格节点需配置十几万或几十万量级。 3. 如果线程数配置正常,检查是否存在个别进程占用过多线程。执行以下命令查看占用线程数最多的Top10进程: bash ps -eLf | awk '{print $2}' | uniq -c | awk '{print $2"\t"$1}' | sort -nrk2 | head 格式为:[进程ID] [占用线程数]。

如果错误与资源本地化失败或任务日志采集相关,可能是HDFS配置异常导致的。 - 现象:NodeManager(NM)日志中提示java.io.IOException: Couldn't create proxy provider class org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider。 - 解决方法: 1. 开启DEBUG级别日志以定位根因: - 在Hadoop客户端命令行环境中,设置环境变量: bash export HADOOP_LOGLEVEL=DEBUG - 在Log4j配置文件末尾添加以下内容: log4j.logger.org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider=DEBUG 2. 检查是否修改过NameServices配置(如将emr-cluster修改为hadoop-emr-cluster),并确保扩容节点时使用了正确的配置。 3. 在EMR控制台的HDFS服务配置页面,检查各项配置是否正确。

如果错误与磁盘问题相关,可能是ACL规则未满足导致的。 - 现象:访问NodeManager Log页面时提示local-dirs are bad或log-dirs are bad。 - 解决方法: - 确保远程用户符合以下任一条件: 1. 是admin用户。 2. 是app owner。 3. 满足app自定义ACL规则。

如果错误与HTTP认证相关,可能是YARN启用了Simple认证且不允许匿名访问导致的。 - 现象:访问UI或REST API时提示HTTP ERROR 401 Authentication required或HTTP ERROR 403 Unauthenticated users are not authorized to access this page。 - 解决方法: 1. 方式一:在URL参数中显式指定远程用户,例如: ?user.name=<用户名> 2. 方式二:在EMR控制台的HDFS服务配置页面,搜索参数hadoop.http.authentication.simple.anonymous.allowed,将其值修改为true以允许匿名访问,然后重启服务。

如果错误与Flink作业相关,可能是以下原因之一:

-D env.java.opts="-XX:+HeapDumpOnOutOfMemoryError -XX:HeapDumpPath=/tmp/dump.hprof"

flink-conf.yaml中添加以下配置:

env.java.opts: -XX:+HeapDumpOnOutOfMemoryError -XX:HeapDumpPath=/tmp/dump.hprof

flink-core依赖。pom.xml中将flink-core依赖的scope设置为provided:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-core</artifactId>

<version>1.16.1</version>

<scope>provided</scope>

</dependency>

version需替换为您实际使用的Flink版本。如果错误与ClickHouse内存限制相关,可能是以下原因之一:

max_server_memory_usage。机器物理内存大小 * max_server_memory_usage_to_ram_ratio。profiles.<your_profile_name>.max_memory_usage。SET max_memory_usage=xxxx。SELECT column FROM table SETTINGS max_memory_usage=xxxx;

profiles.<your_profile_name>.max_memory_usage_for_user。SET max_memory_usage_for_user=xxxx。如果错误与StarRocks相关,可能是以下原因之一:

SET is_report_success = true;

SET pipeline_dop = 8;

SET enable_pipeline_engine = true;

SET enable_pipeline_engine=false;

SET parallel_fragment_exec_instance_num=8;

be.conf中的trash_file_expire_time_sec参数,控制trash目录保留时间。默认值为259200秒(72小时)。如果您能提供更具体的错误信息,我可以进一步为您提供针对性的解决方案。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

阿里云EMR是云原生开源大数据平台,为客户提供简单易集成的Hadoop、Hive、Spark、Flink、Presto、ClickHouse、StarRocks、Delta、Hudi等开源大数据计算和存储引擎,计算资源可以根据业务的需要调整。EMR可以部署在阿里云公有云的ECS和ACK平台。