大数据计算MaxCompute看日志好像是因为这个原因,但是文档上不是写的如果超了会退回离线查询吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在MaxCompute中,日志显示的错误可能与UDF(用户自定义函数)性能问题相关。根据知识库中的描述,当UDF处理时间过长时,可能会触发超时错误,具体错误信息为ODPS-0123144: Fuxi job failed - kInstanceMonitorTimeout(errCode:252),这通常是由UDF性能问题导致的。

默认超时限制:

超时后的处理机制:

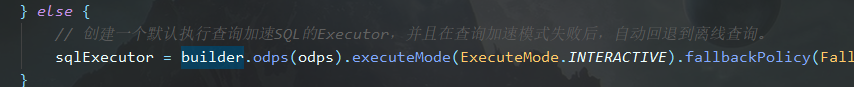

set odps.function.timeout=xxx;:增加UDF的超时时间,默认值为1800秒,最大可设置为3600秒。set odps.sql.executionengine.batch.rowcount=xxx;:减少每次处理的数据行数,默认值为1024行,可根据实际需求调小以降低单次处理的压力。您提到“文档上不是写的如果超了会退回离线查询”,但根据现有知识库内容,MaxCompute并未明确说明超时后会自动退回离线查询。实际上,超时任务会直接失败,而不是切换到离线模式。因此,建议您检查以下内容以确认问题原因: 1. UDF性能问题: - 检查UDF代码是否存在死循环或性能瓶颈。 - 在UDF中添加日志输出,记录每批数据的处理时间,定位性能问题所在。 - Python 2环境:使用sys.stdout.write('your log')和sys.stdout.flush()。 - Python 3环境:使用print('your log', flush=True)。

odps.function.timeout和odps.sql.executionengine.batch.rowcount),以适应实际计算需求。如果您仍有疑问或需要进一步的帮助,请提供更多上下文信息(如具体的日志内容或任务配置),以便更准确地分析问题。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。