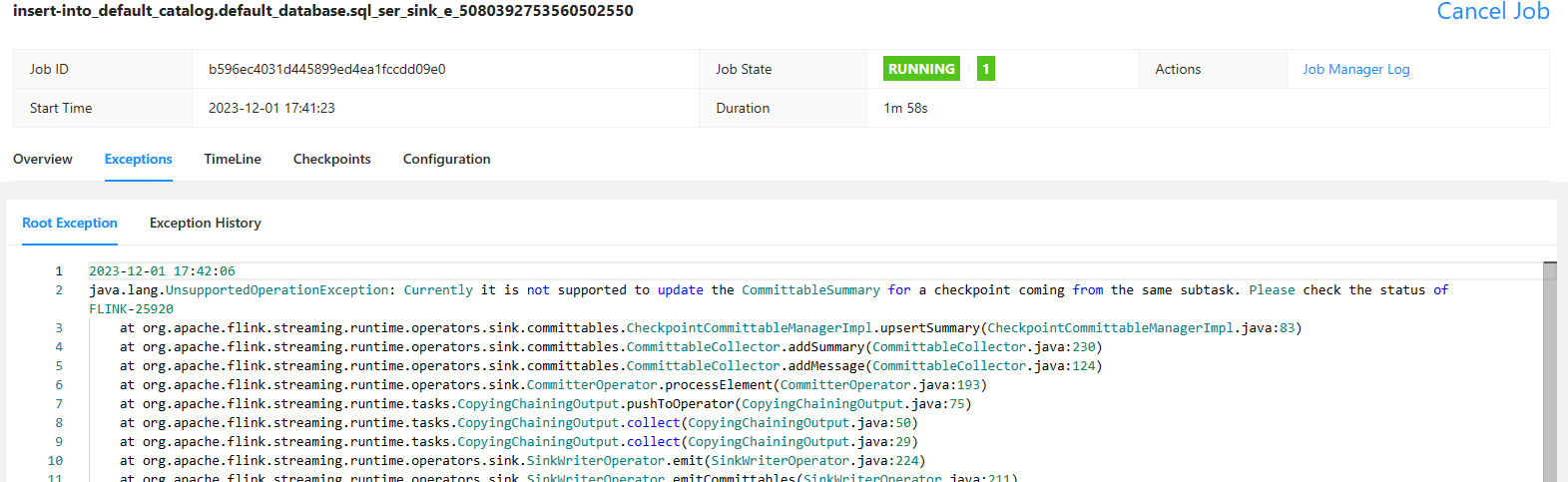

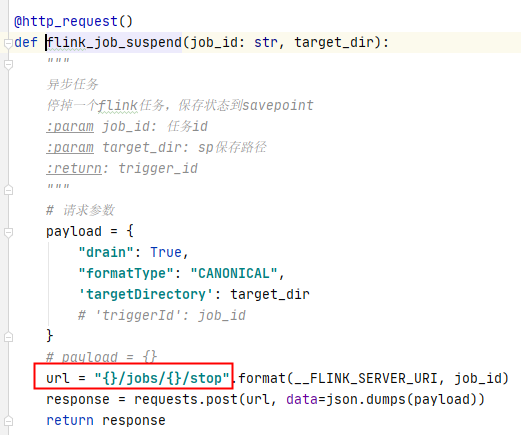

Flink CDC掉这个接口,高频率发生上面这个错误。有啥解决办法不?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的“Flink CDC掉这个接口,高频率发生上面这个错误”,虽然您未明确指出具体的错误信息,但结合知识库中的常见问题和解决方案,以下是可能的原因及对应的解决办法:

在非正常情况下(如故障发生时),CDC工具(如Canal、Maxwell、Debezium)只能保证at-least-once的投递语义,可能导致重复的变更事件被投递到Kafka中。当Flink消费这些重复事件时,可能会导致计算结果错误或异常。

table.exec.source.cdc-events-duplicate=true,并在源表上定义PRIMARY KEY。Flink会生成一个额外的有状态算子,使用主键对变更事件进行去重,并生成规范化的changelog流。

table.exec.source.cdc-events-duplicate: true

如果MySQL实例的Binlog记录了整个实例级别的变更,即使Flink只关注部分表的数据,也会读取所有表的变更记录,从而导致带宽消耗过高。

如果上游Kafka分区中有部分分区长时间无数据进入,Flink会将这些分区标记为暂时空闲,导致Watermark无法推进,窗口输出延迟。

table.exec.source.idle-timeout参数,指定分区无数据时的超时时间,使得这些分区在计算Watermark时被排除在外。

table.exec.source.idle-timeout: 1s

如果JobManager未能正常启动,可能是由于以下原因: - gRPC消息过大:作业逻辑复杂导致生成的JobGraph过大,校验报错或启停卡住。 - 资源不足:内存或CPU资源不足导致作业无法正常运行。

table.exec.operator-name.max-length: 1000

在MySQL CDC全量读取阶段,如果最后一个分片数据量过大,可能导致内存溢出(OOM)或作业卡住。

如果MySQL CDC增量阶段读取的timestamp字段时区相差8小时,可能是由于server-time-zone参数配置不正确。

server-time-zone参数,确保其与MySQL服务器的时区一致。例如:

'server-time-zone' = 'Asia/Shanghai'

如果您使用的是Debezium PostgreSQL Connector,且无法正确解析数据,可能是因为表的REPLICA IDENTITY未配置为FULL。

REPLICA IDENTITY设置为FULL:

ALTER TABLE <your-table-name> REPLICA IDENTITY FULL;

如果Flink CDC作业失败后频繁重启,可能是因为默认的重启策略未正确配置。

restart-strategy: fixed-delay

restart-strategy.fixed-delay.attempts: 2

restart-strategy.fixed-delay.delay: 10s

以上是针对Flink CDC高频错误的常见原因及解决方案。建议您根据实际错误日志,定位具体问题并采取相应的措施。如果问题仍未解决,请提供更详细的错误信息以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。