请问下大数据计算MaxCompute:有哪些比较好的优化方案呢?

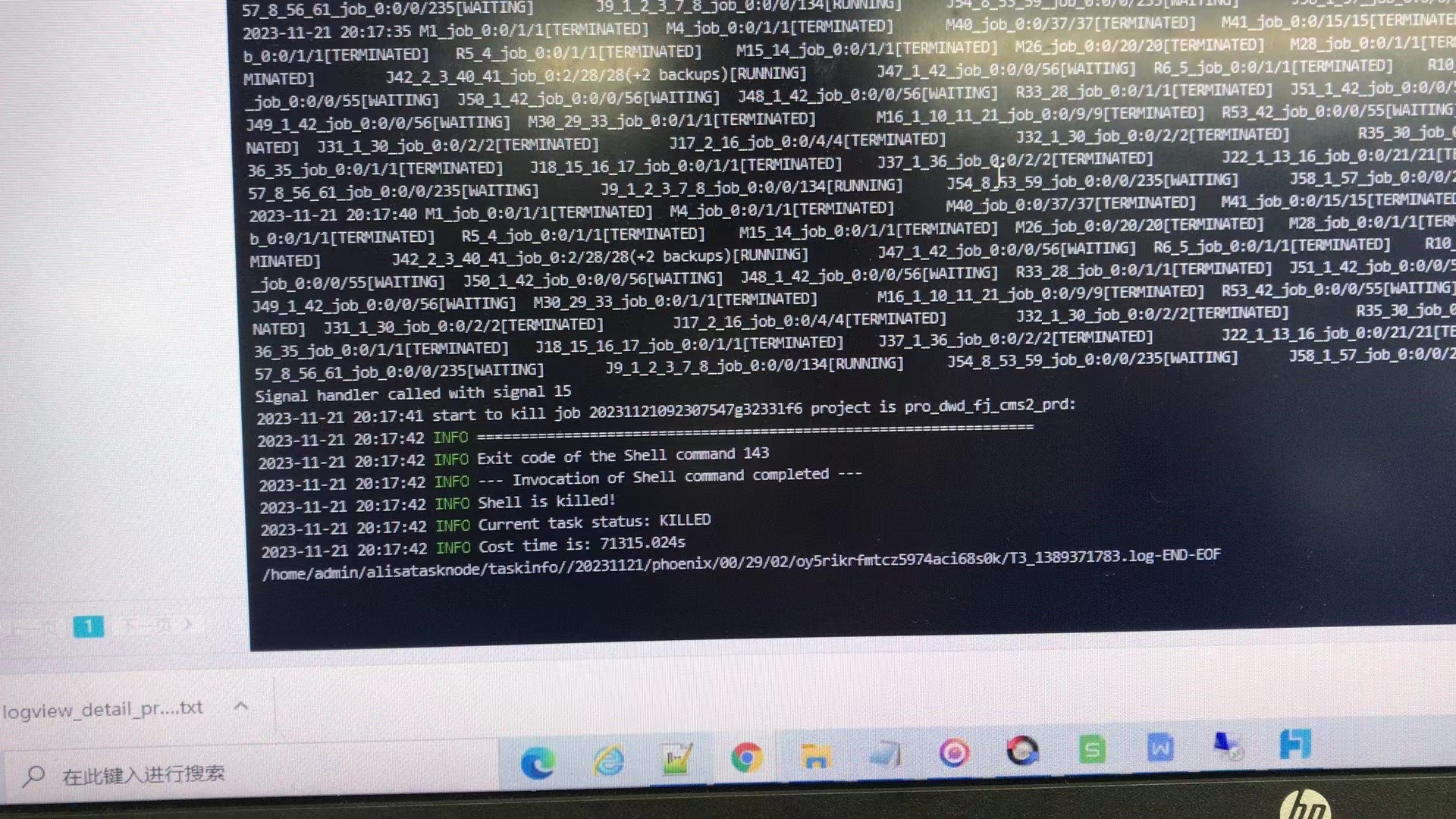

请问下大数据计算MaxCompute:数据倾斜导致JOB运行时间过长导致系统会自动kill掉job,有哪些比较好的优化方案呢?

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

2

条回答

写回答

-

2023-11-30 21:17:29赞同 展开评论

-

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

在大数据计算中,数据倾斜是指数据分布不均,在执行shuffle操作时导致某些分区的数据量远大于其他分区。这会导致处理速度变慢,从而使得整个Job的运行时间过长,甚至可能导致系统自动kill掉job。以下是一些优化数据倾斜问题的常见策略:

重新设计键(Key):

- 避免使用高基数列作为Shuffle Key,以减少热点。

- 如果可能的话,尝试找到一个更均匀分布的替代键。

自定义分区器:

- 使用自定义的分区函数来平衡数据分配,确保每个分区接收的数据量大致相同。

- 根据业务逻辑或数据特征进行分区,比如通过哈希或者取模等方法。

调整并行度:

- 调整作业的并行度,增加worker的数量,将任务分解为更多小任务。

- 对于Spark,可以设置

spark.sql.shuffle.partitions参数,控制分区数量。

聚合预处理:

- 在进行全局聚合之前,先进行局部聚合,减小需要shuffle的数据量。

数据重分布:

- 在关键步骤前对数据进行重分布,使其更均匀地分布在集群节点上。

使用Combiner:

- Combiner可以在map阶段合并部分结果,减轻reduce端的压力。

动态负载均衡:

- 利用系统的动态负载均衡机制,让系统自动重新调度任务以缓解热点。

利用广播变量和累加器:

- 对于较小的数据集,使用广播变量可以避免不必要的网络传输。

- 累加器可以帮助统计信息汇总而无需大量的shuffle。

代码优化:

- 优化算法和实现,例如尽量避免使用全局排序等昂贵的操作。

2023-11-30 13:59:26赞同 展开评论

问答标签:

问答地址:

开发者社区

>

大数据与机器学习

>

大数据计算 MaxCompute

>

问答

相关问答

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。

相关文章

热门讨论

热门文章

展开全部

还有其他疑问?

咨询AI助理