版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

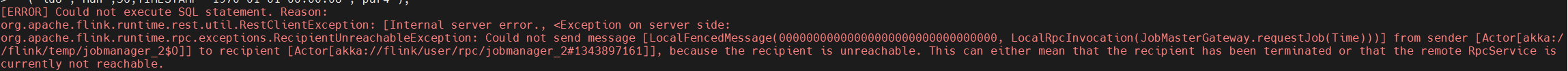

使用FlinkSQL向Hudi写入数据时遇到错误的原因可能有多种,例如:

执行Flink job,报错“Could not execute SQL statement. Reason:org.apache.flink.table.api.ValidationException: One or more required options are missing”,该如何解决?

报错原因

在StarRocks-migrate-tools(简称SMT)配置文件config_prod.conf中设置了多组规则[table-rule.1]、[table-rule.2]等,但是缺失必要的配置信息。

解决方案

检查是否给每组规则[table-rule.1]、[table-rule.2]等配置了database,table和Flink Connector信息。

https://help.aliyun.com/zh/emr/emr-on-ecs/user-guide/faq-9#section-zew-t9e-zbk

可能是由于 Flink 作业无法访问 Hudi 表导致的。

以下是一些建议,希望对您有所帮助:

state.backend: filesystem

state.backend.filesystem.path: /path/to/your/backend/directory

CopyCopy

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。