DataWorks为啥从odps同步到adb的时候,一直在 回滚,然后这个任务就 超时?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

从Odps同步到ADB的任务回滚可能有以下几个原因:

Odps到ADB的数据同步任务可能存在数据冲突。当两个或更多的任务同时更新同一行数据时,可能会导致数据不一致的问题。为了解决这个问题,DataWorks会自动回滚任务。

数据同步任务可能在处理过程中遇到了错误。这可能是由于网络问题、系统故障或其他未知错误导致的。

数据同步任务可能因为某些原因(如磁盘空间不足、内存不足等)而被中断。在这种情况下,任务也会被回滚以防止数据丢失。

为了避免这种情况,你可以尝试以下几种方法:

增加任务的超时时间。你可以在任务配置中设置"最大执行时间"和"重试次数",以允许任务在处理过程中有更多的时间来解决任何问题。

优化数据同步任务。你可以尝试优化数据同步任务,例如减少需要同步的数据量、优化数据同步的方式等,以提高数据同步的效率。

检查和修复数据冲突。如果任务因为数据冲突而回滚,你需要检查和修复数据冲突。这可能涉及到查看和修改数据的过程,可能需要一些专业知识和经验。

监控和调试任务。你可以使用DataWorks提供的监控和调试工具来监控任务的执行情况,找出导致任务回滚的原因,并进行相应的处理。

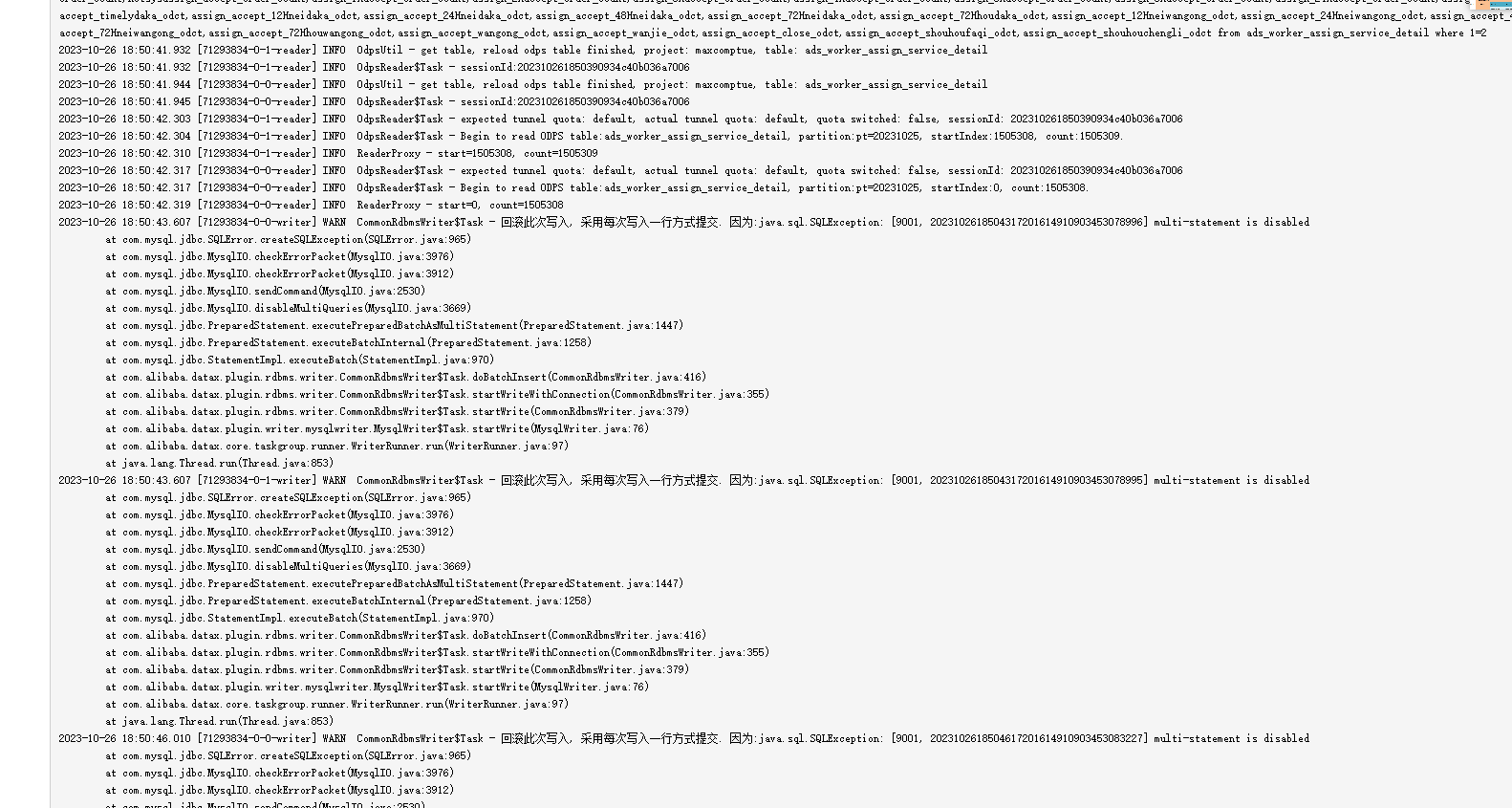

multi-statement is disabled

任务转脚本修改 "stepType":"mariadb" 试一下

看到历史问题之前分析出来的原因:adb协议层的bug, mysql 的multi stmt 的协议需要优化

也是因为这个原因 退化成单条跑了,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。