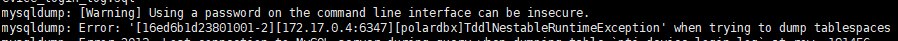

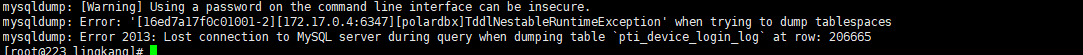

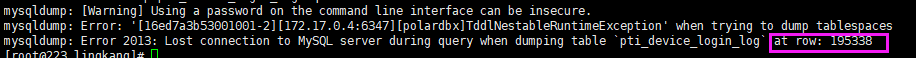

通过mysqldump命令导polardb数据时,出现这个错误,又遇到过吗?

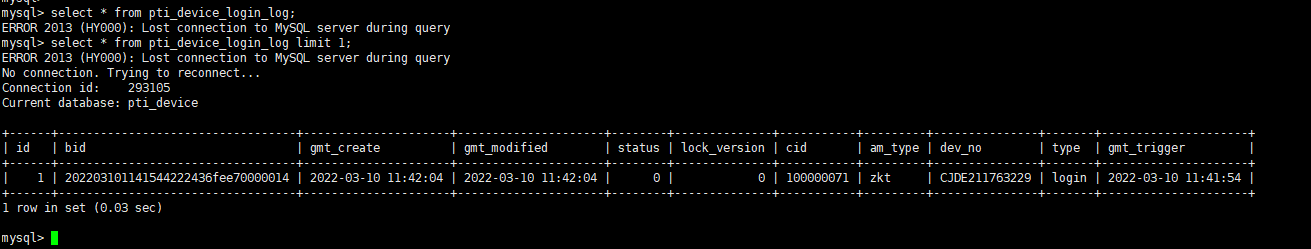

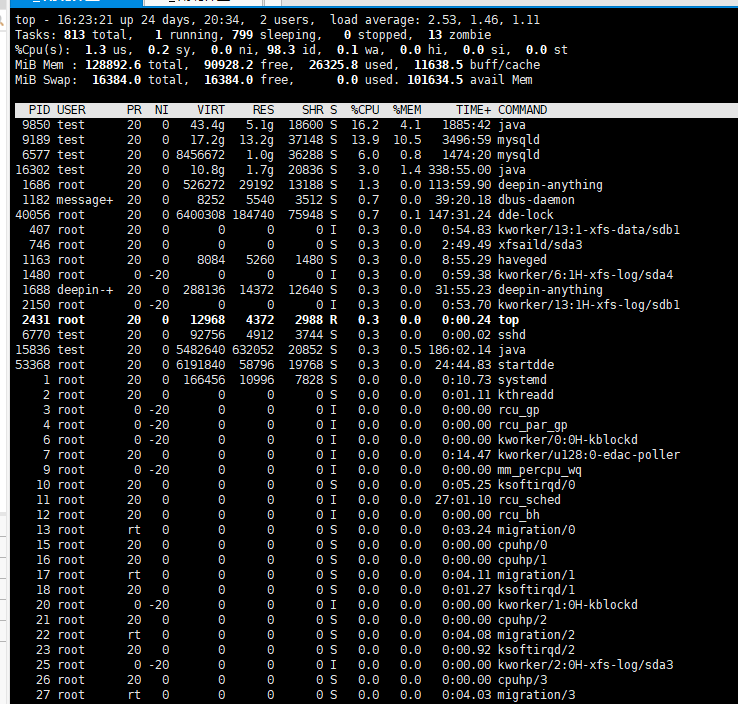

执行多次后,发现row的值再不断变.我还发现查询条数小没问题,大的话就出现错误了。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的错误现象,结合知识库中的相关资料,以下是针对问题的详细解答:

您在使用 mysqldump 导出 PolarDB 数据时遇到错误,并且发现以下特点: 1. 错误与数据量相关:查询条数较小时没有问题,但查询条数较大时出现错误。 2. row 值不断变化:执行多次后,发现 row 的值在不断增加。

根据这些现象,结合知识库中的信息,推测问题可能与 分布式 JOIN 的限制 或 内存占用过高 有关。具体来说,PolarDB 在处理分布式 JOIN 时,对右表返回的数据行数有严格的限制(默认为 5000 行),如果超出该限制,会触发 TDDL-4615 错误。

分布式 JOIN 返回数据行数超出限制

PolarDB 使用嵌套循环(Nested-loop)方式执行分布式 JOIN 时,如果右表返回的数据行数超过 5000 行,可能会导致内存占用过高,从而触发保护机制并报错。

SQL 查询复杂度较高

如果导出的 SQL 中包含复杂的 JOIN 操作或子查询,可能导致查询结果集过大,进而引发上述问题。

mysqldump 参数配置不当

如果未正确设置 net_buffer_length 或其他参数,可能导致批量插入语句过长,进一步加剧内存压力。

检查并优化 JOIN 语句

确保 SQL 查询中避免从右表返回大量数据。可以通过以下方式优化:

调整分布式 JOIN 的行数限制

如果确实需要调整右表返回的行数限制,可以在 SQL 前添加 HINT,例如:

/*!TDDL:MAX_ROW_RETURN_FROM_RIGHT_INDEX_NESTED_LOOP=5100*/ SQL

注意:调整时需评估单条记录的大小和内存占用情况,避免爆内存风险。

降低批量插入的大小

调整 net_buffer_length 参数以减小批量插入语句的大小。例如:

mysqldump -h ip -P port -u user -pPassword -default-character-set=utf8mb4 \

-net_buffer_length=10240 -no-create-info db_name > dump.sql

这将限制每条 INSERT 语句的长度,从而减少内存占用。

跳过统计信息和触发器

如果不需要导出统计信息或触发器,可以添加以下参数:

mysqldump -h ip -P port -u user -pPassword -default-character-set=utf8mb4 \

-column-statistics=0 -skip-triggers db_name > dump.sql

如果数据量较大,建议分批次导出数据。例如,通过指定表或条件来分批导出:

mysqldump -h ip -P port -u user -pPassword -default-character-set=utf8mb4 \

db_name table_name --where="id < 1000" > dump_part1.sql

重复执行类似命令,逐步完成所有数据的导出。

mysqldump 工具版本与 PolarDB 版本一致,避免因版本不匹配导致的错误。通过以上方法,您可以有效解决因数据量过大导致的导出错误问题。如果问题仍然存在,建议联系阿里云技术支持团队,提供具体的错误日志以便进一步排查。

PolarDB 分布式版 (PolarDB for Xscale,简称“PolarDB-X”) 采用 Shared-nothing 与存储计算分离架构,支持水平扩展、分布式事务、混合负载等能力,100%兼容MySQL。 2021年开源,开源历程及更多信息访问:OpenPolarDB.com/about