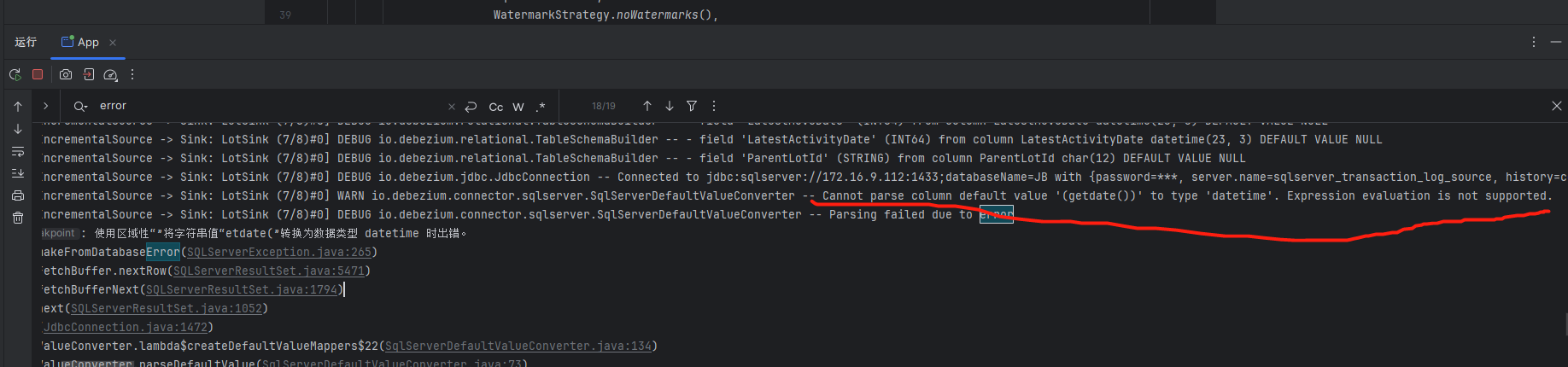

Flink CDC这个默认值无法处理怎么解决呢?

Flink CDC这个默认值无法处理怎么解决呢?

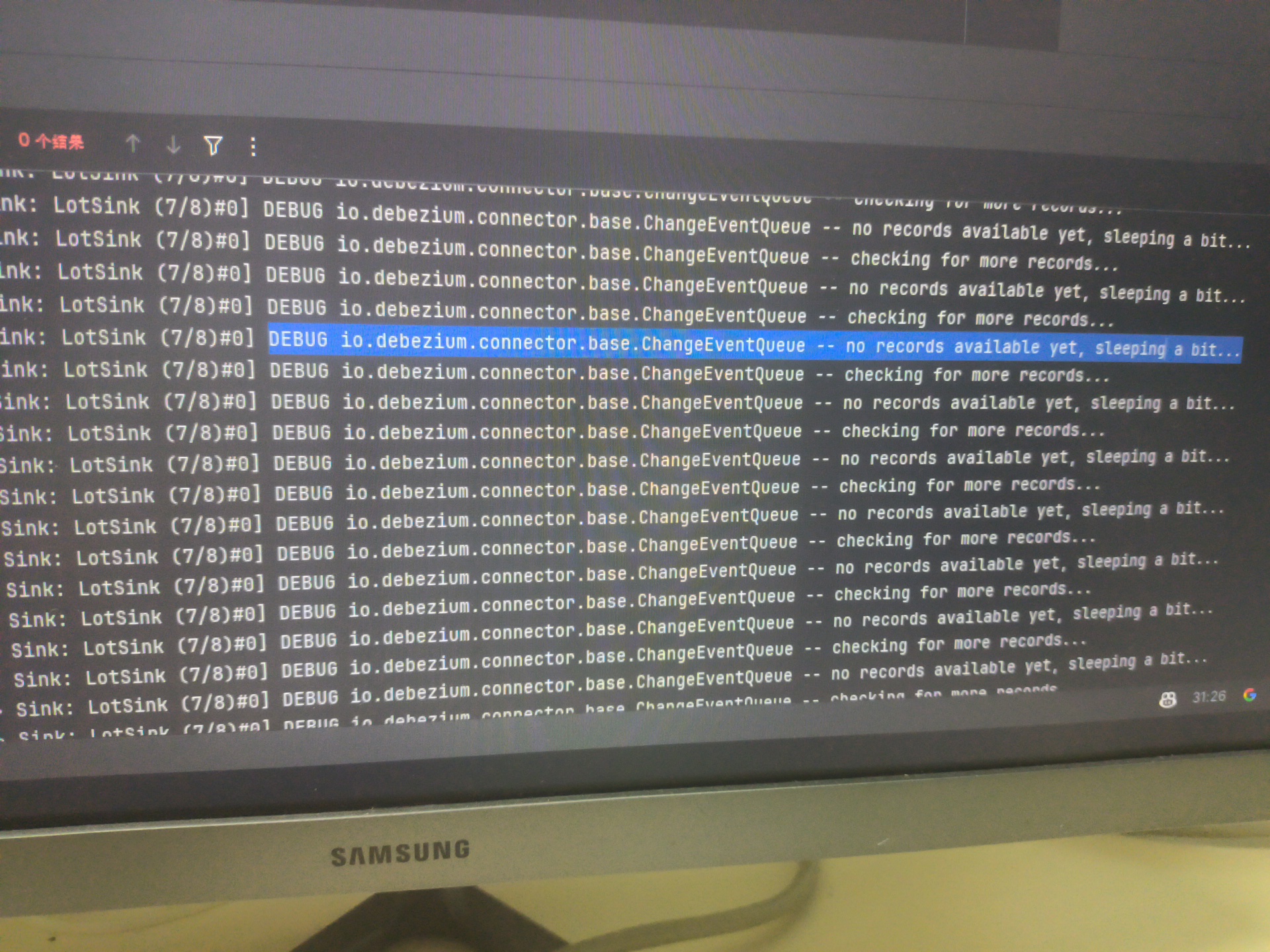

还有这个日志级别怎么修改,每秒都有上百条

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

问题1:Flink CDC默认值无法处理的解决方法

在使用Flink CDC时,如果某些默认值无法满足需求,可以通过调整相关参数来优化配置。以下是针对常见问题的解决方案:

1. 心跳包时间间隔(heartbeat.interval.ms)

- 问题描述:默认值为30秒(30s),可能在表变更不频繁时导致WAL日志回收延迟。

- 解决方法:

- 调整

heartbeat.interval.ms参数,设置更短的时间间隔以及时推进Slot偏移量。 - 示例配置:

heartbeat.interval.ms: 10s - 注意:过短的心跳间隔可能会增加网络和数据库负载,请根据实际场景权衡。

- 调整

2. 快照切分列(scan.incremental.snapshot.chunk.key-column)

- 问题描述:默认从主键中选择第一列作为切分列,可能导致数据分布不均或性能瓶颈。

- 解决方法:

- 明确指定某一列为切分列,确保数据均匀分布。

- 示例配置:

scan.incremental.snapshot.chunk.key-column: "your_column_name" - 建议:选择高基数列(如唯一标识列)作为切分列,避免热点问题。

3. 全量阶段日志读取(scan.incremental.snapshot.backfill.skip)

- 问题描述:默认值为

false,即全量阶段会读取低水位线和高水位线之间的日志,可能导致资源消耗较高。 - 解决方法:

- 如果下游支持幂等性,可以设置为

true,跳过全量阶段日志读取。 - 示例配置:

scan.incremental.snapshot.backfill.skip: true - 注意:此配置仅提供至少一次(At-Least Once)语义保证,需确保下游系统能够处理重复数据。

- 如果下游支持幂等性,可以设置为

问题2:日志级别修改方法及高频日志处理

1. 动态修改日志级别

阿里云实时计算Flink版支持动态修改日志级别,具体操作步骤如下:

修改Job Manager日志级别: 1. 登录阿里云实时计算控制台。 2. 单击目标工作空间操作列下的“控制台”。 3. 在左侧导航栏选择“运维中心” > “作业运维”。 4. 单击目标作业名称。 5. 单击“作业日志”。 6. 在“运行日志”页签,选择正在运行的作业实例。 7. 在“Job Manager”页签,单击“日志”。 8. 单击“编辑”,在下拉框中选择目标日志级别(如DEBUG或INFO)。 9. 单击“确定”完成修改。

修改Task Managers日志级别: 1. 在“运行Task Managers”页签,单击“Path, ID”。 2. 单击“日志”。 3. 单击“编辑”,在下拉框中选择目标日志级别。 4. 单击“确定”完成修改。

注意事项: - 日志级别设为DEBUG后,会打印DEBUG、INFO、WARN、ERROR级别的日志。 - 设为INFO后,仅打印INFO、WARN、ERROR级别的日志。 - 修改日志级别仅影响新输出的日志,不影响已输出的日志。 - 重要提醒:开启DEBUG日志可能对作业性能产生轻微影响,无特殊需求时建议设为INFO。

2. 高频日志处理建议

如果每秒有上百条日志输出,可能会影响系统性能和日志可读性。以下是一些优化建议:

-

调整日志级别:

- 将日志级别从

DEBUG调整为INFO,减少不必要的日志输出。 - 如果必须使用

DEBUG,建议仅在定位问题时临时开启,并在问题解决后恢复为INFO。

- 将日志级别从

-

配置日志过滤规则:

- 使用

log4j2的ThresholdFilter为不同存储配置不同的日志级别。例如:- 控制台仅输出

INFO及以上级别的日志。 - 日志服务(SLS)仅输出

ERROR及以上级别的日志。

- 控制台仅输出

- 示例配置:

<Appender name="Console" type="Console"> <ThresholdFilter level="INFO" onMatch="ACCEPT" onMismatch="DENY"/> <Layout type="PatternLayout" pattern="%d{yyyy-MM-dd HH:mm:ss,SSS}{GMT+8} %-5p %-60c %x - %m%n" charset="UTF-8"/> </Appender>

- 使用

-

优化日志存储:

- 将日志输出到外部存储(如OSS、SLS或Kafka),避免本地日志文件过大。

- 配置项目空间下所有作业的日志默认输出路径,集中管理日志。

通过上述方法,您可以有效解决Flink CDC默认值无法处理的问题,并优化日志级别和高频日志的管理。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。