大数据计算MaxCompute百万级的数据更新,效率快不?

大数据计算MaxCompute百万级的数据更新,效率快不?我一个小时产生100万运行数据,我update方式更新运行数据,不清楚效率咋样?

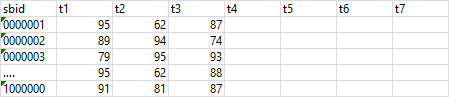

我的目标表是这种格式,1小时更新1列数据到对应的列,数据量在百万级以上,要求分钟级接入,有什么好的方法不?我目前的方法是update,update应该可以吧?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

公众号:网络技术联盟站,InfoQ签约作者,阿里云社区签约作者,华为云 云享专家,BOSS直聘 创作王者,腾讯课堂创作领航员,博客+论坛:https://www.wljslmz.cn,工程师导航:https://www.wljslmz.com

对于百万级的数据更新,MaxCompute的效率通常是较高的。MaxCompute是阿里云提供的大规模数据处理和分析服务,具备良好的水平扩展性和计算能力。

在MaxCompute中,使用UPDATE语句进行数据更新是一种常见的方式。你可以通过UPDATE语句将新生成的数据更新到目标表的对应列中。根据你的需求,每小时更新100万行数据,这个规模对于MaxCompute来说是可以处理的。

MaxCompute的计算引擎会根据数据量的大小和计算任务的复杂度来自动调整资源分配,以实现高效的数据处理。同时,MaxCompute还支持并行计算和分布式处理,能够充分利用集群资源,提高计算效率。

在使用MaxCompute进行数据更新时,建议合理设计数据表结构和分区策略,以便更好地利用MaxCompute的分布式计算能力。此外,你还可以考虑使用MaxCompute的数据导入功能,将新生成的数据批量导入到目标表中,以进一步提高更新效率。

2023-10-24 23:57:21赞同 展开评论 -

月移花影,暗香浮动

MaxCompute是阿里巴巴提供的大数据计算服务,其具备快速、完全托管的PB/EB级数据仓库解决方案,并拥有万台服务器扩展能力和跨地域容灾能力。这项服务支撑每日百万级作业规模,可以更快速的解决用户海量数据计算问题,有效降低企业成本,并保障数据安全。

它适用于TB、PB和EB等各个数量级的数据查询场景,并在业界具有较大的性能优势。为了验证其性能,MaxCompute基于提供的公开数据集及测试工具进行了大数据基准测试,例如TPC-DS。

因此,当涉及到百万级的数据更新时,由于MaxCompute的强大性能和扩展能力,它应可以提供相对较高的速度和效率。然而,具体的效率也会受到许多因素的影响,包括数据的具体情况、所使用的处理模型、网络状况等。在实际操作中,建议您根据具体情况进行测试和优化。

2023-10-20 11:08:22赞同 展开评论 -

在MaxCompute中,百万级的数据更新效率会受到以下因素的影响:

- 数据库连接池的大小:如果你的数据库连接池的大小足够大,那么你可以在不创建新的数据库连接的情况下更新数据。这可以提高数据更新的效率。

- 数据更新的类型:如果你的数据更新是简单的数据更新,例如更新一行数据的某个字段的值,那么数据更新的效率会比较高。但是,如果你的数据更新是复杂的操作,例如插入、删除或合并数据,那么数据更新的效率会比较低。

- 数据更新的频率:如果你的数据更新频率很高,那么数据更新的效率会比较低。因为每次数据更新都需要消耗一定的系统资源,如果数据更新频率很高,那么系统资源的消耗就会很大。

在你的情况下,如果你的数据更新是简单的数据更新,例如更新一行数据的某个字段的值,那么使用update方式更新数据的效率会比较高。但是,如果你的数据更新频率很高,那么数据更新的效率会比较低。因此,你可能需要考虑如何降低数据更新的频率,以提高数据更新的效率。

2023-10-19 22:02:41赞同 展开评论 -

对于MaxCompute来说,更新百万级的数据是可以的,但是具体的效率取决于许多因素,包括数据的分布、表的分区策略、查询的复杂性等。一般来说,如果数据分布在多个节点上,并且使用了适当的分区策略,那么更新百万级的数据应该是可以接受的。

然而,如果你的数据量非常大,并且你需要频繁地进行更新,那么你可能需要考虑其他的解决方案。例如,你可以使用DI任务来处理数据,而不是直接更新表。DI任务可以让你更灵活地控制数据的写入过程,例如,你可以使用DI任务来检查数据的完整性,或者在数据写入失败时进行重试。

虽然MaxCompute可以处理大量的数据,但是如果你的数据量非常大,并且你需要频繁地进行更新,那么你可能需要考虑其他的解决方案。

2023-10-19 15:48:42赞同 展开评论 -

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

MaxCompute在处理大规模数据时具有较高的效率。由于MaxCompute使用了分布式计算技术,因此可以并行处理大量数据,从而大大提高数据处理的效率。此外,MaxCompute还支持多种数据处理工具和语言,如Java、Python和Scala,这些工具和语言可以进一步提高数据处理的效率。因此,如果您的数据量达到百万级,MaxCompute应该可以提供较高的数据处理效率。但是具体的效率可能会因数据量、处理任务和硬件配置等因素的不同而有所不同,

2023-10-19 13:45:29赞同 展开评论 -

MaxCompute 普通表不支持update,只有事务表才可以进行update。

效率具体看update值的多少,如果是百万行insert很快,分钟级。update可以,1小时一次。,此回答整理自钉群“MaxCompute开发者社区2群”2023-10-19 07:44:01赞同 展开评论

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。