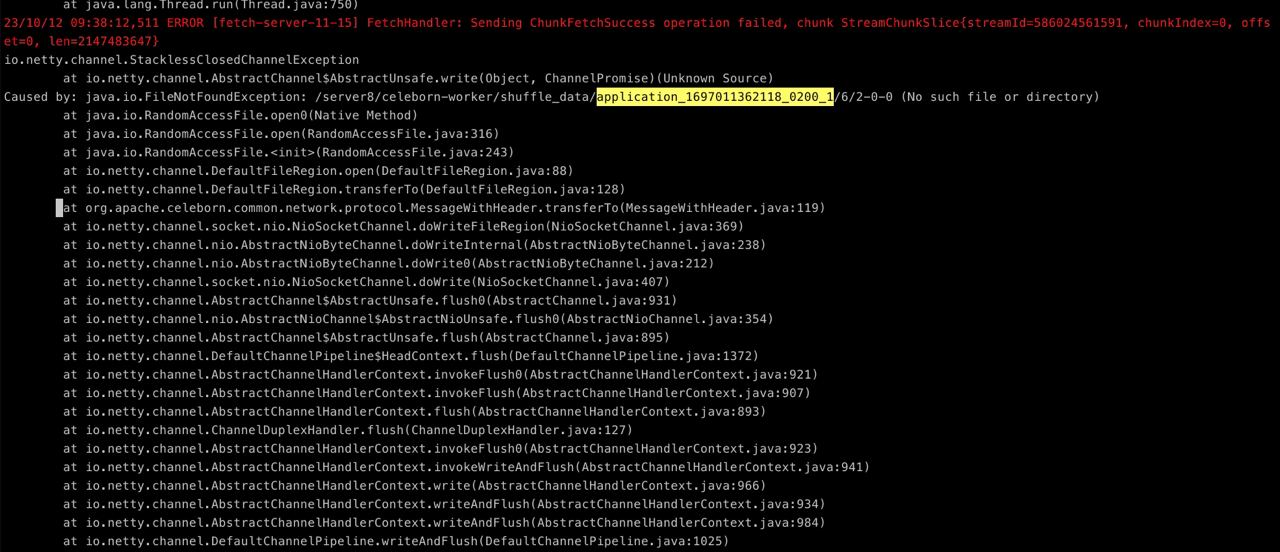

我在集成celeborn的时候,使用kyuubi提交spark3.0版本的任务有的sql会有报错,100%复现,用命令行提交就没问题。

spark3.0.1 kyuubi1.7 celeborn0.3.1

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

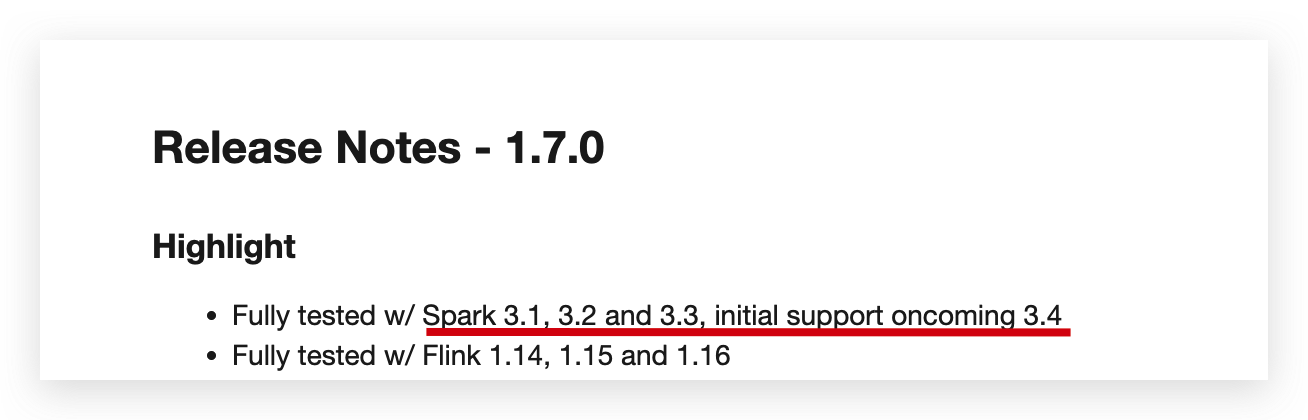

Kyuubi 1.7 移除了 Spark 3.0 的支持,代码层面的兼容移除了。

Kyuubi 用到的 API 里,3.0 有很多需要特殊处理。另外 x.0 一般来说不适合大规模应用,我们在 3.0 仅经历过非常短的实验,就迅速过渡到了 3.1

1.6.0 是标记 3.0.0 EOL

https://github.com/apache/kyuubi/issues/2974

1.7.0 里至少这个 PR 会直接破坏 3.0 的兼容

https://github.com/apache/kyuubi/pull/4318

此答案来自钉钉群“【2】Apache Flink China 社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。