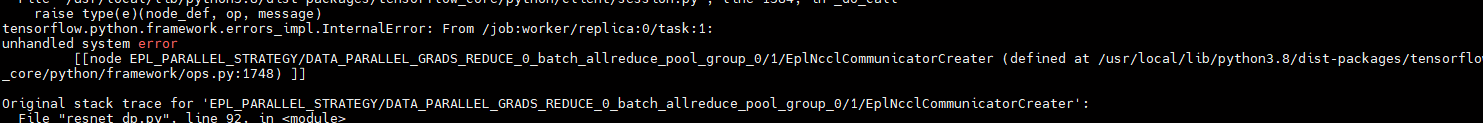

机器学习PAI中epl运行官方示例报错是什么原因,单机单卡可以,但是多卡就报错了,运行命令是epl-launch --num_workers 2 --gpu_per_worker 1 scripts/train_dp.sh?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在机器学习PAI中使用EPL(Efficient Parallel Library)运行官方示例时,如果单机单卡可以正常运行,但在多卡环境下报错,可能的原因和解决方案如下:

多卡运行时,需要确保每张GPU的资源分配合理。如果显存或计算资源不足,可能会导致任务失败。

原因分析:

在多卡模式下,epl-launch会根据--num_workers和--gpu_per_worker参数分配资源。如果某些GPU的显存或计算资源被其他任务占用,或者分配的资源不足以支持模型运行,则会导致错误。

解决方案:

nvidia-smi

batch_size或使用混合精度训练。NVIDIA_VISIBLE_DEVICES环境变量正确配置,避免多卡冲突。例如:export NVIDIA_VISIBLE_DEVICES=0,1

多卡运行通常依赖分布式通信库(如NCCL),如果通信配置不正确,可能会导致任务失败。

原因分析:

多卡运行时,EPL会通过分布式通信库(如NCCL)进行数据同步。如果网络配置或通信协议存在问题,可能会导致通信失败。

解决方案:

export NCCL_DEBUG=INFO

export NCCL_SOCKET_IFNAME=eth0

nvidia-smi topo -m

AMP_VGPU_ENABLE和GPU_MEM_PER_DEVICE等环境变量已正确设置。EPL对多卡运行的支持可能依赖于特定的代码实现。如果代码未正确适配多卡模式,可能会导致错误。

原因分析:

官方示例可能默认针对单卡运行进行了优化,未完全适配多卡模式。例如,模型的并行策略、数据分片逻辑等可能需要额外调整。

解决方案:

scripts/train_dp.sh脚本中的参数配置,确保其支持多卡运行。例如,确认--num_workers和--gpu_per_worker参数与模型的并行策略匹配。forward函数和数据加载器支持分布式训练。例如,使用torch.distributed或horovod进行分布式初始化。某些硬件限制可能导致多卡运行失败,例如GPU之间的NVLink或PCIe带宽不足。

原因分析:

如果GPU之间的通信带宽不足,可能会导致数据同步失败。例如,NVLink或PCIe的接收/发送数据量达到上限。

解决方案:

NVLink接收数据量和PCIE发送数据量。gn5-c8g1.2xlarge升级到gn6v-c16g1.4xlarge。如果上述方法无法解决问题,建议通过日志进一步分析错误原因。

CUDA error: too many resources requested for launch的报错。多卡运行失败的原因可能涉及资源分配、分布式通信、代码兼容性和硬件限制等多个方面。建议按照以下步骤逐一排查: 1. 检查GPU资源是否充足,并调整显存分配。 2. 配置NCCL环境变量,确保分布式通信正常。 3. 确认代码和脚本支持多卡运行。 4. 检查硬件通信链路是否存在瓶颈。 5. 通过日志分析具体错误原因,并针对性解决。

如果问题仍未解决,可以联系阿里云技术支持团队,提供详细的日志信息以便进一步排查。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。