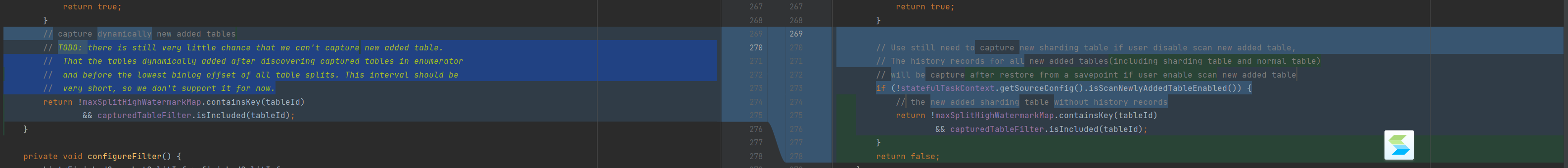

Flink CDC这里的这个修改是出于什么考虑,这个英文注释我看不懂?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Flink CDC中的某些修改通常是为了提升系统的性能、兼容性或易用性。根据您提到的“英文注释看不懂”的问题,结合知识库中的信息,以下是可能的原因和背景分析:

在Flink SQL中,字段的修改(如新增字段或调整字段逻辑)可能会对下游算子产生影响。例如: - 新增字段:如果新增字段未被下游Query使用,则属于完全兼容变更。这种修改不会影响现有作业的状态或结果。 - 字段逻辑调整:例如将字段b改为b as d + 1,这属于部分兼容变更。虽然某些计算(如max(c))不受影响,但涉及sum(b)的状态数据会被丢弃,并重新开始计算。

这种设计的目的是为了确保在字段变更时,系统能够尽可能保持兼容性,同时避免因状态不一致导致的数据错误。

修改Watermark间隔被认为是完全兼容变更。这是因为Watermark主要用于事件时间的处理,调整其间隔不会直接影响状态数据或下游算子的逻辑。这种修改可能是为了优化延迟或吞吐量。

修改Primary Key或WITH参数中的分片列可能导致Source状态的兼容性问题。例如: - 在MySQL-CDC场景中,如果scan.incremental.snapshot.chunk-key-column发生变化,全量阶段的状态可能无法复用。 - 这种修改通常是为了支持更灵活的数据分片策略,但需要用户注意可能带来的状态丢失风险。

Changelog模式的变化可能会影响下游有状态节点的兼容性。例如: - 修改Hologres连接器的cdcMode参数(是否采用CDC读取Binlog)或MongoDB/Postgres的读取方式(Upsert vs Retract),会导致发送给下游的消息类型发生变化(如Delete、Update_before、Update_after等)。 - 这种修改可能是为了适配不同的下游系统需求,但需要用户评估对现有作业的影响。

Flink CDC企业版在技术上进行了多项优化,包括高可靠性、高性能和易用性等方面的改进。例如: - 断点续传:确保数据传输的完整性和一致性。 - 增量快照算法:支持并发读取海量历史数据,并自动切换到增量读取。 - 通用增量Checkpoint(GIC):提升了Checkpoint的处理速度和稳定性,特别是在大状态场景下显著降低了断流时间。

这些优化可能是为了应对大规模数据同步场景下的性能瓶颈和稳定性挑战。

Flink CDC 3.0引入了YAML数据摄取作业开发,进一步增强了流式ETL的能力。例如: - 支持通过transform模块进行数据转换(如列裁剪、计算列、过滤条件等)。 - 支持通过route模块灵活指定上下游映射关系。

这种修改可能是为了简化复杂数据管道的配置和管理,同时提升开发效率。

综上所述,Flink CDC中的修改通常是为了提升系统的性能、兼容性和易用性,同时满足不同业务场景的需求。如果您能提供具体的英文注释内容,我可以进一步为您解读其含义。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。