Flink系统时间是北京时间,但是flink窗口在北京时间的基础上+8了,咋解决?各种配置没有用

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

楼主你好,如果在使用阿里云 Flink 时遇到系统时间与窗口计算时间的不一致问题,可以检查系统时区设置,确保系统时区设置正确,设置为北京时间或者与北京时间一致。

还需要检查 Flink 时区配置,在 Flink 的配置文件中(如 flink-conf.yaml),确保配置了正确的时区。可以通过设置 env: TZ: "Asia/Shanghai" 来将 Flink 的时区设置为上海时区(与北京时间一致)。

如果你在使用 Flink 时发现系统时间是北京时间,但窗口计算是基于北京时间+8小时(即东八区时间),这可能是因为你的程序中存在时区设置的问题。要解决这个问题,你可以按照以下步骤操作:

1、 检查时区设置:

* 确保你的 Flink 程序中没有对时区进行错误的设置。例如,在代码中可能有类似 `TimeZone.setDefault` 的设置,它可能被设置为东八区时间。

2、 使用正确的时区:

* 如果你的程序中确实有设置时区的代码,确保它使用的是正确的时区。例如,如果你想使用北京时间,应该使用 `TimeZone.getTimeZone("Asia/Shanghai")` 或其他适当的时区标识符。

3、 使用 Flink 的时区函数:

* Flink SQL 中提供了处理时区的函数,如 `TUMBLE`, `HOP` 和 `SESSION` 等。你可以在这些函数中明确指定时区,确保时间窗口的计算是基于正确的时区。

4、 检查 Flink 配置:

* 确保 Flink 的配置文件(如 `flink-conf.yaml`)中没有错误的时区设置。特别是与时区相关的配置项,如 `timezone` 等。

5、 外部系统影响:

* 如果你的 Flink 程序是从外部系统(如 Kafka)获取事件时间戳的,请确保这些系统发送的时间戳是在正确的时区。

6、 测试和验证:

* 在更改任何设置或代码后,都要进行彻底的测试,以确保问题已解决,并且结果符合预期。

通过上述步骤,你应该能够诊断并解决 Flink 时区设置的问题,确保时间窗口的计算是基于正确的时区。

如果在Flink系统中,系统时间是北京时间,但窗口计算是基于北京时间+8小时的时间,那么可能是由于Flink的时间处理机制引起的。Flink使用UTC时间作为默认时间,但也可以通过配置来使用其他时区的时间。

要解决这个问题,可以尝试以下几个方案:

配置时区:检查Flink的配置文件,确保时区设置正确。在Flink的配置文件(例如flink-conf.yaml)中,找到与时间相关的配置项,并确保时区设置为您所在的时区。例如,将timezone配置项设置为Asia/Shanghai表示使用上海时区。

使用WindowedStream:在Flink中,可以通过使用WindowedStream来处理时间相关的操作。WindowedStream提供了对时间窗口的支持,可以用于计算基于时间窗口的数据流。在使用WindowedStream时,需要指定时间窗口的参数,包括窗口的长度、滑动距离等,以确保计算是基于正确的时间范围。

使用Watermark机制:Flink中的Watermark机制用于处理时间延迟的数据流。如果数据流中的时间戳不准确或存在延迟,可以使用Watermark来调整时间戳,以确保窗口计算是基于正确的时间点。

检查数据源:如果数据源中的时间戳存在问题,可能会导致窗口计算不正确。请检查数据源中的时间戳是否正确,并确保它们与Flink系统中的时间一致。

升级Flink版本:如果您使用的是较旧的Flink版本,可能会存在一些已知的问题或缺陷。考虑升级到最新版本的Flink,以获得更好的性能和稳定性。

总之,要解决Flink系统中时间不一致的问题,需要仔细检查Flink的配置、数据源以及时间处理机制。根据实际情况选择合适的方案,并参考Flink社区的文档和资源来解决问题。

如果Flink系统的时区设置为北京时间,而窗口定义又基于北京时间增加了8小时,那么在处理数据时可能会产生时间上的偏差。为了解决这个问题,可以考虑以下几种方法:

timeZone属性来更改时区。请注意,上述方法中的选择取决于具体的应用场景和需求。根据您的实际情况,选择适合您的方法来解决时间偏差问题。

1、flink端不做处理。也即是在读取数据的时候加上8小时的offset。

例如通过注入时间来解决:

CREATE VIEW view_table AS

SELECT

id,

-- 通过注入时间解决

-- 加上东八区的时间偏移量,设置注入时间为时间戳列

CAST(CURRENT_TIMESTAMP AS BIGINT) * 1000 + 8 * 60 * 60 * 1000 as ingest_time

FROM

source_table;

2、使用udf等算子给时间戳加上8小时的offset。

sink端处理

import org.apache.flink.table.functions.ScalarFunction;

import java.sql.Timestamp;

import java.text.ParseException;

import java.text.SimpleDateFormat;

import java.util.Date;

import java.util.TimeZone;

public class UTC2Local extends ScalarFunction {

public Timestamp eval(Timestamp s) {

long timestamp = s.getTime() + 28800000;

return new Timestamp(timestamp);

}

}

注册udf

tEnv.registerFunction("utc2local",new UTC2Local());

使用udf

Table table1 = tEnv.sqlQuery("select count(number),utc2local(TUMBLE_END(proctime, INTERVAL '1' HOUR)) from res group by TUMBLE(proctime, INTERVAL '1' HOUR)");

3、sink内部做处理。

sink端的实现也比较简单,主要是判断输出字段类型,然后加上8小时offset即可。可以参考blink的printtablesink的实现。

override def invoke(in: JTuple2[JBool, Row]): Unit = {

val sb = new StringBuilder

val row = in.f1

for (i <- 0 to row.getArity - 1) {

if (i > 0) sb.append(",")

val f = row.getField(i)

if (f.isInstanceOf[Date]) {

sb.append(DateTimeFunctions.dateFormat(f.asInstanceOf[JDate].getTime, "yyyy-MM-dd", tz))

} else if (f.isInstanceOf[Time]) {

sb.append(DateTimeFunctions.dateFormat(f.asInstanceOf[JDate].getTime, "HH:mm:ss", tz))

} else if (f.isInstanceOf[Timestamp]) {

sb.append(DateTimeFunctions.dateFormat(f.asInstanceOf[JDate].getTime,

"yyyy-MM-dd HH:mm:ss.SSS", tz))

} else {

sb.append(StringUtils.arrayAwareToString(f))

}

}

if (in.f0) {

System.out.println(prefix + "(+)" + sb.toString())

} else {

System.out.println(prefix + "(-)" + sb.toString())

}

}

——参考链接。

在Apache Flink中,系统的水印生成和窗口分配通常是基于事件时间(event time)处理的,而事件时间戳的解析和时区处理是关键环节。如果您发现Flink的窗口处理时间在北京时间基础上加了8小时,这很可能是因为事件时间戳没有正确解析或设置了错误的时区。

要解决这个问题,请按照以下步骤排查和解决:

检查源数据的时间戳格式和时区

确认从源系统(如MySQL、PostgreSQL等)导出的时间戳是否已经包含了时区信息,如果没有,需要在Flink Source Connector中配置正确的时区转换。

配置Source Connector

如果您使用的是Flink CDC或者其他Connector,确保在连接器配置中正确设置了提取时间戳的时区。例如,在MySQL CDC connector中,可能会有关于时区的配置选项,确保将其设置为“Asia/Shanghai”。

Watermark生成和时间戳分配器

确保在定义Watermark策略时,时间戳分配器(Timestamp Assigner)能够正确解析事件时间戳并将其实例化为对应北京时间的Timestamp对象。

对于自定义的AssignerWithPunctuatedWatermarks或AssignerWithPeriodicWatermarks,请确保在解析时间戳时考虑时区因素。

如果使用的是内置的时间戳和水印生成机制,也要检查是否正确设置了处理时间戳时的时区上下文。

Flink Runtime配置

尽管不太常见,但也应该检查Flink集群的全局时区设置,尽管Flink一般不依赖系统时区进行时间戳处理,但在某些特定情况下也可能受到影响。

应用程序代码

检查您的应用程序代码中是否有任何手动转换或处理时间戳的地方,确认没有额外增加8小时的偏移。

如果上述常规检查和配置都正确无误,但问题依然存在,可能需要进一步详细审查Flink作业的日志、数据样本以及具体代码实现,以找出导致时区偏差的具体原因。

要解决Flink系统时间是北京时间,但是窗口在北京时间的基础上+8的问题,可以尝试以下方法:

检查系统时区设置:确保Flink集群的操作系统时区设置为正确的北京时间。可以通过查看系统设置或使用命令行工具来检查和更改时区设置。

配置Flink任务时区:在Flink任务中显式指定时区,以确保窗口操作使用正确的时区。可以使用TimeZone类来指定时区,例如:

import org.apache.flink.api.common.time.TimeZone;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

// ...

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setStreamTimeZone(TimeZone.getTimeZone("Asia/Shanghai")); // 将时区设置为北京时间

要在Flink中修改系统的UTC时间,可以使用以下方法:

修改JVM的时区设置。在Flink的YAML配置文件中加入以下行:

jvm.options:

-Duser.timezone=Asia/Shanghai

注意这里的时区为中国标准时间(东八区)。如果希望使用北京夏令时(BJT),则可以将时区设为 Asia/Shanghai。

如果所有窗口都在同一个时区内,可以选择将整个Flink集群的时区统一为一个,这样窗口函数的偏移量就是相对于这个时区的。

如果窗口分布在多个时区,可以为每个窗口单独设置偏移量。这可以通过在window函数中传参完成,类似于WindowFunction, String>(input.key(), input.value(), windowStart, windowEnd),其中windowStart和windowEnd分别代表窗口的开始和结束时刻。

如果窗口的功能之一是用来跟踪时间流逝,可以考虑使用Flink的EventTimeSessionWindows或ProcessingTimeSessionWindows,这两种窗口都可以自动追踪时间流逝,不需要显式地设置偏移量。

如果窗口跨越了多个时区,可以考虑使用跨时区通信技术,如NTP或其他类似的协议,来校准各个节点的时钟。

如果你的Flink系统时间是北京时间,但窗口计算时使用了北京时间+8,那么可能是窗口函数中使用了错误的时区。

在Flink中,可以使用TimeZone对象来指定时区。你可以通过以下代码来设置窗口函数中的时区:

import org.apache.flink.streaming.api.windowing.time.TimeZone;

// ...

TimeZone timeZone = TimeZone.of("Asia/Shanghai");

Window window = Window.tumblingEventTimeWindows(Time.seconds(10), timeZone);

在这个例子中,我们使用了TimeZone.of()方法来指定时区,然后将时区传递给窗口函数。在这个例子中,我们使用了上海时区,它与北京时间相同。如果你需要使用其他时区,可以替换"Asia/Shanghai"为所需的时区名称。

这个问题涉及到Flink的时间处理和时区设置。如果Flink的系统时间是北京时间,但窗口函数是基于北京时间+8计算的,可能是由于时区设置不当或者窗口函数配置不正确导致的。

首先,你需要确认Flink的时区设置是否正确。你可以在Flink的配置文件(例如flink-conf.yaml)中检查时区设置。确保时区设置与你期望的时区一致。例如,如果你要使用东八区时间,你可以将时区设置为"UTC+8"。

timezone: UTC+8

其次,检查你的窗口函数配置。确保窗口函数的开始时间和结束时间是根据正确的时区计算的。你可以在Flink SQL中使用TUMBLE、HOP或SESSION等窗口函数,并使用PARTITION BY和ORDER BY子句来指定窗口的开始和结束时间。

例如,以下是一个使用TUMBLE窗口函数的示例,其中时间字段是按照UTC+8时区计算的:

SELECT window_start, window_end, COUNT()

FROM table_name

PARTITION BY DATE(time_field) / 这里假设time_field是存储时间的字段 /

ORDER BY time_field

TUMBLE(INTERVAL '10' MINUTE, TIME '2023-07-19 08:00:00' / 这里设置窗口的开始时间为UTC+8时区的北京时间早上8点 */)

确保时间参数和字段的时区与你期望的一致。

如果以上步骤都没有解决问题,你可能需要检查Flink的版本和相关依赖库是否与你的环境兼容,或者考虑升级到最新版本,以获得更好的时区支持和问题修复。

最后,如果问题仍然存在,你可以在Flink的社区论坛或相关技术社区中寻求帮助,提供更多关于你的环境和配置的详细信息,以便获得更具体的解决方案。

如果你在使用Flink时,发现系统的实际时间与Flink窗口函数中的时间不同步,导致Flink窗口函数的时间偏移了8小时,你可以尝试以下几种方法来解决这个问题:

调整系统时间:确保你的系统时间是准确的,并且与北京时间一致。你可以检查系统的时区设置,并确保它正确地指向了北京时间。

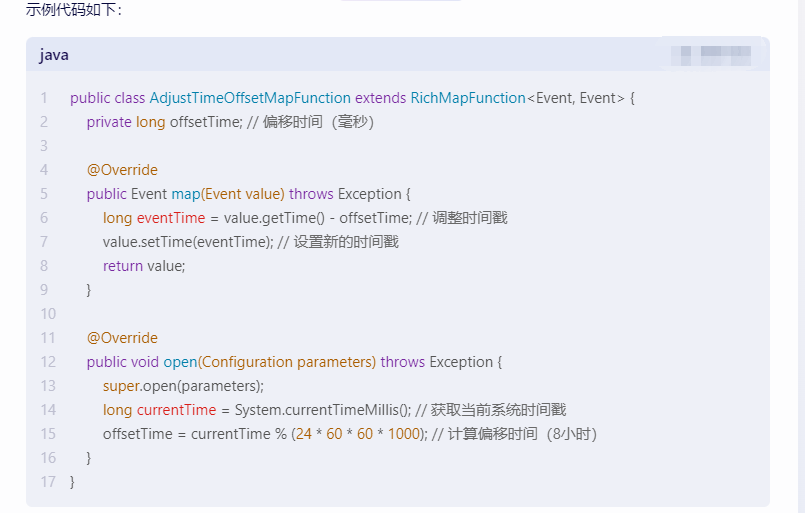

调整Flink时间戳:在Flink中,你可以使用RichMapFunction或者RichFlatMapFunction来调整时间戳。在open方法中,你可以获取当前的系统时间,并使用System.currentTimeMillis()获取当前的时间戳。然后,你可以将这个时间戳设置为Flink的当前时间。

在上面的代码中,我们通过在open方法中获取当前系统时间戳,并计算出偏移时间(8小时),然后将这个偏移时间应用于事件时间戳。这样就可以将Flink的时间与系统时间同步。

请根据你的具体情况选择适合的方法来解决Flink窗口函数中的时间偏移问题。如果你还有其他问题或需要更详细的帮助,请随时提问。

解决差八小时问题

实际在使用的时候flink输出的时差很令人反感,但是没办法flink目前不支持配置时区,但是blink支持,等待着合并吧。

其实,时区问题解决方案比较多吧,要想不伤筋动骨,主要介绍以下三种:

flink端不做处理。也即是在读取数据的时候加上8小时的offset。

使用udf等算子给时间戳加上8小时的offset。

sink内部做处理。

https://blog.csdn.net/rlnLo2pNEfx9c/article/details/91915550

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。