这个Flink问题怎么解决?

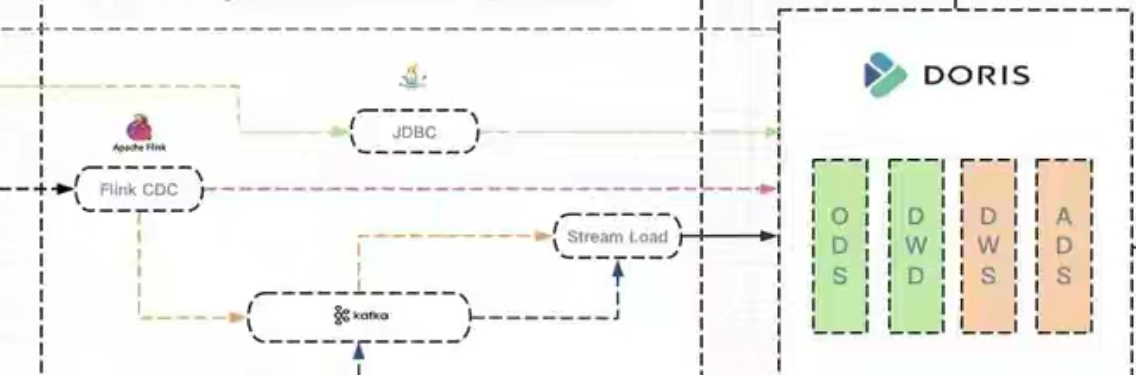

这个Flink问题怎么解决?实时数仓构建过程中,用flink sql将数据实时采集到ods(doris unique模型)后,又怎么将ods数据加工后放到dwd(doris unique模型)层宽表中呢?ods层数据涉及到的更新/删除也要体现在dwd和dws(doris 聚合模型)层中,请问是不是要借助外部的任务调度工具(如海豚调度)完成层与层的数据构建呢

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

你好,你可以使用 Flink CDC 从 Doris 中消费数据,然后再将数据写入到另一张 Doris 表中。

具体的操作如下:

创建一个 Flink CDC 任务,并配置好连接 Doris 的参数。

在 CDC 任务中定义一个转换函数,将输入的数据转换成你想要的数据格式。

将转换后的数据写入到另一张 Doris 表中。

如果需要对数据进行更新/删除,你可以使用 Flink SQL 中的 MERGE 语句。具体语法如下:

MERGE INTO table_name AS target

USING source_table AS source

ON target.key = source.key

WHEN MATCHED THEN

UPDATE SET ...

WHEN NOT MATCHED THEN

INSERT ...

其中:table_name 是目标表的名称。

key 是连接源表和目标表的键列。

source_table 是源表的名称。

... 是更新目标表的列名和更新值。

如果需要使用外部任务调度工具来完成层与层的数据构建,你可以使用 Apache DolphinScheduler。具体的操作如下:

创建一个 Apache DolphinScheduler 作业,并配置好连接 Doris 的参数。

在作业中定义一个 Flink SQL 作业,并使用 Flink CDC 从 Doris 中消费数据。

将 Flink SQL 作业写入到另一张 Doris 表中。

以上就是关于如何使用 Flink CDC 从 Doris 中消费数据并将数据写入到另一张 Doris 表中的示例。2023-10-12 14:49:52赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。