Flink CDC中我自定义的udaf函数,为什么只有+I的数据可以做统计,对于-U和+U的数据,没有进行聚合,这个可以怎么来排查呢?

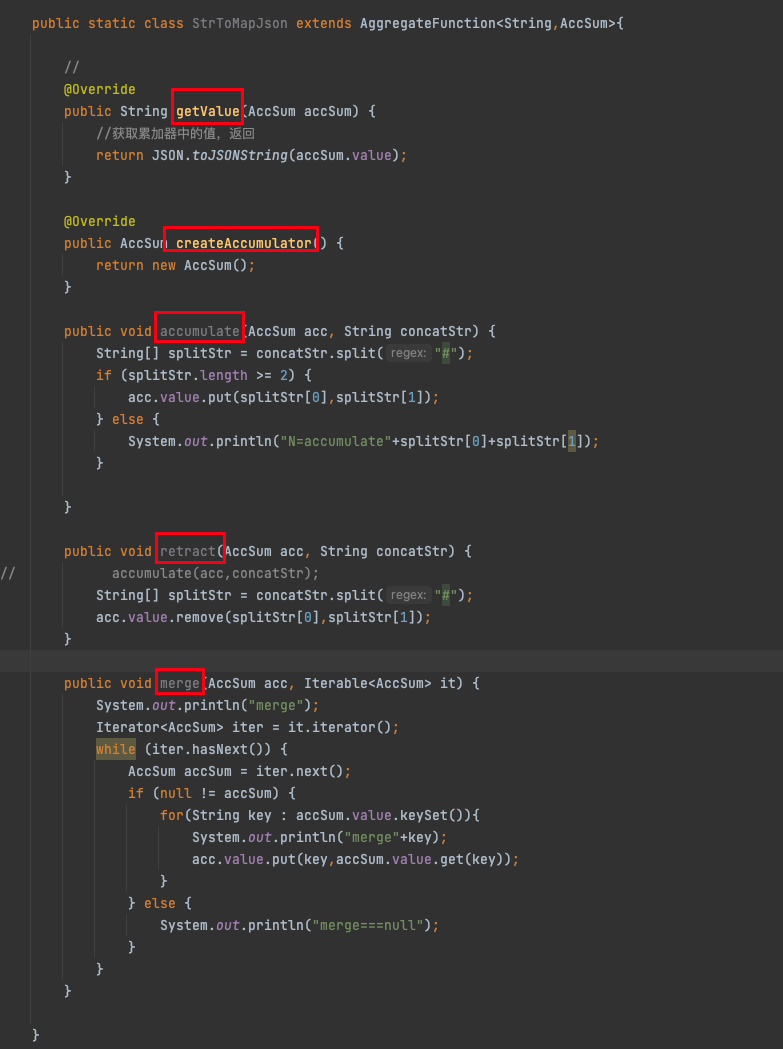

一个简单的实现

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink CDC中,自定义UDAF函数只对I(Insert)类型的数据进行统计,而未对U(Update)和-U(Delete)类型的数据进行聚合,可能是由于以下几个原因导致的。以下是排查问题的具体步骤和解决方案:

Flink CDC源表会生成三种类型的数据变更事件:I(插入)、U(更新前数据)、-U(更新后数据)。为了正确处理这些事件,UDAF需要支持Retract机制,即能够处理撤回(retract)和更新操作。

retract方法。如果未实现该方法,Flink无法正确处理U和-U类型的数据。accumulate方法用于处理新增数据,而retract方法用于处理撤回数据。例如:public void retract(Accumulator acc, InputType value) {

// 处理撤回逻辑,例如从累加器中移除对应值

acc.sum -= value;

}

确保您的UDAF类中实现了retract方法,并在其中正确处理撤回逻辑。如果未实现retract方法,Flink默认不会对U和-U类型的数据进行处理。

Flink CDC源表默认以Changelog模式输出数据变更事件。如果您的作业未正确配置Changelog模式,可能导致U和-U类型的数据被忽略。

CREATE TABLE source_table (

id BIGINT,

value BIGINT,

PRIMARY KEY (id) NOT ENFORCED

) WITH (

'connector' = 'mysql-cdc',

'hostname' = 'your-hostname',

'port' = '3306',

'username' = 'your-username',

'password' = 'your-password',

'database-name' = 'your-database',

'table-name' = 'your-table'

);

如果未启用Changelog模式,请在CDC源表的DDL中显式声明。此外,您可以通过打印中间结果表来验证数据流是否包含U和-U类型的数据。

在使用UDAF时,GROUP BY字段的选择会影响聚合结果。如果GROUP BY字段未正确设置,可能导致部分数据未被正确分组。

GROUP BY。例如:INSERT INTO result_table

SELECT

user_id,

my_udaf(status) AS aggregated_status

FROM source_table

GROUP BY user_id;

GROUP BY字段与业务逻辑一致。如果GROUP BY字段不匹配,可能导致部分数据未被聚合。根据业务需求调整GROUP BY字段,确保所有相关数据都能被正确分组。

Flink SQL支持MiniBatch优化,这可能会影响聚合结果的输出频率和内容。如果启用了MiniBatch优化,可能导致部分中间结果未及时输出。

SET table.exec.mini-batch.enabled=true;

SET table.exec.mini-batch.allow-latency=5s;

SET table.exec.mini-batch.size=1000;

如果问题与MiniBatch优化相关,可以尝试关闭MiniBatch优化,或者调整其参数以适应业务需求。

通过打印中间结果表,验证数据流中是否包含U和-U类型的数据。

CREATE TEMPORARY TABLE print_table (

id BIGINT,

value BIGINT,

op STRING -- 数据变更类型:I、U、-U

) WITH (

'connector' = 'print'

);

INSERT INTO print_table

SELECT

id,

value,

op

FROM source_table;

U和-U类型的数据。如果数据流中缺少U和-U类型的数据,可能是CDC源表配置或数据同步链路存在问题。请检查CDC源表的配置和网络连通性。

以下是一个简单的UDAF实现,支持I、U和-U类型的数据聚合:

public class MyUDAF extends AggregateFunction<Long, MyUDAF.Accumulator> {

public static class Accumulator {

public long sum = 0;

}

@Override

public Long getValue(Accumulator acc) {

return acc.sum;

}

@Override

public Accumulator createAccumulator() {

return new Accumulator();

}

public void accumulate(Accumulator acc, long value) {

acc.sum += value; // 处理新增数据

}

public void retract(Accumulator acc, long value) {

acc.sum -= value; // 处理撤回数据

}

}

在SQL中注册并使用该UDAF:

CREATE TEMPORARY FUNCTION my_udaf AS 'com.example.MyUDAF';

INSERT INTO result_table

SELECT

user_id,

my_udaf(value) AS aggregated_value

FROM source_table

GROUP BY user_id;

通过以上步骤,您可以逐步排查并解决Flink CDC中UDAF未正确处理U和-U类型数据的问题。重点在于: 1. 确保UDAF实现支持retract方法; 2. 验证CDC源表的Changelog模式; 3. 检查SQL语句中的GROUP BY逻辑; 4. 调试数据流以确认数据完整性。

如果问题仍未解决,请提供更多上下文信息(如UDAF代码、SQL语句等),以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。