大家有用过机器学习PAI DeepRec Serving里使用go sdk调用batch_process做批量预测吗 ?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在阿里云机器学习平台PAI中,DeepRec Serving支持通过Go SDK调用batch_process进行批量预测。以下是详细的步骤和配置说明,帮助您完成相关操作。

在使用Go SDK调用批量预测之前,请确保以下准备工作已完成: - 服务部署:确保您的模型已通过PAI-EAS(Elastic Algorithm Service)部署为在线服务。 - SDK安装:Go SDK无需手动安装,Golang的包管理工具会在编译时自动从GitHub下载相关代码。 - 服务访问信息:获取服务的Endpoint、Token以及服务名称。这些信息可以通过PAI控制台的服务调用信息页面查看。

在代码中初始化PredictClient对象,并设置必要的参数:

package main

import (

"fmt"

"github.com/pai-eas/eas-golang-sdk/eas"

)

func main() {

// 初始化PredictClient

client := eas.NewPredictClient("pai-eas-vpc.cn-shanghai.aliyuncs.com", "your_service_name")

// 设置服务Token

client.SetToken("your_service_token")

// 设置Endpoint类型为VPC直连(可选)

client.SetEndpointType(eas.EndpointTypeDirect)

// 初始化客户端

client.Init()

}

重要参数说明: - pai-eas-vpc.cn-shanghai.aliyuncs.com:替换为目标服务所在地域的域名。 - your_service_name:替换为实际的服务名称。 - your_service_token:替换为服务的鉴权Token。

通过Go SDK提交批量预测请求时,需要构造符合模型输入格式的数据。以下是一个示例代码:

// 构造批量预测请求数据

req := "[{\"fea1\": 1, \"fea2\": 2}, {\"fea1\": 3, \"fea2\": 4}]"

// 提交批量预测请求

for i := 0; i < 100; i++ {

resp, err := client.StringPredict(req)

if err != nil {

fmt.Printf("预测失败: %v\n", err.Error())

} else {

fmt.Printf("预测结果: %v\n", resp)

}

}

关键点: - req:JSON格式的字符串,表示批量预测的输入数据。每个样本需符合模型的输入特征格式。 - StringPredict:用于提交字符串类型的预测请求。如果模型支持其他格式(如TensorFlow或PyTorch),可以使用对应的TFPredict或TorchPredict方法。

为了提高批量预测的效率,您可以调整以下参数: - Batch Size:通过user_process_config中的batch_size字段设置批量大小,默认值为8。 - 并发线程数:通过num_threads字段设置并发运行的线程数,建议根据实例规格调整。 - 缓存队列长度:通过queue_size字段设置缓存队列长度,默认值为1024。

示例配置如下:

{

"job_name": "my_batch_process",

"num_threads": 4,

"batch_size": 16,

"queue_size": 2048

}

批量预测的结果通常以CSV文件形式输出,包含以下字段: - user_id:用户ID。 - item_id:物品ID。 - phone:电话号码(可选)。 - score:预测得分。

输出文件路径可通过output_dir参数指定,例如:

oss://your_bucket/output_dir/

注意:输出文件不包含Header,需根据字段顺序解析结果。

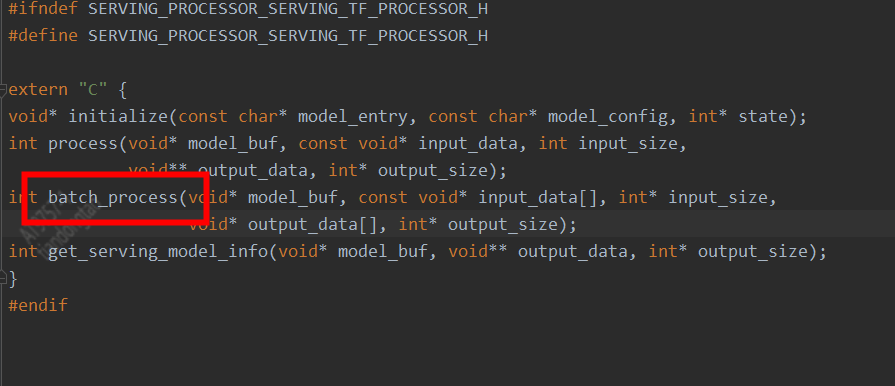

OfflineModel,而不是PMML。pai=plugin标签。cpuRequired和gpuRequired参数,避免资源不足导致任务失败。通过以上步骤,您可以成功使用Go SDK调用DeepRec Serving的batch_process功能进行批量预测。如果有进一步的问题,请参考PAI官方文档或联系技术支持团队。

人工智能平台 PAI(Platform for AI,原机器学习平台PAI)是面向开发者和企业的机器学习/深度学习工程平台,提供包含数据标注、模型构建、模型训练、模型部署、推理优化在内的AI开发全链路服务,内置140+种优化算法,具备丰富的行业场景插件,为用户提供低门槛、高性能的云原生AI工程化能力。