Flink CDC这个问题该怎么处理 ?

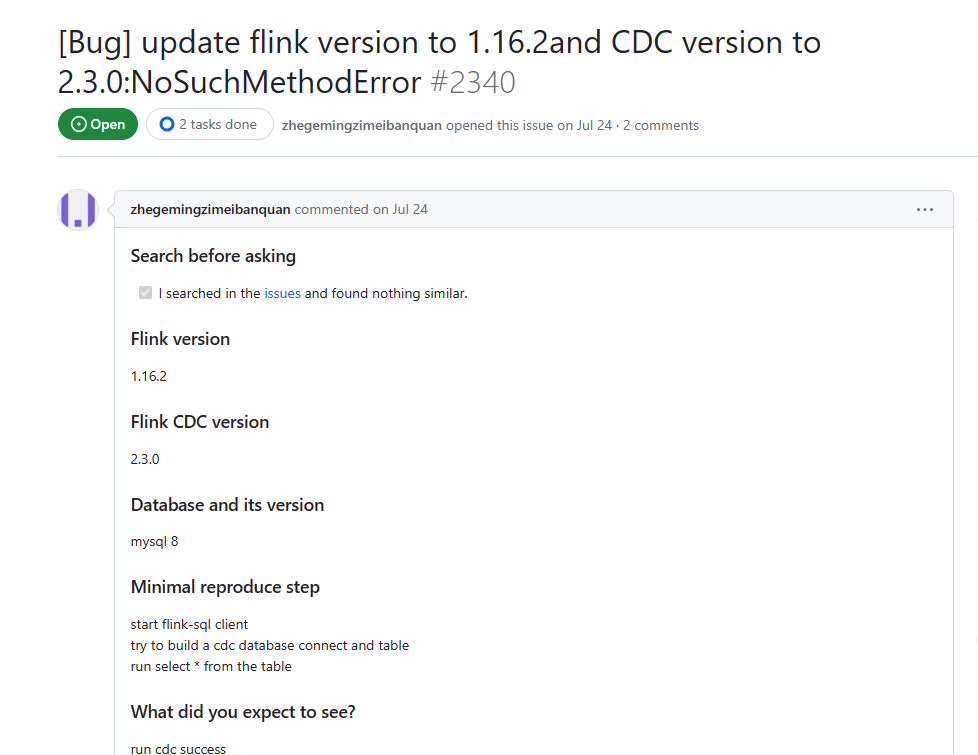

Flink CDC这个问题该怎么处理 https://kgithub.com/ververica/flink-cdc-connectors/issues/2340?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

Flink CDC 在处理库表变更时,会将 Changelog 发送到 Kafka 的 debezium-schema-changes 主题。如果 Kafka 集群的 debezium-schema-changes 主题没有足够的容量来存储 Changelog,就会导致 Changelog 丢失。

解决方法如下:

增加 Kafka 集群的 debezium-schema-changes 主题的容量。

降低 Flink CDC 的消费速率。

使用 debezium.consume-from-beginning 配置项,让 Flink CDC 从 Kafka 的 debezium-schema-changes 主题的最新元数据开始消费。

如果上述方法都不能解决问题,可以联系 Flink CDC 的开发团队获取帮助。2023-10-20 15:30:16赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。