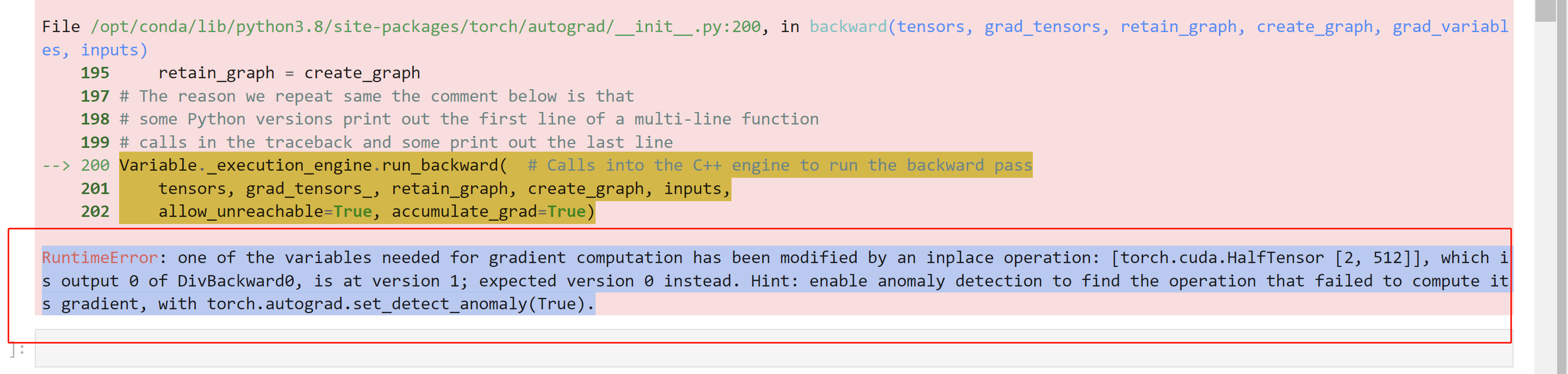

"ModelScope在按照官方教程进行clip-cn的finetune的时候,如果把batch_size设置小于训练样本数就会报如下的错误,请问该怎么解决呢?

"

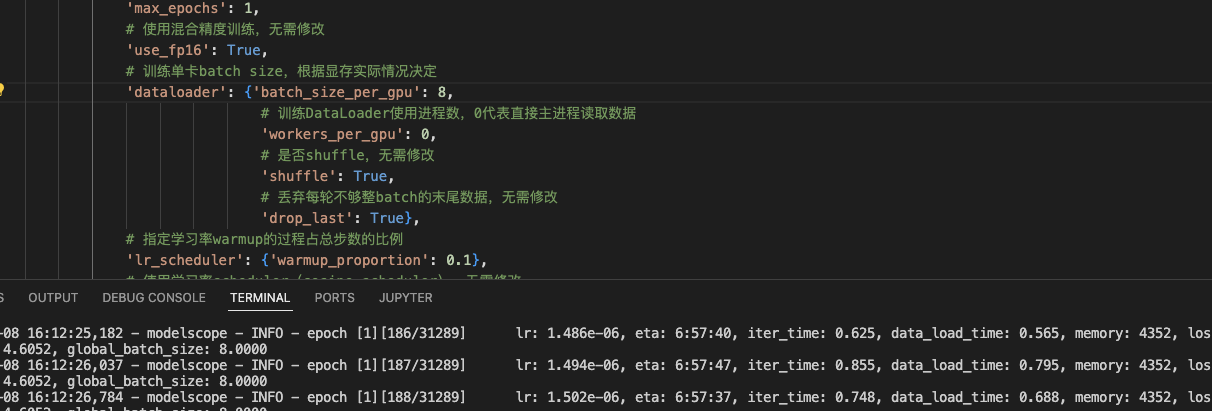

"batchsize=8, 可以跑。

镜像:registry.cn-beijing.aliyuncs.com/modelscope-repo/modelscope:ubuntu20.04-cuda11.8.0-py38-torch2.0.1-tf2.13.0-1.9.0您看一下notebook镜像。打开终端可以更新modelscope的。pip install modelscope --upgrade# 使用混合精度训练,无需修改

'use_fp16': True,

改False试一下,此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”"

torch.cuda.amp 模块进行混合精度训练。但是,某些 GPU 可能不支持这种训练方法。您可以尝试禁用混合精度训练,看看问题是否得到解决。要禁用混合精度训练,请将以下代码添加到您的训练循环之前:import torch

torch.autograd.set_detect_anomaly(False)

CopyCopy