云数据仓库ADB用 load data 向数仓中加载数据这个速度正常吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

云数据仓库AnalyticDB(简称ADB)使用LOAD DATA命令向数仓中加载数据的速度是否正常,取决于多个因素,包括数据规模、集群配置、导入方式以及优化措施等。以下是详细分析和建议:

LOAD DATA的基本性能特点LOAD DATA是AnalyticDB MySQL版支持的一种高效本地文件导入方式,适用于将文本文档(如CSV、TSV等格式)快速加载到目标表中。其性能特点如下: - 默认分隔符:列分隔符为\t,行分隔符为\n,如果数据格式与默认值一致,则无需额外配置。 - 原子性限制:LOAD DATA无法保证操作的原子性。在IGNORE模式下,失败行会被忽略;在REPLACE模式下,一旦某行导入失败,后续操作会终止。 - 客户端配置要求:需要开启local-infile功能,否则可能导致导入失败。

以下因素可能显著影响LOAD DATA的导入速度:

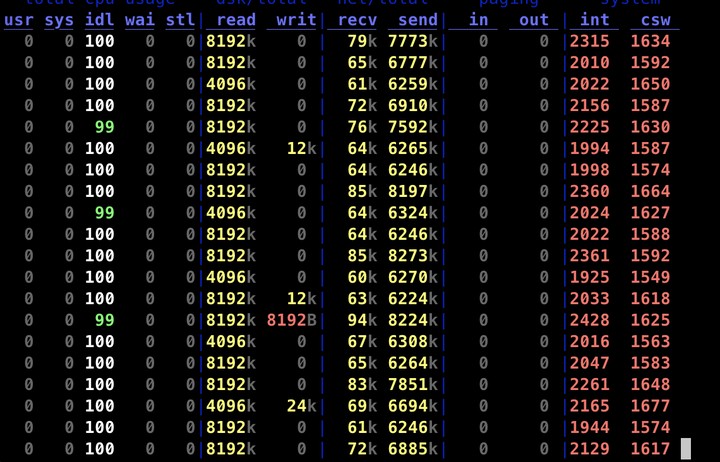

|),需要进行预处理以避免导入失败。direct_batch_load=true)加速导入任务。LOAD DATA本身不支持多线程并发导入,但可以通过拆分大文件为多个小文件,并行执行多个LOAD DATA命令来提升效率。adb-import-tool.jar)可以更好地利用并行、Batch、池化等技术实现高性能导入。要判断LOAD DATA的导入速度是否正常,可以参考以下指标: - 单节点吞吐量:在理想情况下,单节点的写入吞吐量可达数百MB/s。如果实际速度远低于此值,可能存在性能瓶颈。 - 耗时估算:假设数据文件大小为10 GB,导入时间为6~8分钟,则平均速度约为20~30 MB/s,这属于正常范围。 - 错误日志:通过SHOW WARNINGS命令查看失败行的错误信息,排除因数据质量问题导致的性能下降。

如果发现LOAD DATA的导入速度较慢,可以尝试以下优化措施:

在弹性模式集群3.1.5及以上版本中,可以在导入任务前增加Hint(direct_batch_load=true)以加速导入。示例如下:

SUBMIT JOB /*+ direct_batch_load=true*/INSERT OVERWRITE adb_table

SELECT * FROM adb_external_table;

AnalyticDB提供了专用的导入工具(如adb-import-tool.jar),支持通过配置batchSize和并发数来最大化吞吐量。具体步骤包括: 1. 下载并解压导入工具。 2. 配置导入参数(如batchSize、并发数等)。 3. 执行导入命令。

LOAD DATA命令。local-infile功能。LOAD DATA是一种高效的本地文件导入方式,但在实际使用中,其速度受多种因素影响。如果导入速度较慢,建议从集群配置、数据预处理、并发设置等方面进行优化。对于大规模数据导入,推荐使用AnalyticDB的专用导入工具以获得更佳性能。

如果您仍有疑问或需要进一步的帮助,请提供更多上下文信息(如数据规模、集群配置等),以便我们为您提供更具体的建议。

阿里云自主研发的云原生数据仓库,具有高并发读写、低峰谷读写、弹性扩展、安全可靠等特性,可支持PB级别数据存储,可广泛应用于BI、机器学习、实时分析、数据挖掘等场景。包含AnalyticDB MySQL版、AnalyticDB PostgreSQL 版。