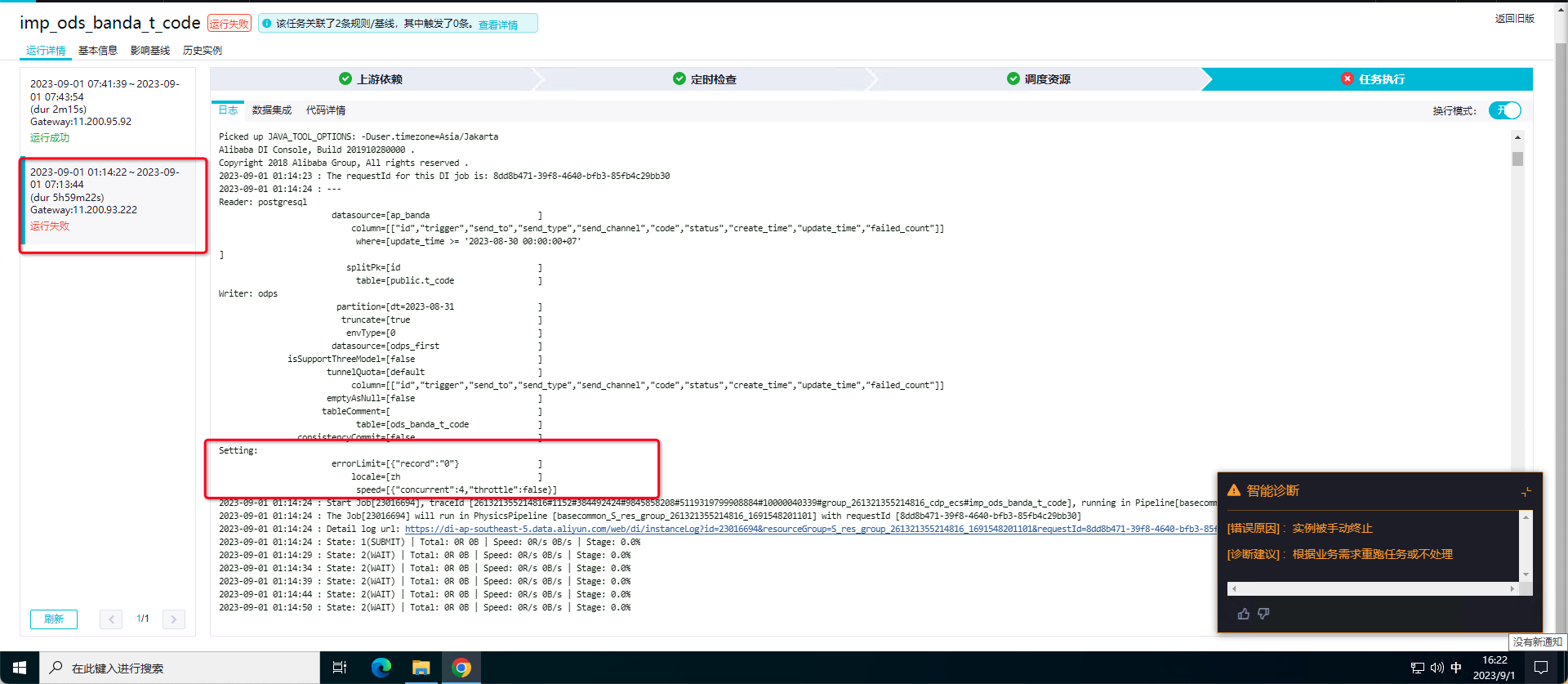

DataWorks抽数任务配置里是关闭了分布式,但任务还是卡住了,手动杀掉实例后,再手动重跑的话,抽数任务很快就执行好了,请问这种情况会是什么原因导致的呢? 上面的截图分别是成功和失败的配置截图?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

有几种可能的原因导致抽数任务卡住并需要手动杀死实例后才能成功运行:

数据源问题:任务卡住可能是由于数据源的问题导致的。请确保数据源的连接正常,数据源的数据可用且没有异常。可以尝试手动测试数据源连接,检查是否有任何异常或错误。

网络问题:任务卡住也可能是由于网络问题导致的。请确保网络连接稳定,并且任务能够正常访问所需的资源和服务。

任务调度问题:任务卡住可能与任务调度有关。请检查任务调度配置,确保您所配置的调度方式和调度参数是正确的,并与您的预期相匹配。

资源限制:任务卡住还可能是由于资源限制导致的。请检查任务所需的资源配置,包括内存、CPU等是否满足任务的要求。如果资源不足,可以尝试增加资源配额或调整任务的并行度。

异常数据处理:任务可能会因为异常数据而卡住。如果任务处理的数据中包含异常数据,可能会导致任务无法正常执行。请检查任务日志,查找任何与异常数据相关的错误或警告信息。

请注意,以上只是一些常见的原因,实际情况可能因任务配置、环境和数据等因素而异。建议根据具体情况进行详细的排查和分析,可以查看任务日志、监控指标以及其他相关信息,以进一步确定任务卡住的原因。

如果问题仍然存在,建议您向DataWorks的支持团队或社区寻求帮助,他们可以提供更具体的指导和解决方案。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。