大数据计算MaxCompute能用spark3 不?本地scala 环境是2.12

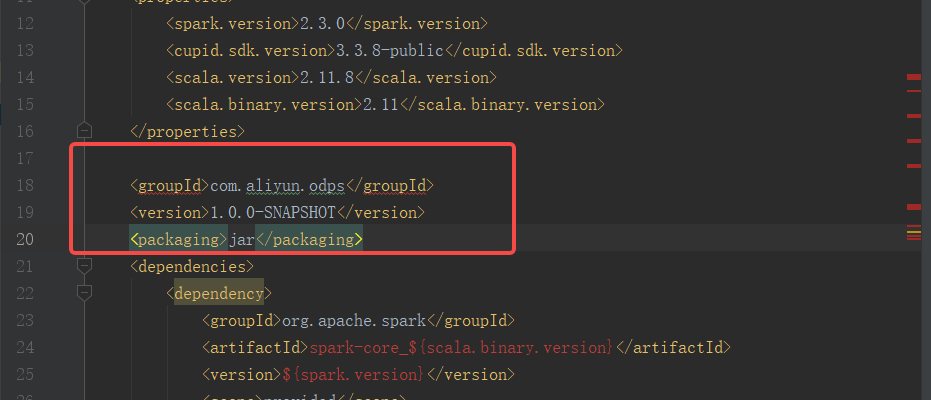

这里是不是缺失呀?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

MaxCompute确实支持Spark 3.x版本,因此您可以在MaxCompute中使用Spark 3.x进行大数据计算。不过,针对您提到的本地Scala环境为2.12的情况,需要进一步说明以下几点:

spark-submit命令提交Spark作业到MaxCompute集群,具体提交方式可以参考相关文档中的示例代码。pom.xml文件中正确添加了odps-spark-datasource依赖,并且scope设置为provided。spark.sql.defaultCatalog、spark.sql.catalog.odps等。spark.master为local[N]模式,并手动添加Spark on MaxCompute客户端的相关依赖。MaxCompute支持Spark 3.x版本,并且可以通过合理配置支持Scala 2.12的本地开发环境。如果您发现当前环境或依赖中存在缺失,请根据上述步骤逐一排查并解决。如有进一步问题,建议参考官方文档或联系技术支持获取帮助。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。