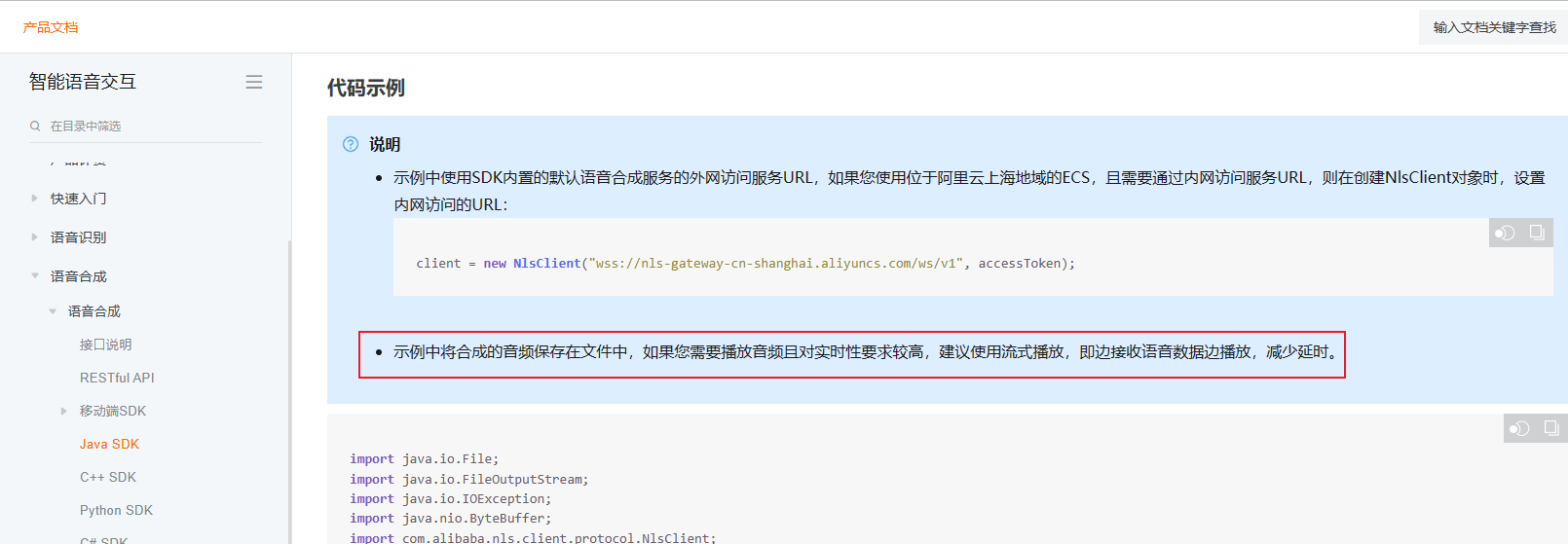

目前已成功调用了阿里云的语音合成接口,并将返回的每一包语音流通过socket传到js中,最后如何在js中实现流式播放,即边接收语音数据边播放,减少延时。可能受限于我的技术水平,试过网上的各种方法效果都不理想,还请各位帮忙解决,谢谢~

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

要实现音频的流式播放,即边接收语音数据边播放,减少延迟,您可以使用Web Audio API和MediaSource API来实现。下面是一个基本的示例代码:

javascript

Copy

// 创建音频上下文

const audioContext = new (window.AudioContext || window.webkitAudioContext)();

// 创建MediaSource对象

const mediaSource = new MediaSource();

// 创建音频元素

const audioElement = new Audio();

audioElement.src = URL.createObjectURL(mediaSource);

// 连接音频元素和音频上下文

const source = audioContext.createMediaElementSource(audioElement);

source.connect(audioContext.destination);

// 监听MediaSource的sourceopen事件

mediaSource.addEventListener('sourceopen', () => {

// 创建SourceBuffer对象

const sourceBuffer = mediaSource.addSourceBuffer('audio/webm; codecs="opus"');

// 监听sourceBuffer的updateend事件

sourceBuffer.addEventListener('updateend', () => {

// 如果sourceBuffer中有数据,则开始播放音频

if (!sourceBuffer.updating && mediaSource.readyState === 'open') {

mediaSource.endOfStream();

audioElement.play();

}

});

// 接收音频数据并追加到sourceBuffer

function receiveAudioData(audioData) {

sourceBuffer.appendBuffer(audioData);

}

// 在这里使用WebSocket或其他方式接收音频数据,然后调用receiveAudioData方法追加数据到sourceBuffer

});

在上述代码中,我们首先创建了一个音频上下文(AudioContext),然后创建了一个MediaSource对象,该对象用于动态生成音频流。接下来,我们创建了一个音频元素(Audio),将MediaSource的URL设置为音频元素的源,然后将音频元素连接到音频上下文。

在sourceopen事件的监听器中,我们创建了SourceBuffer对象,并将其添加到MediaSource中。然后,我们监听SourceBuffer的updateend事件,当事件触发时,如果SourceBuffer中有数据且MediaSource处于打开状态,我们调用endOfStream方法结束流,并播放音频。

最后,您需要根据实际情况,使用WebSocket或其他方式接收音频数据,并调用receiveAudioData方法将数据追加到SourceBuffer中。

在JavaScript中,实现音频的流式播放主要涉及到Web Audio API和WebSocket的使用。以下是一个基本的步骤:

创建一个WebSocket连接,用于接收音频数据。

javascript

let socket = new WebSocket('ws://your-websocket-url');

当WebSocket接收到数据时,创建一个AudioContext,将音频数据解码并播放。

socket.onmessage = function(event) {

let audioContext = new (window.AudioContext || window.webkitAudioContext)();

let decodeAudioData = audioContext.decodeAudioData(event.data, function(buffer) {

let source = audioContext.createBufferSource();

source.buffer = buffer;

source.connect(audioContext.destination);

source.start(0);

}, function (err) {

console.log(err);

});

};

注意,这个方法并不适用于所有情况,因为它依赖于浏览器对WebSocket和Web Audio API的支持。而且,由于音频的解码和播放都需要时间,这种方法并不能完全消除音频的延迟。为了进一步减少延迟,可以考虑以下几点:

另外,如果你需要处理的是实时语音通信,那么你可能需要使用更专业的解决方案,比如WebRTC。WebRTC提供了更高级的音频处理和控制功能,可以更好地满足实时语音通信的需求。

在JavaScript中,可以使用HTML5的Audio API来实现音频的流式播放。以下是一个简单的示例:

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Streaming Audio Example</title>

</head>

<body>

<audio id="audioPlayer" controls autoplay></audio>

<script src="streamingAudio.js"></script>

</body>

</html>

const audio = document.getElementById('audioPlayer');

let isPlaying = false;

// 假设我们有一个名为'speechData'的变量,用于存储从服务器接收到的音频数据

function playSpeechData(){

if (isPlaying){ // 如果正在播放,停止播放

audio.pause();

isPlaying = false;

} else { // 如果未播放,开始播放

audio.src = speechData;

audio.play();

isPlaying = true;

}

}

在这个示例中,我们首先创建了一个HTML5的Audio元素,并将其设置为自动播放。然后,我们定义了一个名为playSpeechData的函数,该函数将音频数据赋值给audio.src属性,并根据isPlaying变量的值决定是否开始播放。

当新的音频数据到达时,我们将其赋值给speechData变量,并调用playSpeechData函数。这样,即使音频数据是通过网络传输的,我们的浏览器也能实时地播放它们。