ModelScope这是我的评估结果,该咋解读?

ModelScope(魔搭)是阿里云的模型开放平台,它提供了大量的机器学习和深度学习模型,用户可以在这个平台上浏览、搜索、评估和使用这些模型。当你在ModelScope上获得一个模型的评估结果时,这个结果通常包含了多个维度的信息,帮助你理解模型在特定任务上的性能。解读评估结果时,可以关注以下几个关键点:

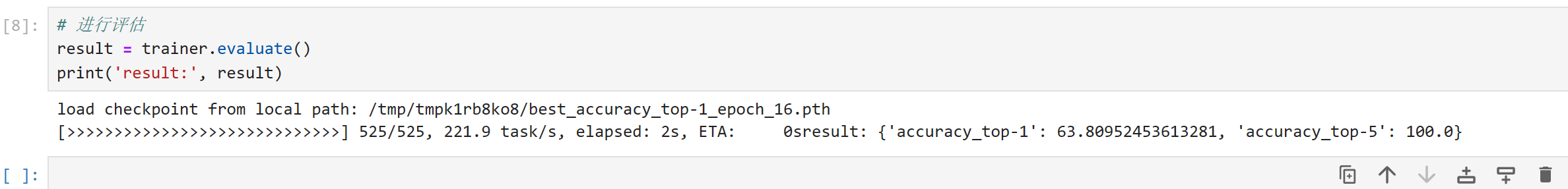

准确率(Accuracy):这是衡量模型预测正确的比例,是最直观反映模型性能的指标之一。高准确率意味着模型在测试数据集上的预测大部分是正确的。

损失函数(Loss):损失函数值反映了模型预测值与真实值之间的差异程度,数值越小通常表示模型表现越好。

精确率(Precision)、召回率(Recall)和F1分数(F1-Score):这些指标常用于分类任务中,特别是不平衡数据集。精确率是模型预测为正类中真正为正的比例,召回率是所有实际正类中被正确识别的比例,F1分数是精确率和召回率的调和平均值,综合考虑了两者。

AUC-ROC曲线下的面积(Area Under the ROC Curve, AUC-ROC):对于二分类问题,AUC-ROC值范围从0到1,值越大说明模型区分正负样本的能力越强。

混淆矩阵(Confusion Matrix):通过具体的数字展示模型预测各类别的正确与错误情况,有助于详细分析模型在各个类别上的表现。

训练时间与推理时间:这反映了模型的效率,即模型训练所需时间和执行一次预测所需的时间。

泛化能力:评估模型在未见过的数据上的表现,可以通过交叉验证等方法来估计。

根据你的具体评估结果,你可以对照上述指标进行分析。如果需要更详细的解读或针对某个特定模型的建议,可以提供更具体的评估报告内容,我会进一步帮助你理解。