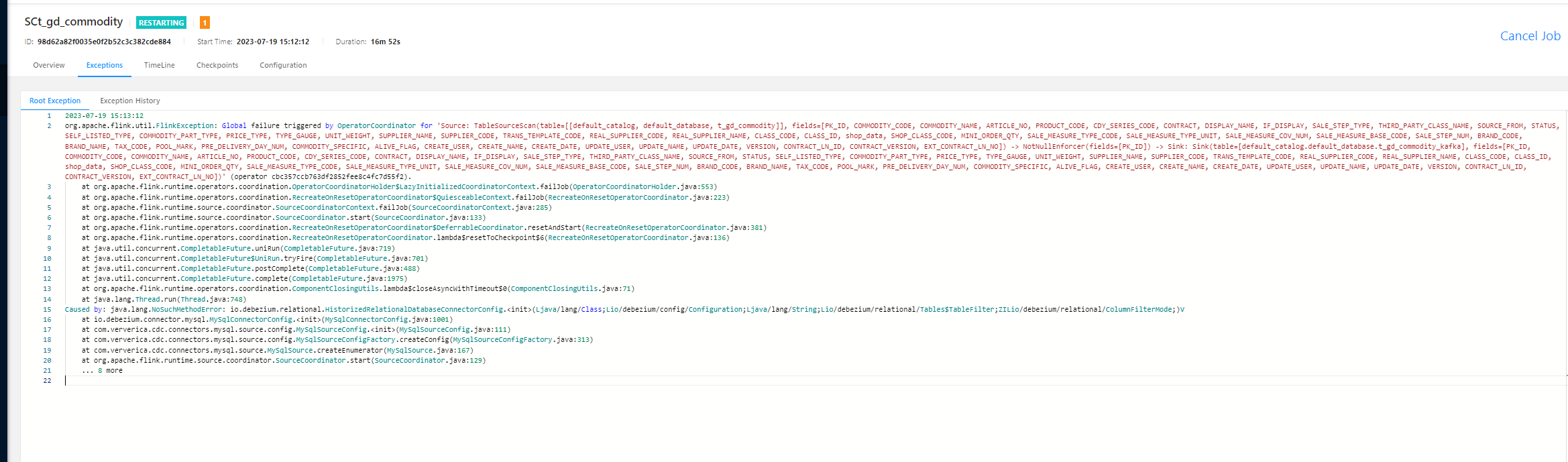

问题1:flink cdc source mysql sink kafka 报包冲突 如何解决?

问题2:这个也看不出问题。

我cdc 2.4 flink 1.13.6

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

当你在 Flink CDC 中使用 MySQL 作为源,Kafka 作为 Sink 的时候遇到包冲突问题,可以尝试以下解决方案:

排除冲突的包:如果你在项目中手动引入了与 Flink 或者 Flink CDC 冲突的包,可以尝试排除这些包,只使用 Flink 和相关库提供的依赖。使用 Maven 或 Gradle 等构建工具,你可以在相关依赖项中添加 exclusion 来排除冲突的包。

调整版本兼容性:检查你所使用的 Flink 版本和 Flink CDC 版本是否与 Kafka 相互兼容。某些老版本的 Flink 可能不支持最新版本的 Kafka。确保使用相应版本兼容的 Flink、Flink CDC 和 Kafka 依赖项。

更改包的命名空间:如果冲突是由于包命名空间的冲突引起的,你可以尝试将其中一个包的命名空间进行更改。这样可以确保不同的包彼此不会冲突。

使用独立的 ClassLoader:尝试将 Flink 和 Flink CDC 的相关依赖项与 Kafka 的依赖项隔离在不同的 ClassLoader 中。这样可以避免包冲突的问题。有关如何设置独立的 ClassLoader,可以参考 Flink 的文档或社区资源。

升级/降级相关库版本:如果其他解决方案都无法解决包冲突问题,你可能需要考虑升级或降级相关库的版本。这涉及到兼容性和功能需求之间的权衡,需要仔细评估影响。

如果在使用 Flink CDC 将 MySQL 数据源中的数据同步到 Kafka Sink 时遇到了包冲突问题,可以尝试以下几种方法进行排查和解决:

排查包冲突的原因:首先需要确定具体的包冲突原因,可以通过查看 Flink CDC 和 Kafka Sink 的依赖关系,以及具体的异常信息等方式进行排查。

排除冲突包:可以尝试将造成冲突的包排除掉,例如在 Flink CDC 和 Kafka Sink 中排除掉相同的包。可以通过在 Flink CDC 和 Kafka Sink 的依赖中排除掉冲突的包,例如使用 Maven 的 标签进行排除。

使用不同的版本:如果冲突的包存在多个版本,可以尝试在 Flink CDC 和 Kafka Sink 中使用不同的版本,以避免包冲突。可以通过在 Flink CDC 和 Kafka Sink 的依赖中指定不同的版本来实现。

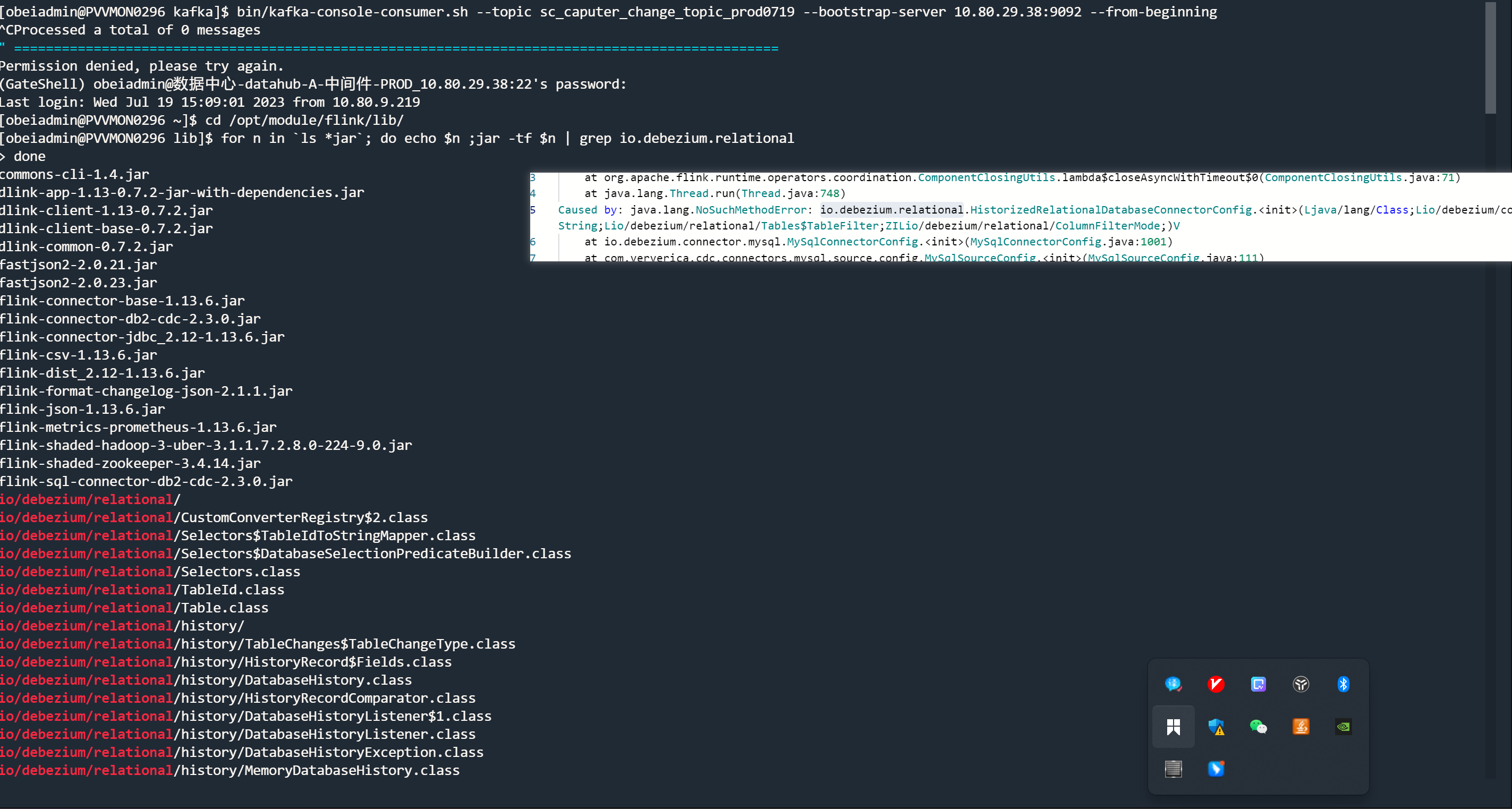

"回答1:for n in ls *jar; do echo $n ;jar -tf $n | grep org/apache/logging/log4j/Logger ; done

到flink的lib目录下执行这条命令

for n in ls *jar; do echo $n ;jar -tf $n | grep 报错的全限定类名称 ; done

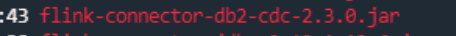

找到冲突的包,排除掉,或者用 shaded 插件重命名依赖解决。

回答2:你的 lib 挺多的,跟 cdc 有关的,除了 mysql 都先注释掉试试看。这是个瘦包,lib 目录不用放。

lib 目录比较干净的话,正常 cdc 启动应该没问题,你无法启动很难不往类冲突上联想,只是说提供一下排查思路。此回答整理至钉群“Flink CDC 社区”。"

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。