我现在需要使用阿里语音AI的实时长文本语音合成,由于提供的sdk文件不支持易语言。现在自己实现了鉴权成功,websocket连接成功。WebSocket提交数据成功,WebSocket返回数据成功。返回的数据直接合并mp3播放声音的内容也是对的,但是声音里面有叠音,明显感觉数据处理不对。看了你们的资料需要(SDK接收并处理二进制数据。)看支持下,数据是怎么处理的。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

如果您想在易语言中使用阿里语音AI的实时长文本语音合成功能,但官方提供的SDK文件不支持易语言,您仍然有几种方式处理数据:

手动封装:您可以手动封装HTTP请求,根据阿里语音AI的接口文档使用HTTP协议与语音合成服务进行通信。这样,您可以在易语言中编写代码来构建和发送请求,并处理返回的数据结果。

使用第三方库或工具:尝试使用支持易语言的第三方HTTP请求库或工具,这些库或工具可以帮助您简化HTTP请求过程,使数据处理更加方便。

使用跨语言桥接方式:在易语言中调用其他语言编写的代码。您可以通过创建一个桥接程序,使用易语言调用支持的其他编程语言(例如Python、Java、C++)编写的代码,使其执行阿里语音AI的实时长文本语音合成操作。

阿里语音AI实时长文本语音合成服务的返回结果是一个二进制的MP3音频流,您需要将这个二进制数据解析为音频文件后才能进行播放。通常情况下,MP3音频流的解析需要使用专门的解码库或者工具,比如FFmpeg等。

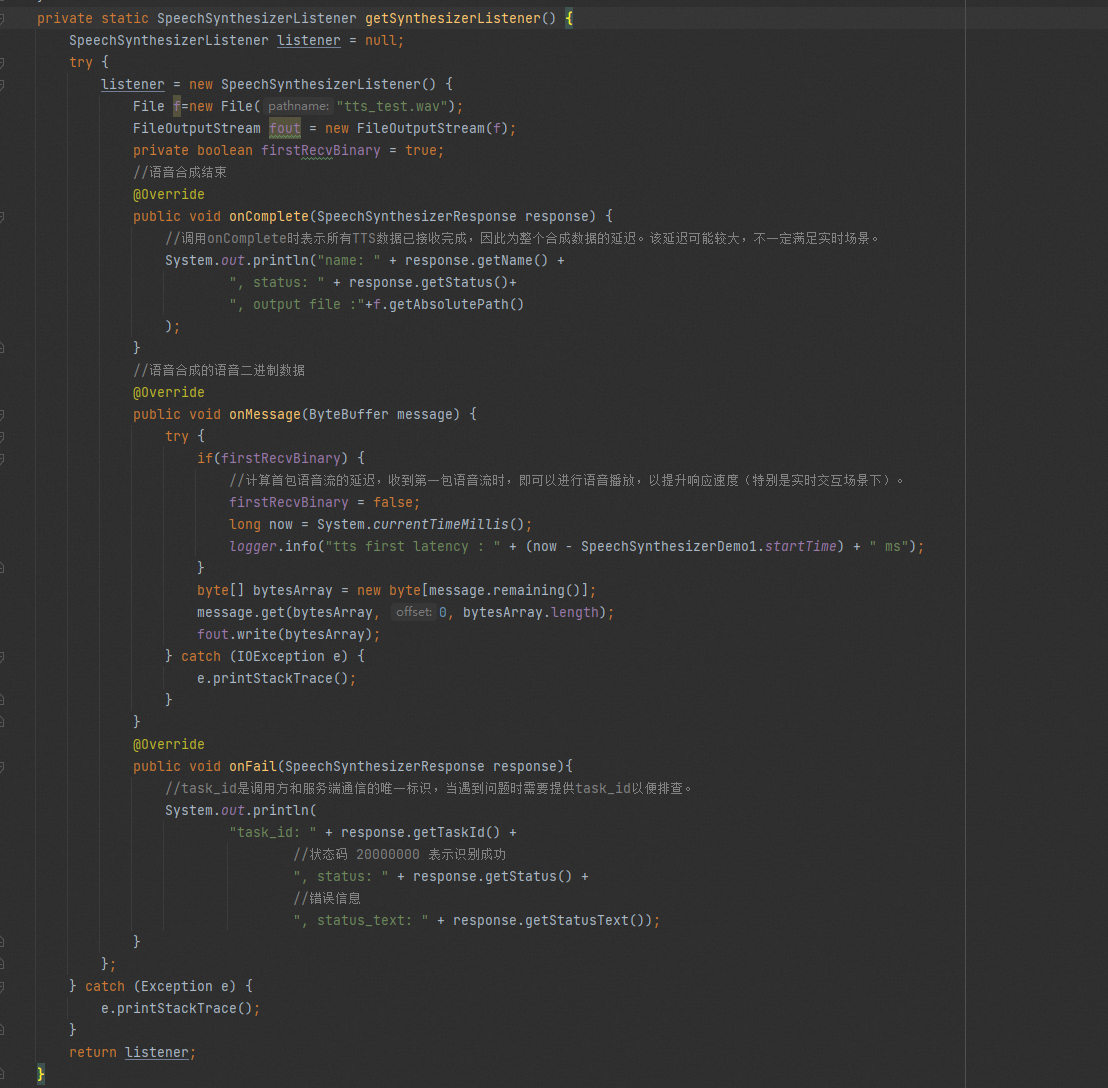

在您的问题中提到,您使用了WebSocket提交数据并成功接收到了返回的二进制数据。如果您已经成功获取到了二进制数据,那么下一步就是将这些数据解码为音频文件,然后进行播放。

具体而言,您可以将从WebSocket接收到的二进制数据转换为Base64编码的字符串,然后使用JavaScript的atob函数将Base64编码的数据解码为二进制数据,最后再将二进制数据存储为MP3音频文件。示例代码如下:

javascript

Copy

// 将WebSocket返回的二进制数据转换为Base64编码的字符串

const base64Data = btoa(String.fromCharCode.apply(null, new Uint8Array(data)));

// 将Base64编码的数据解码为二进制数据

const binaryData = atob(base64Data);

// 创建Blob对象

const blob = new Blob([new Uint8Array(binaryData.length).map((_, i) => binaryData.charCodeAt(i))], {type: 'audio/mpeg'});

// 创建URL对象并播放音频文件

const url = URL.createObjectURL(blob);

const audio = new Audio(url);

audio.play();

需要注意的是,MP3音频流有时会在数据流中间出现切片,因此在处理数据时需要将多个切片拼接在一起再进行解码和播放。

处理都在客户端 可以看下我们的客户端的示例https://help.aliyun.com/document_detail/148848.html?spm=a2c4g.84437.0.0.26305398kbSXci

—此回答来自钉群“阿里语音AI【6群】”

—此回答来自钉群“阿里语音AI【6群】”

阿里语音AI的实时长文本语音合成SDK文件可能不直接支持易语言。要在易语言中使用该SDK,您可以考虑以下方法来处理数据:

封装为动态链接库(DLL):将阿里语音AI的实时长文本语音合成SDK封装为一个动态链接库,以便易语言可以调用其功能。您可以使用其他编程语言(如C++)来创建一个DLL,将SDK的功能包装在其中,并提供易语言所需的接口。

使用跨语言桥接技术:使用跨语言桥接技术,如Swig或JNI(Java Native Interface),将阿里语音AI的实时长文本语音合成SDK与易语言进行连接。这种方法需要一定的编程技巧和对跨语言调用的了解。

使用进程间通信:您可以通过进程间通信(IPC)机制,如命名管道、共享内存或RPC(Remote Procedure Call),在易语言和其他支持阿里语音AI实时长文本语音合成SDK的语言之间传输数据。在这种方式下,您可以使用另一种编程语言来处理SDK的功能,然后将结果传递给易语言。