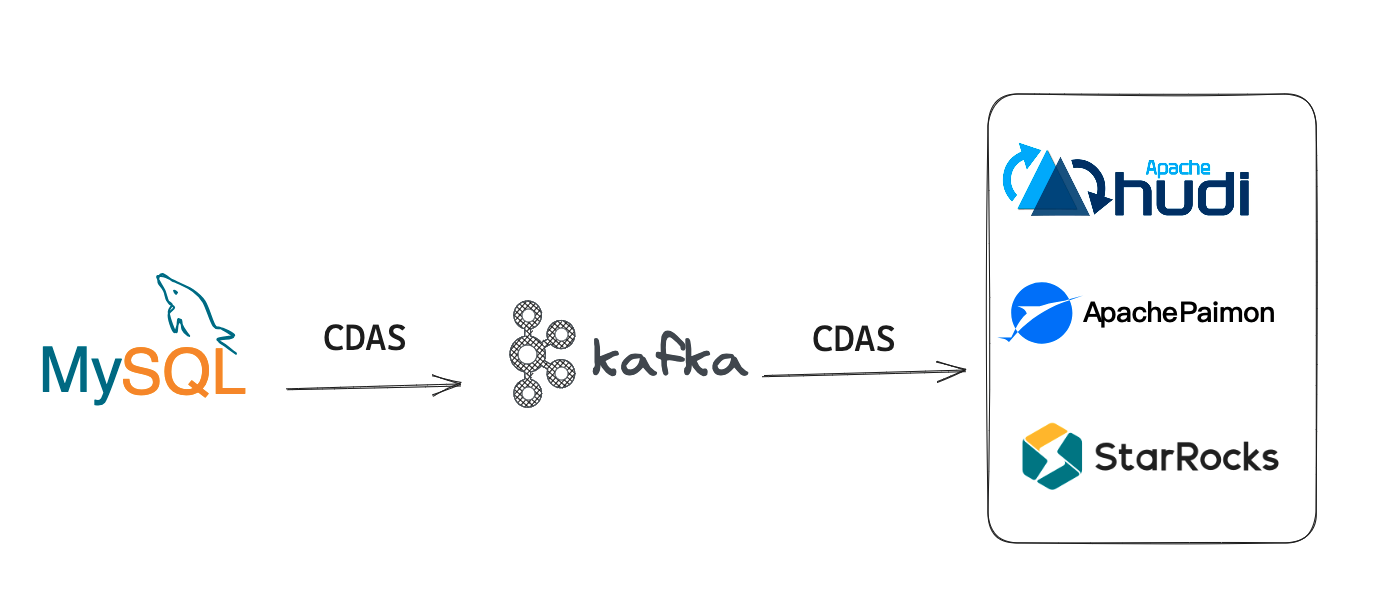

Flink的mysql发生ddl变更后,这个ddl会修改kafka的数据吗?然后这个ddl还会存在kafka中吗?下游的sr或者paimon会收到ddl变更吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 Flink 中,如果您使用了 CDC(Change Data Capture)来从 MySQL 中读取数据并写入 Kafka,那么当 MySQL 中发生 DDL(Data Definition Language)变更时,这个变更不会自动同步到 Kafka 中。因为 CDC 只会监控 MySQL 中的数据变更,而不会监控数据库结构的变更。

当 MySQL 中的表结构发生变更时,如果您需要将这个变更同步到 Kafka 中,需要进行以下几个步骤:

停止 Flink 作业:在 MySQL 发生结构变更后,需要暂停 Flink 作业,以避免因结构变更导致数据读取错误。

更新 Flink 作业代码:将 Flink 作业代码中的表结构定义更新为最新的结构定义。

重启 Flink 作业:在更新表结构定义后,重新启动 Flink 作业。此时,Flink 会重新从 MySQL 中读取数据,并将更新后的数据写入到 Kafka 中。

Flink 中的 MySQL 发生 DDL 变更后,并不会直接修改 Kafka 中的数据。Kafka 是一个分布式流数据平台,主要用于消息传递和持久化存储。它并不会自动感知和响应数据库的 DDL 变更。

当 MySQL 数据表发生 DDL 变更时,例如添加、删除或修改字段,这些变更不会自动同步到 Kafka 中的数据。如果您希望将变更后的数据同步到 Kafka 中,需要在 Flink 程序中进行相应的处理。

通常情况下,可以使用 Flink CDC(Change Data Capture)来监听 MySQL 数据库的变更,并将变更的数据发送到 Kafka 主题中。Flink CDC 可以捕获数据库的变更日志(binlog),并将其转换为流式数据。然后,您可以使用 Flink 的 DataStream API 或 Flink SQL 将这些变更的数据写入到 Kafka 中。

至于 Kafka 中是否会保留 DDL 变更信息,取决于您的具体实现方式。通常情况下,DDL 变更不会直接存储在 Kafka 中,而是通过 Flink 程序从 MySQL 的 binlog 中提取并处理。

下游的消费者(如 Spark Streaming 或 Paimon)不会直接收到 MySQL 数据表发生的 DDL 变更信息。如果您希望下游的消费者能够感知到 DDL 变更,您可能需要在 Flink 程序中编写额外的逻辑来获取和处理 DDL 变更,并将变更通知到下游。

总结而言,Flink 中的 MySQL 数据表发生 DDL 变更并不会直接修改 Kafka 中的数据。需要借助 Flink CDC 监听变更日志,并通过 Flink 程序将变更的数据写入到 Kafka 中。Kafka 中一般不会保留原始的 DDL 变更信息。下游的消费者需要额外的逻辑才能感知到 DDL 变更。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。