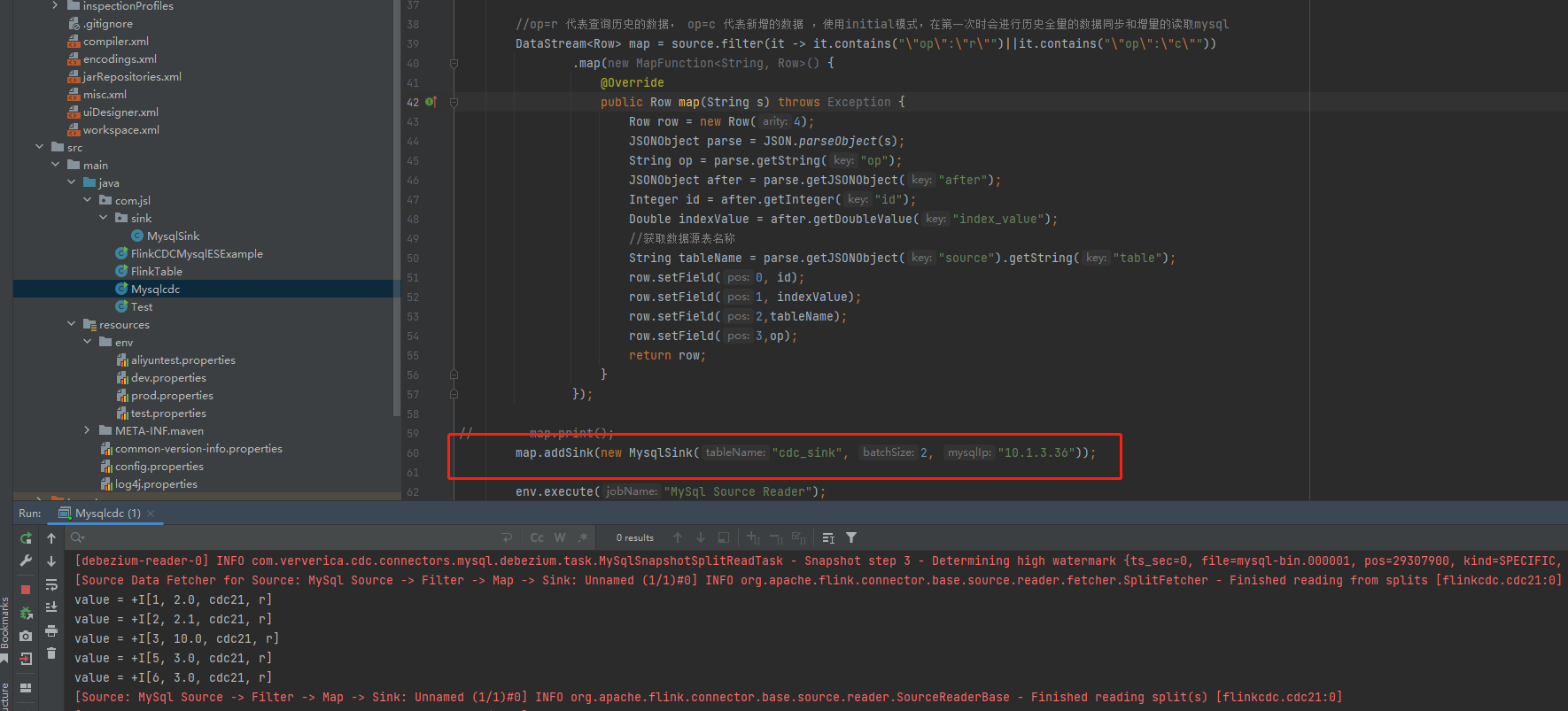

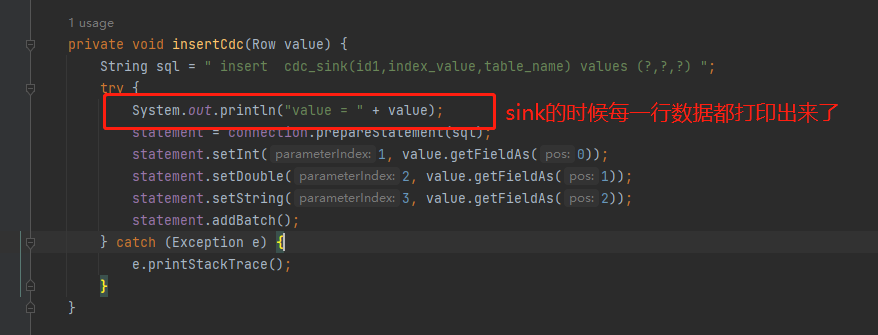

Flink CDC中我想用cdc同步新增的数据,更新和删除的不管, 但是在测试的时候发现,写入到目标库的时候数据减少了很多 ,有知道可能是什么原因的吗?

没对数据做任何出处理, 就是 source - filter - sink。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用 Flink CDC 进行数据同步时,数据丢失的原因可能有很多,以下是一些可能的原因和解决方案:

数据源的 binlog 模式不一致:如果源数据的 binlog 模式为 STATEMENT,而目标数据的 binlog 模式为 ROW,可能会出现数据丢失的情况,因为 STATEMENT 模式下更新语句可能不包含所有的列,导致部分数据丢失。建议将源数据和目标数据的 binlog 模式设置为相同的模式。

目标表的主键或唯一键重复:如果目标表的主键或唯一键已经存在相同的值,可能会导致部分数据插入失败,从而出现数据丢失的情况。建议检查目标表的主键或唯一键是否正确,以及是否存在重复的值。

CDC 配置不正确:如果 CDC 的配置不正确,可能会导致部分数据丢失。例如,如果 CDC 的过滤条件不正确,可能会导致部分数据没有被采集到。建议检查 CDC 的配置是否正确,并根据实际情况进行调整。

数据源和目标数据的时区不一致:如果源数据和目标数据的时区不一致,可能会导致时间戳数据出现偏差,从而出现数据丢失的情况。建议在 CDC 中使用统一的时区,并根据实际情况将时间戳数据转换为 UTC 时间。

CDC 任务的并发度设置不正确:如果 CDC 的并发度设置过高或过低,可能会导致部分数据丢失。如果并发度设置过高,可能会导致资源浪费和竞争冲突,从而导致数据丢失。如果并

这可能是由于 Flink CDC 的同步策略导致的。Flink CDC 是基于时间戳进行同步的,如果目标表中的数据没有按照时间戳排序,那么 Flink CDC 就无法正确地识别新增、更新和删除的数据。可以尝试在目标表中创建一个时间戳列,并将其设置为自动递增,然后将该列作为主键。这样,Flink CDC 就可以根据时间戳来识别新增、更新和删除的数据了。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。