问题1:你好 我想问下 我想用dataworks 迁移OTS里面存储的大概10T的数据 但是超过3天就终止任务了 有什么别的办法跑吗?OTS没有时间戳 所以拆分不准确 所以需要全量同步出去

问题2:4MB/s 这个速度的上限取决于哪里呢 是dataworks本身有速度限制还是要去OTS查看读取速度?? OSS写入有限制吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

如果你使用DataWorks迁移OTS中大约10TB的数据时,由于任务执行时间超过了默认的3天限制导致任务被终止,你可以考虑以下几种方法来解决这个问题:

增量同步:如果OTS表中的数据是按照时间顺序逐渐增加的,你可以尝试使用增量同步的方式来迁移数据。首先,执行一次全量同步将现有的数据迁移到目标端,然后使用增量同步方式将新插入的数据同步到目标端。增量同步只需要同步新增的数据,可以在任务时间限制内完成。

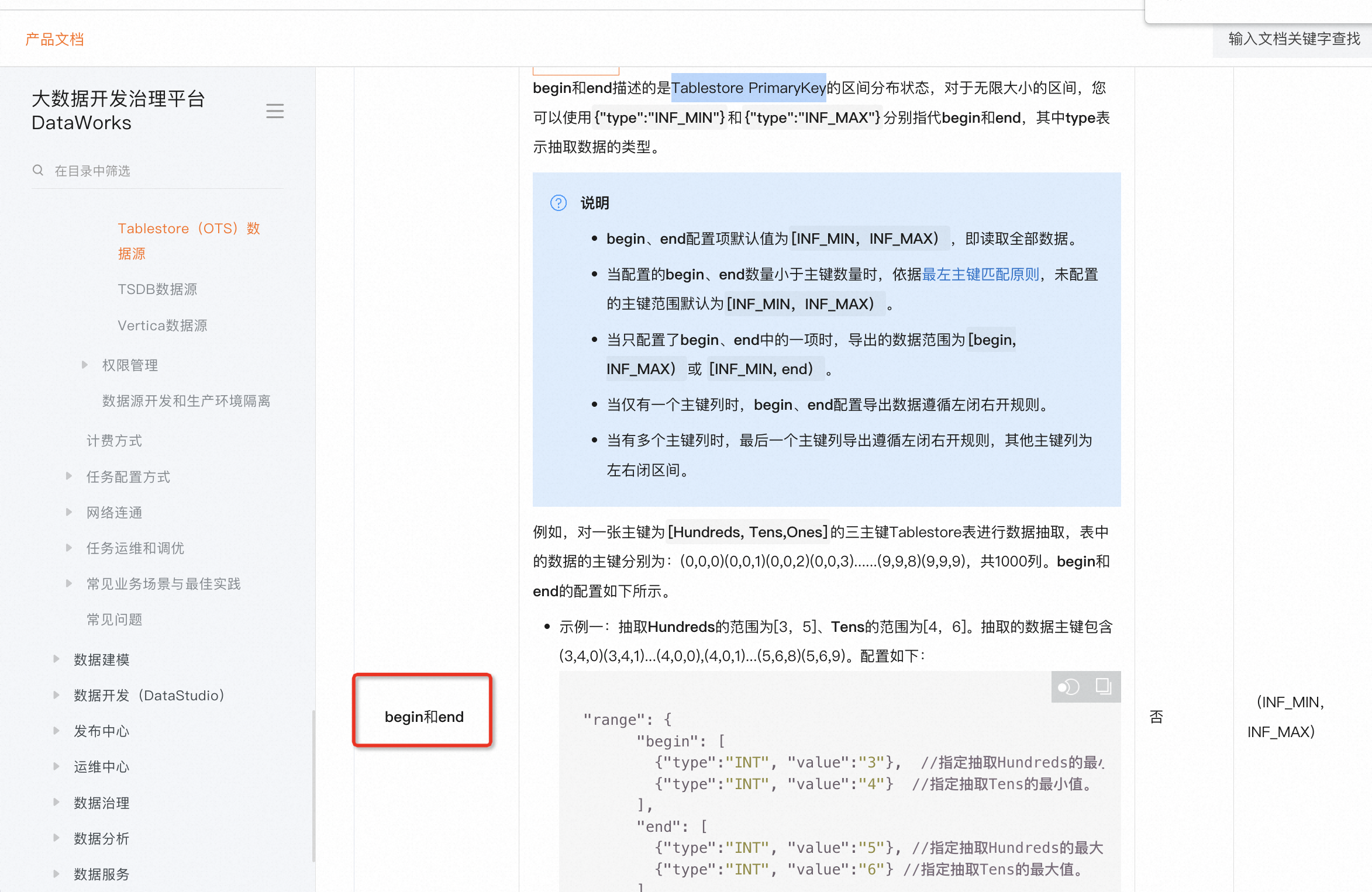

分批迁移:将整个数据集分成多个较小的批次进行迁移。每个批次只迁移一部分数据,确保在任务时间限制内完成。可以通过按照数据的某种规则(如按照主键范围划分)划分数据集,然后依次迁移每个批次的数据。

自定义任务:如果DataWorks的任务时间限制无法满足你的需求,你可以尝试使用其他工具或自定义脚本来进行迁移。你可以编写自己的迁移脚本,利用OTS的API和目标端的API进行数据的抽取和加载。这样可以更好地控制迁移过程和任务执行时间。

问题1:如果要迁移OTS中大约10TB的数据,并且任务超过了DataWorks的默认3天限制,你可以考虑以下几种方案:

将任务拆分为多个子任务:将数据迁移任务拆分为多个较小的子任务,每个子任务处理部分数据。这样可以避免单个任务超过时间限制。你可以使用DataWorks的流程控制节点(如循环节点)来实现任务拆分和组织。

自定义代码或脚本:使用自定义代码或脚本来完成数据迁移任务。你可以在DataWorks中创建一个Shell节点或者Python节点,并编写相应的代码来操作OTS数据并导出到目标存储。这样可以更灵活地控制任务执行时间。

考虑使用其他工具或方法:如果DataWorks的功能无法满足需求,你还可以考虑使用其他数据迁移工具或方法,例如使用阿里云的DataX工具、自定义开发ETL程序等。

需要注意的是,在进行大规模数据迁移时,需谨慎评估网络带宽、数据安全性、任务可靠性等因素,并确保资源和权限的正确配置。

问题2:关于速度限制,DataWorks本身对于任务执行有一定的并发度和资源限制,这可能会影响任务的执行速度。此外,不同的组件和服务(如OTS、OSS)也有自身的限制和性能瓶颈。

对于OTS的读取速度,你可以参考OTS文档中的相关信息,了解其读取性能和吞吐量的限制。如果需要提高读取速度,可以考虑增加并发请求或者优化读取方式。

对于OSS的写入速度,OSS本身具有较高的并发处理能力,但也有一些限制,如存储类型(标准存储、低频访问存储等)和区域(不同区域的访问速度可能会有差异)。你可以根据具体情况评估并选择合适的存储类型和区域以满足需求。

回答1:数据非常多吗 看能不能拆分任务跑一下,没有其他数值类型的主键可以过滤吗 设置split并且增加并发数一般可以提速 可以试试

https://help.aliyun.com/zh/dataworks/user-guide/tablestore-data-source?spm=a2c4g.11186623.0.0.4df133d26xslaj#task-2314772

目前任务的并发数和速度大概是多少呢 在运行日历里 搜索detail log 里面有打印大致的同步速度 可以作为参考

回答2:速度到影响因素有很多 包含数据库本身性能 网络等 可以参考下这篇提速 https://developer.aliyun.com/article/979768?spm=a2c6h.12873639.article-detail.79.7d3372fbAwTBZy,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。