Modelscope这个模型支持用gpu推理吗?

Modelscope这个模型支持用gpu推理吗?

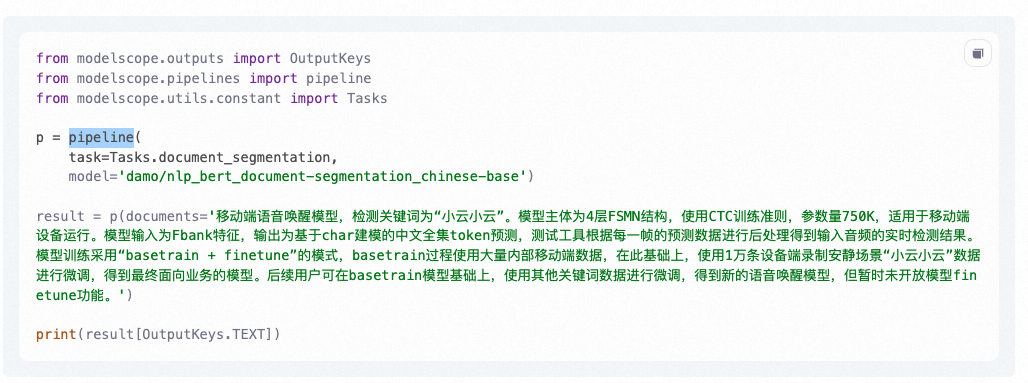

damo/nlp_bert_document-segmentation_chinese-base

-

是的,ModelScope 模型支持使用 GPU 进行推理。GPU 的并行计算能力可以显著提高模型的推理速度,并且特别适用于涉及大规模数据和复杂计算的深度学习任务。

要在 ModelScope 中使用 GPU 进行推理,您需要确保以下几点:

安装 GPU 驱动程序:首先,请确保您的计算机上已正确安装了适当版本的 GPU 驱动程序。这通常需要访问 GPU 制造商(如 NVIDIA、AMD)的官方网站并按照指示进行安装。

安装 CUDA 和 cuDNN:除了 GPU 驱动程序外,您还需要安装相应版本的 CUDA 和 cuDNN 库。这些库提供了用于 GPU 计算的加速功能,并与深度学习框架(如 TensorFlow、PyTorch)进行集成。

配置 ModelScope:在 ModelScope 的配置中,确保选择了正确的 GPU 设备,并设置了适当的 GPU 相关参数。这样,ModelScope 将使用 GPU 来执行模型推理。

请注意,在使用 GPU 进行推理时,还需要考虑到 GPU 的内存限制、并行计算的最佳实践和性能优化等方面。具体的配置和设置可能因 ModelScope 平台、模型架构和硬件环境而有所不同。

2023-07-24 13:31:51赞同 展开评论 -

-

北京阿里云ACE会长

是的,Modelscope支持使用GPU进行推理。具体来说,可以使用CUDA-enabled GPUs来加速模型推理,从而提高推理性能。

对于模型 "damo/nlp_bert_document-segmentation_chinese-base",您可以在使用Modelscope时指定GPU设备来进行推理。例如,您可以使用以下代码来加载模型并指定GPU设备:

ini

Copy

from transformers import pipelinepipe = pipeline(

task="text-segmentation",

model="damo/nlp_bert_document-segmentation_chinese-base",

tokenizer="bert-base-chinese",

device=0 # 指定GPU设备编号

)result = pipe("这是一个文本段落,需要进行分段。")

print(result)

在上述代码中,我们使用了device参数来指定使用的GPU设备。其中,设备编号从0开始,代表第一块可用的GPU设备。如果您的计算机上有多块GPU设备,您可以修改device参数来选择不同的GPU设备。2023-07-22 09:00:11赞同 展开评论 -

从事java行业9年至今,热爱技术,热爱以博文记录日常工作,csdn博主,座右铭是:让技术不再枯燥,让每一位技术人爱上技术

您好,BERT文本分割是可以支持GPU推理的,并且可以利用GPU的计算能力来加速推理过程。因此,我们可以使用GPU来训练和推理BERT文本分割模型,从而提高模型的实际应用效率。

2023-07-21 21:42:15赞同 展开评论