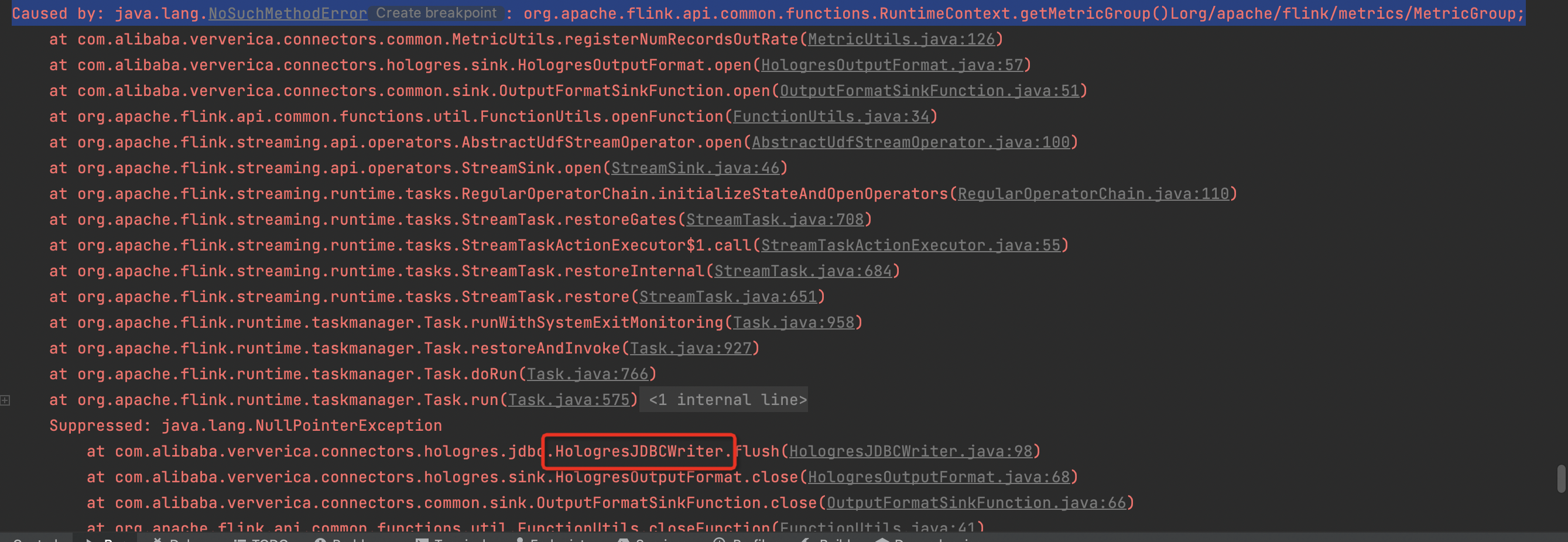

flink cdc中我在sink 那里添加 holoJDBCWriter 报错了,什么原因?

flink cdc中我在sink 那里添加 holoJDBCWriter 报错了,我看报找不到的类在 flink-core 里能找到,什么原因?感觉像是jar包冲突了。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

北京阿里云ACE会长

如果在 Flink CDC 中使用 HoloJDBCWriter 作为 Sink,可能会出现以下错误:

Copy

java.lang.NoClassDefFoundError: org/rocksdb/RocksDBException

这个错误通常是由于 HoloJDBCWriter 依赖的 RocksDB 库无法正确加载导致的。解决这个错误的方法是在 Flink 的配置文件中添加 RocksDB 依赖,具体步骤如下:

在 Flink 的配置文件中添加 RocksDB 依赖:

stylus

Copy

flink.sql.client.local-parallelism: 1

flink.sql.client.execution.result-mode: table

flink.sql.client.instance.enabled: true

flink.sql.client.instance.name: sql-client

flink.sql.client.instance.description: 'Flink SQL CLI Client'

flink.sql.client.instance.parallelism: 1

flink.sql.client.instance.num-task-managers: 1

flink.sql.client.instance.num-task-slots: 1

flink.sql.client.instance.memory: 1g

flink.sql.execution.type: batch

flink.sql.client.network.port: 8083

state.backend.type: rocksdb

重新启动 Flink 服务。

重新启动 Flink 服务后,您应该能够正常使用 HoloJDBCWriter 作为 Sink,以将数据同步到 HoloDB 中2023-07-29 19:55:38赞同 展开评论 -

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。