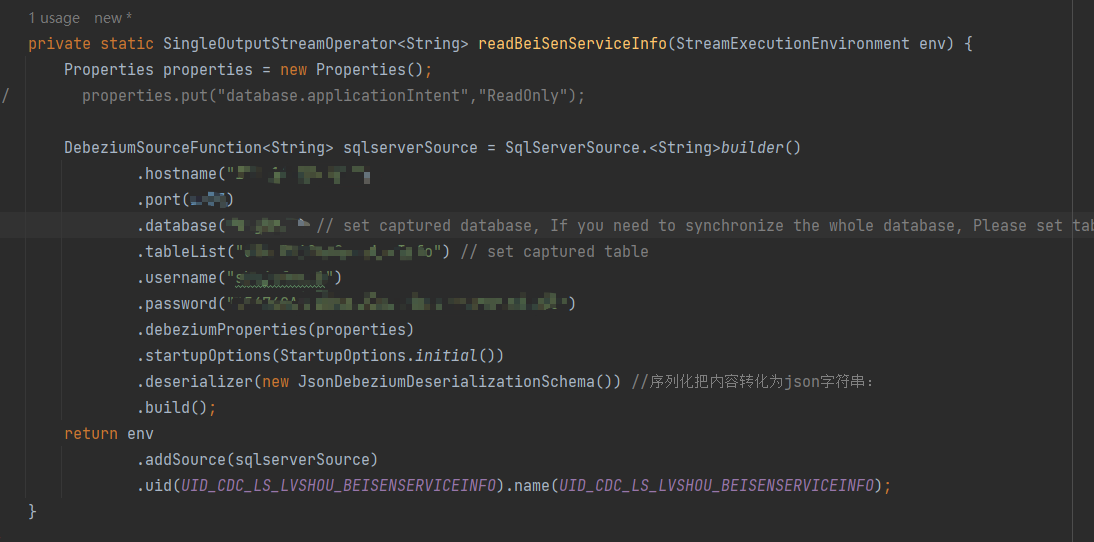

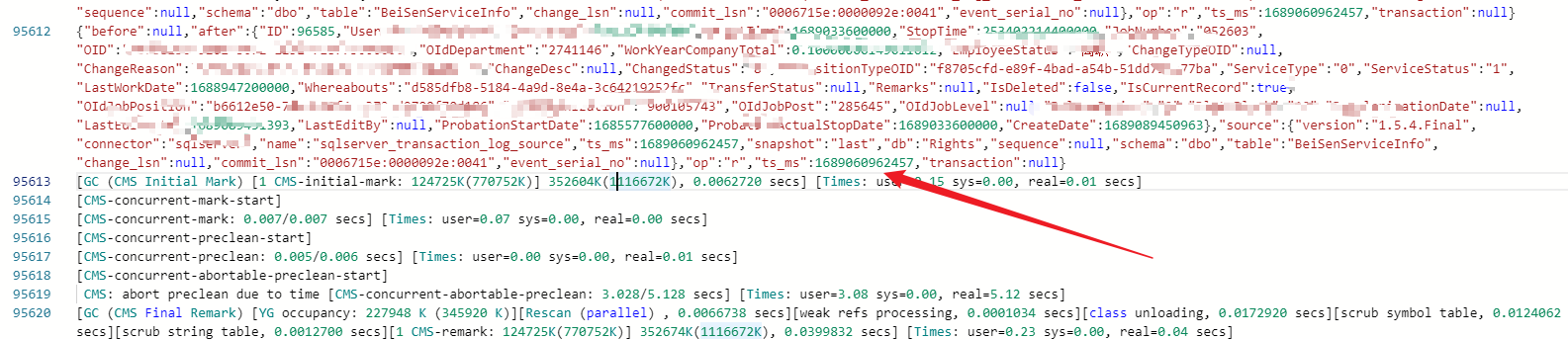

flink cdc读取sqlserver,cdc已经开了,cdc表也有数据,但是写不进kafka,你们知道是什么什么问题吗?能读到全量数据,但读不到增量,换了debezium框架也一样。有控制台print,时间没有更新,只能读到全量的,启动模式选的initial。

然后打印出来只有初始化全量数据,新增修改删除的没有记录。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 Flink CDC 中读取 SQL Server 并将数据写入 Kafka 时,如果 CDC 已经开启,CDC 表中也有数据,但是数据无法写入 Kafka,可能是由以下原因引起的:

Kafka 连接异常

在 Flink CDC 中,将数据写入 Kafka 时,需要确保 Kafka 连接正常。可以检查 Kafka 的连接参数、Kafka 服务的状态和网络连接等方面,确保 Kafka 可以正常连接。

Kafka Topic 配置异常

在 Flink CDC 中,将数据写入 Kafka 时,需要确保 Kafka Topic 配置正确。可以检查 Kafka Topic 的配置参数和分区数等方面,确保 Kafka Topic 可以正确接收数据。

Flink CDC 配置异常

在 Flink CDC 中,将数据写入 Kafka 时,需要确保 Flink CDC 配置正确。可以检查 Flink CDC 配置文件中的数据源配置、数据同步配置和目标配置等方面,确保配置正确无误。

应用程序异常

在 Flink CDC 中,将数据写入 Kafka 时,也可能是由于应用程序异常导致的。可以检查 Flink CDC 应用程序的日志和异常信息,找出应用程序异常的原因,并进行相应的处理。

针对无法将 SQL Server 中的 CDC 数据写入 Kafka 的问题,可以尝试以下解决方法:

如果sls数据更新太快,试试微批写数据到holo,holo结果表配置下就行。

这里没看到flink相关日志,可以新增数据后看看有没有日志变化。

这个是执行开启的命令,查看是否开启有另外的语句。配置:https://help.aliyun.com/document_detail/607369.html?spm=a2c4g.606719.0.0,你这个数据是holo去重后统计的结果吧?holo的吞吐量很强的。需要加下这个参数 properties.put(""database.history.kafka.topic"",""ls_BeiSenServiceInfo_his"");

此回答整理至钉群“Flink CDC 社区”。"

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。