请问flinkcdc中那个加了源后,后面怎么写 sink的处理逻辑呢?

问题1:请问flinkcdc中那个加了源后,后面怎么写 sink的处理逻辑呢?

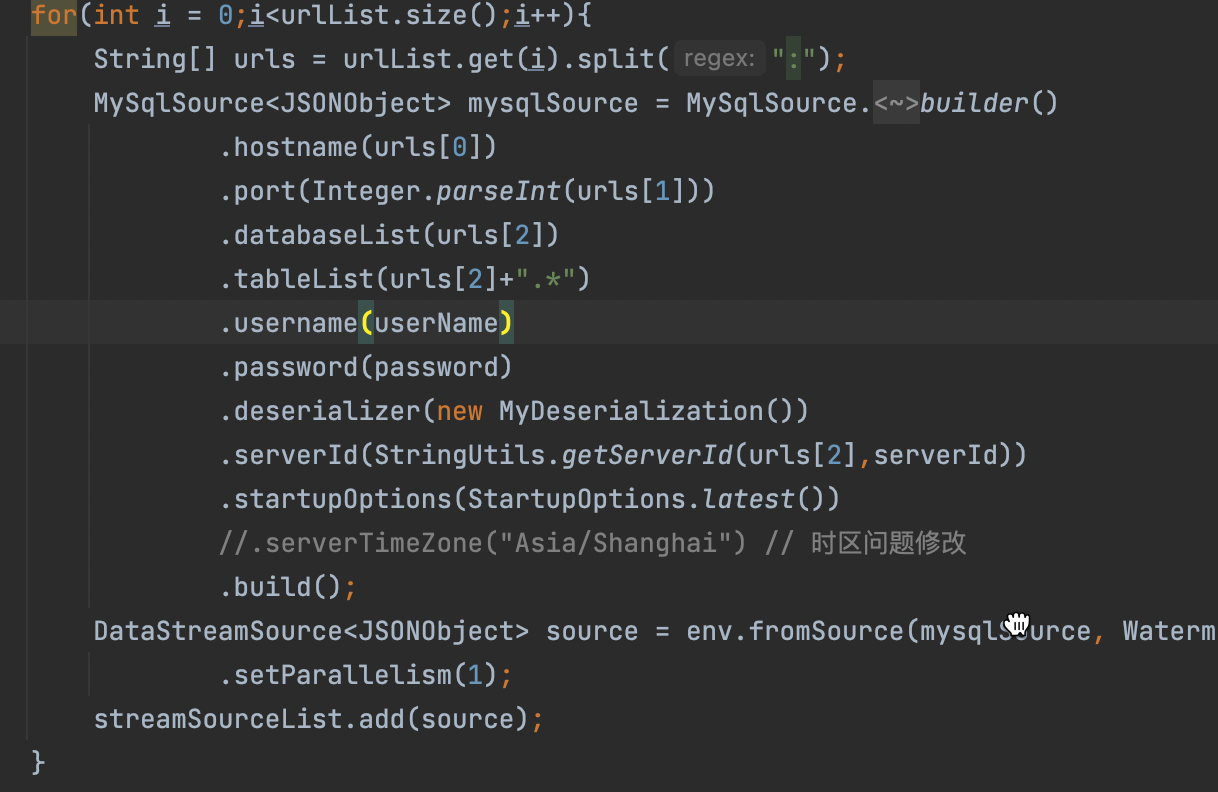

问题2:我现在是,多个不同的数据库的不同分表得同步到一个表里面,所以存在多数据源合并的问题,所以后面的sink怎么写?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

北京阿里云ACE会长

在 Flink CDC 中,您可以使用 Flink DataStream API 来实现从 CDC 源中捕获的数据的转换和处理,以及将数据写入到目标系统中的逻辑。以下是一些示例代码,演示了如何使用 Flink DataStream API 实现 CDC 源和目标的处理逻辑。

将 CDC 数据写入到 Kafka 主题中:

java

Copy

// 创建 FlinkCDCSource

FlinkCDCSource source = new FlinkCDCSource<>(cdcConfig);// 创建 KafkaProducer

Properties props = new Properties();

props.setProperty("bootstrap.servers", "localhost:9092");

FlinkKafkaProducer sink = new FlinkKafkaProducer<>("my-topic", new SimpleStringSchema(), props);// 创建 Flink 程序

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStream stream = env

.addSource(source)

.map(new CDCRecordMapper())

.map(new MyMapperFunction())

.addSink(sink);// 执行 Flink 程序

env.execute("Flink CDC to Kafka");

在上面的示例代码中,我们首先创建了一个 FlinkCDCSource,用于从 CDC 源中读取数据。然后,我们创建了一个 KafkaProducer,用于将 CDC 数据写入到 Kafka 主题中。接下来,我们使用 Flink DataStream API 创建了一个 Flink 程序,其中包含了 CDC 数据的转换和处理逻辑。最后,我们调用 env.execute() 方法来执行 Flink 程序。将 CDC 数据写入到数据库表中:

java

Copy

// 创建 FlinkCDCSource

FlinkCDCSource source = new FlinkCDCSource<>(cdcConfig);// 创建 JDBCOutputFormat

JDBCOutputFormat jdbcOutputFormat = JDBCOutputFormat.buildJDBCOutputFormat()

.setDrivername("org.postgresql.Driver")

.setDBUrl("jdbc:postgresql://localhost:5432/test")

.setUsername("postgres")

.setPassword("mypassword")

.setQuery("INSERT INTO my_table (id, name) VALUES (?, ?)")

.finish();// 创建 Flink 程序

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStream stream = env

.addSource(source)

.map(new CDCRecordMapper())

.map(new MyMapperFunction())

.writeUsingOutputFormat(jdbcOutputFormat);// 执行 Flink 程序

env.execute("Flink CDC to JDBC");

在上面的示例代码中,我们首先创建了一个 FlinkCDCSource,用于从 CDC2023-07-29 20:13:09赞同 展开评论 -

意中人就是我呀!

"回答1:我是每个资源都是一个处理逻辑。

回答2:把不同的原给加入进去,然后addsourc,会返回一个新的datastream,然后在对新的datastream做处理sink。此回答整理至钉群“Flink CDC 社区”。"2023-07-19 17:39:14赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。