各位老师 Flink中mongoDB 能过滤历史数据 OracleSource 如何过滤历史数据只

各位老师 Flink中mongoDB 能过滤历史数据 OracleSource 如何过滤历史数据只要最新的?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

北京阿里云ACE会长

在 Flink 中使用 MongoDB 来过滤历史数据,你可以考虑使用 Flink 的 MongoDB Connector 和 Flink 的 DataStream API 来实现。具体步骤如下:

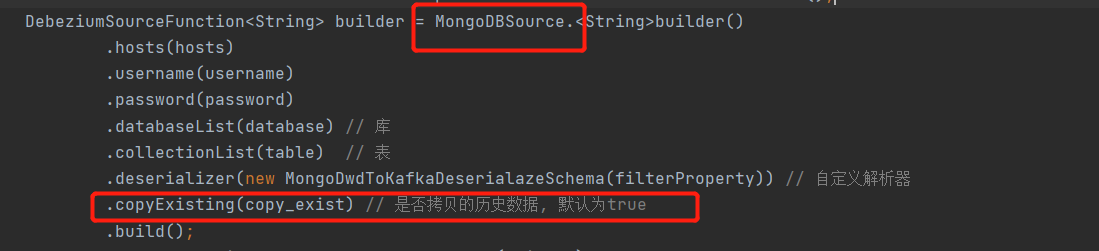

使用 Flink 的 MongoDB Connector 创建 MongoDB 数据源。你可以使用 Flink 的 MongoDB Connector 来连接到 MongoDB 数据库,并创建一个 MongoDB 数据源。你可以使用 MongoDB Connector 提供的 MongoDBSource 类来创建数据源,并在 open() 方法中执行 MongoDB 查询语句,以读取历史数据。

示例代码:java

Copy

MongoClientURI uri = new MongoClientURI("mongodb://localhost:27017");

MongoClient client = new MongoClient(uri);

MongoDatabase database = client.getDatabase("test");

MongoCollection collection = database.getCollection("my_collection");MongoDBSource source = MongoDBSource.builder()

.withDatabaseUri("mongodb://localhost:27017/test")

.withCollection("my_collection")

.withQuery("{ $and: [ { field1: 'value1' }, { field2: 'value2' } ] }")

.withReturnType(String.class)

.build();

使用 Flink 的 DataStream API 处理数据。一旦你创建了 MongoDB 数据源,你可以使用 Flink 的 DataStream API 来处理数据,并过滤历史数据。你可以使用 filter() 方法来过滤数据,并在 map() 方法中将 MongoDB 数据转换为 Flink 中的数据类型。

示例代码:java

Copy

DataStream dataStream = env.addSource(source);DataStream filteredStream = dataStream

.filter(new MyFilterFunction())

.map(new MyMapFunction());

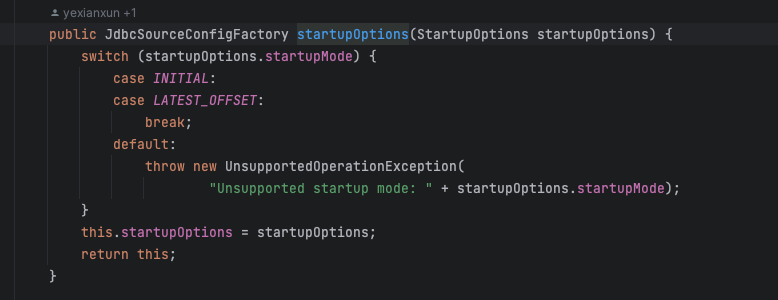

如果你要在 Flink 中使用 OracleSource 来过滤历史数据,你可以使用 Oracle JDBC 驱动程序和 Flink 的 DataStream API 来实现。具体步骤如下:使用 Oracle JDBC 驱动程序创建 Oracle 数据源。你可以使用 Oracle JDBC 驱动程序来连接到 Oracle 数据库,并创建一个 Oracle 数据源。你可以使用 JDBC 驱动程序提供的 PreparedStatement 来执行 SQL 查询语句,以读取历史数据。

示例代码:java

Copy

Class.forName("oracle.jdbc.driver.OracleDriver");

Connection connection = DriverManager.getConnection("jdbc:oracle:thin:@//localhost:1521/mydb", "myuser", "mypassword");

PreparedStatement statement = connection.prepareStatement("SELECT * FROM mytable WHERE field1 = ? AND field2 = ?");

statement.setString(1, "value1");

statement.setString(2, "value2");

ResultSet resultSet = statement.executeQuery();

使用 Flink 的 DataStream API 处理数据。一旦你创建了 Oracle 数据源,你可以使用 Flink 的 DataStream API 来处理数据,并过滤历史数据。你可以使用 filter() 方法来过滤数据,并在 map() 方法中将 Oracle 数据转换为 Flink 中的数据类型。

示例代码:java

Copy

DataStream dataStream = env.createInput(JdbcInputFormat.buildJdbcInputFormat()

.setDrivername("oracle.jdbc.driver.OracleDriver")

.setDBUrl("jdbc:oracle:thin:@//localhost:1521/mydb")

.setUsername("myuser")

.setPassword("mypassword")

.setQuery("SELECT * FROM mytable WHERE field1 = 'value1' AND field2 = 'value2'")

.finish());DataStream filteredStream = dataStream

.filter(new MyFilterFunction())

.map(new MyMapFunction());2023-07-29 21:22:40赞同 展开评论 -

在 Flink 中,您可以使用不同的方法来过滤历史数据,无论是从 MongoDB 还是 OracleSource 中获取数据。

对于 MongoDB: 1. 使用 Flink 的 Connector for MongoDB,您可以通过编写自定义的查询条件来过滤历史数据。在创建 MongoDB 的 DataStream 或 Table 时,可以使用

filter()方法指定查询条件,例如根据时间戳字段或其他字段进行过滤。示例代码:

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(); StreamTableEnvironment tEnv = StreamTableEnvironment.create(env); // 创建 MongoDB 数据源表 tEnv.executeSql("CREATE TABLE myMongoDBTable ( id STRING, timestamp TIMESTAMP, -- other fields ) WITH ( 'connector' = 'mongodb', 'uri' = 'mongodb://localhost:27017', 'database' = 'myDatabase', 'collection' = 'myCollection', 'filter' = 'timestamp > CAST(\'2022-01-01\' AS TIMESTAMP)' -- 过滤条件 )"); // 在查询中使用过滤条件 Table result = tEnv.sqlQuery("SELECT * FROM myMongoDBTable WHERE timestamp > CAST('2022-01-01' AS TIMESTAMP)");对于 OracleSource: 1. 使用 Flink 的 JDBC Connector,您可以在 SQL 查询中使用过滤条件来只获取最新的数据。可以使用

ORDER BY和LIMIT子句来按照时间戳字段降序排序并限制结果集大小。示例代码:

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(); StreamTableEnvironment tEnv = StreamTableEnvironment.create(env); // 创建 Oracle 数据源表 tEnv.executeSql("CREATE TABLE myOracleTable ( id STRING, timestamp TIMESTAMP, -- other fields ) WITH ( 'connector' = 'jdbc', 'url' = 'jdbc:oracle:thin:@localhost:1521:orcl', 'table-name' = 'myTable', 'driver' = 'oracle.jdbc.driver.OracleDriver' )"); // 在查询中使用排序和限制条件 Table result = tEnv.sqlQuery("SELECT * FROM myOracleTable ORDER BY timestamp DESC LIMIT 1");请注意,以上示例代码仅为演示目的,实际情况需要根据您的数据源和具体需求进行调整。另外,确保在连接数据库时提供正确的连接信息和驱动程序。

如果您遇到更复杂的过滤需求,也可以考虑使用 Flink 的自定义函数(UDF)来编写特定的过滤逻辑。

2023-07-29 19:21:33赞同 展开评论 -

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。