最好别给我发阿里云上demo了,还有别的demo吗?

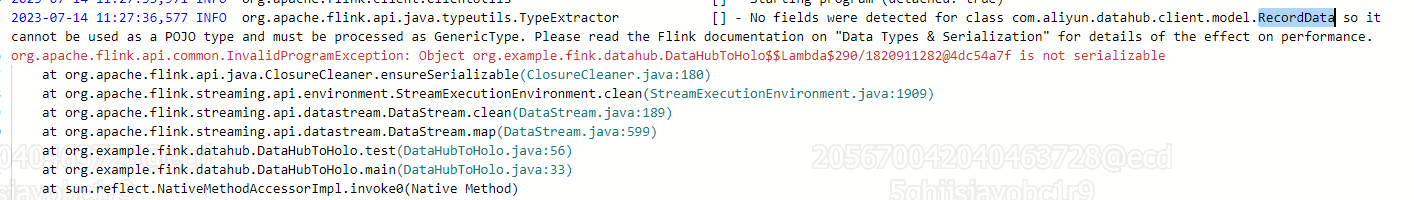

我就是仿照阿里云上写的javaDemo,我打成jar包部署后,finkjob运行异常

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

当使用阿里云 Flink 1.11 版本时,你可以通过以下步骤来使用 DataHub 作为数据源:

Maven:

<dependency>

<groupId>com.aliyun.datahub</groupId>

<artifactId>aliyun-sdk-datahub-connector-flink_2.11</artifactId>

<version>最新版本号</version>

</dependency>

Gradle:

implementation 'com.aliyun.datahub:aliyun-sdk-datahub-connector-flink_2.11:最新版本号'

请注意将 最新版本号 替换为实际可用的 DataHub Connector 版本。

public class DataHubFlinkJob {

public static void main(String[] args) throws Exception {

// 创建 Streaming Execution Environment

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 创建 StreamTableEnvironment

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

// 创建 DataHubCatalog

DataHubCatalog dataHubCatalog = new DataHubCatalog("datahub", "accessKeyId", "accessKeySecret", "projectName");

// 注册 DataHubCatalog

tableEnv.registerCatalog("datahub", dataHubCatalog);

// 创建表并读取 DataHub 数据

tableEnv.executeSql("CREATE TABLE datahub_table (\n" +

" col1 STRING,\n" +

" col2 INT\n" +

") WITH (\n" +

" 'connector' = 'datahub',\n" +

" 'topic' = 'your_topic_name',\n" +

" 'properties.endpoint' = 'http://your_datahub_endpoint',\n" +

" 'properties.accessKeyId' = 'your_access_key_id',\n" +

" 'properties.accessKeySecret' = 'your_access_key_secret'\n" +

")");

// 执行查询操作

tableEnv.executeSql("SELECT * FROM datahub_table").print();

// 启动 Flink Job

env.execute("DataHub Flink Job");

}

}

```

请将示例代码中的参数(accessKeyId, accessKeySecret, projectName, your_topic_name, your_datahub_endpoint)替换为实际的阿里云账号信息和 DataHub 配置。

除了上述阿里云官方提供的 Java 示例之外,你还可以参考 Flink 官方文档中的 DataStream API 和 Table API 的相关章节,自行编写适合你的业务需求的代码。这样可以更灵活地控制数据处理流程和逻辑。

要使用阿里云的Flink(1.11版本)将DataHub作为数据源,您可以按照以下步骤进行设置:

pom.xml文件中添加以下内容:<dependencies>

<!-- DataHub Connector -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-datahub_2.11</artifactId>

<version>${flink.version}</version>

</dependency>

</dependencies>

确保${flink.version}是您所使用的Flink版本。

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.datahub.DatahubSource;

import org.apache.flink.streaming.connectors.datahub.util.DatahubConfig;

public class DataHubSourceDemo {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 配置DataHub连接信息

DatahubConfig config = new DatahubConfig("endpoint", "projectName", "topicName",

"accessKeyId", "accessKeySecret");

// 创建DataHub输入源

DatahubSource source = new DatahubSource(config);

// 添加DataHub输入源到执行环境中

env.addSource(source).print();

// 执行任务

env.execute("DataHub Source Demo");

}

}

请根据您的实际情况修改endpoint、projectName、topicName、accessKeyId和accessKeySecret参数。您可以从阿里云控制台获取这些信息。

这是一个基本的示例代码,用于将DataHub作为Flink的数据源。您可以根据自己的需求对其进行调整和优化。

请注意,以上示例中使用的是Flink 1.11版本的DataHub Connector。确保您的Flink版本与之兼容,并在项目的maven依赖中引入正确的版本。

使用阿里云 Flink 1.11 版本作为计算引擎,可以使用 Flink DataHub Connector 作为数据源来读取阿里云 DataHub 中的数据。以下是具体的步骤:

1.配置 DataHub Consumer

在 Flink 项目中,需要创建一个 FlinkDatahubConsumerConfig 对象来配置 DataHub Consumer。其中,需要设置 DataHub 的 Endpoint、Project、Topic、AccessId、AccessKey 和 StartTimestampMillis 等参数。

2.创建 DataHub Consumer

使用 FlinkDatahubConsumerFactory.createConsumer() 方法来创建 DataHub Consumer。其中,需要传入上一步中创建的 FlinkDatahubConsumerConfig 对象和数据格式化器(例如 SimpleStringSchema)。

3.从 DataHub 中读取数据

使用 env.addSource(consumer) 方法来从 DataHub 中读取数据。其中,env 表示 StreamExecutionEnvironment 对象。

4.处理数据

对从 DataHub 中读取的数据进行处理,例如进行过滤、转换、聚合等操作。

5.输出结果

将处理后的结果输出到下一个操作或外部系统中,例如写入到 Kafka 中。

您可以尝试参考其他的fink job的示例来编写您的程序。fink提供了很多不同类型的job示例,您可以在fink的官方文档中找到这些示例。您也可以在fink的社区中寻求帮助,有很多开发者会提供自己的经验和解决方案。希望这些能够帮助您解决问题。

您可以使用DataStream连接器连接Flink全托管,DataStream连接器设置方法请参见 DataStream连接器使用方法 。 Maven中央库中已经放置了 DataHub DataStream连接器 。 DataHub源表 VVR提供了SourceFunction的实现类DatahubSourceFunction来读取DataHub表数据。以下为读取DataHub表数据的示例:

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(1);

//DataHub连接配置。

env.addSource(new DatahubSourceFunction(datahubConfig))

.print();

env.execute("Read DataHub");

要使用阿里云Flink(1.11)作为数据源,您需要按照以下步骤进行设置:

首先,确保您已经在阿里云上创建了一个DataHub实例,并且已经有一些数据写入到该实例中。

在Flink项目的pom.xml文件中添加以下依赖项:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-datahub_2.11</artifactId>

<version>1.11.0</version>

</dependency>

创建Flink作业并添加所需的导入语句:

```java

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.datahub.FlinkDatahubConsumer;

public class DatahubSourceDemo {

public static void main(String[] args) throws Exception {

final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 设置DataHub的相关配置信息

String endpoint = "<datahub_endpoint>"; // DataHub的Endpoint

String project = "<project_name>"; // DataHub项目名称

String topic = "<topic_name>"; // DataHub主题名称

String accessId = "<access_id>"; // 阿里云AccessKey ID

String accessKey = "<access_key>"; // 阿里云AccessKey Secret

// 创建DataHub消费者

FlinkDatahubConsumer consumer = new FlinkDatahubConsumer(endpoint, project, topic, accessId, accessKey);

// 添加DataHub消费者到作业中

env.addSource(consumer).print();

// 执行作业

env.execute("DataHub Source Demo");

}

}

```

请确保替换上述代码中的<datahub_endpoint>、<project_name>、<topic_name>、<access_id>和<access_key>为您的实际信息。

请注意,以上示例仅用于演示目的,实际情况下您可能需要根据自己的需求进行更详细的配置和逻辑处理。您可以根据阿里云Flink文档进一步了解更多关于使用DataHub的内容和参数配置:https://help.aliyun.com/document_detail/163166.html

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。