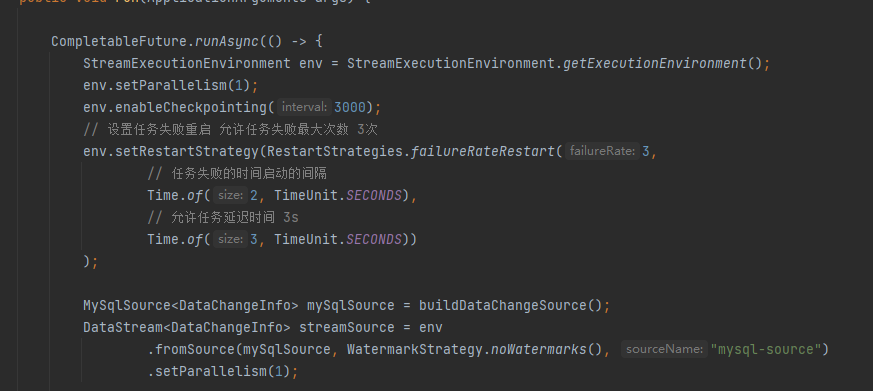

Flink CDC中StartupOptions.initial() 全量监听Mysql写入Redis的时候是乱序的?怎么保证写入是顺序,我数据库是顺序,全量写入Redis是乱序,历史数据要保证顺序呢,我开启的并行度是1

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 Flink CDC 中,StartupOptions.initial() 方法用于指定初始化的 CDC 抓取位置,即从哪个数据变更位置开始抓取数据。如果您希望进行全量监听,并将所有数据变更写入到 Red 中,可以考虑使用以下两种方法:

使用 StartupOptions.initial() 方法指定初始位置为最早的数据变更位置,从而捕获所有数据变更。具体来说,可以使用以下代码:

java

Copy

StartupOptions options = StartupOptions.initial();

上述代码中,StartupOptions.initial() 方法表示使用最早的数据变更位置作为初始位置,从而捕获所有的数据变更。

在 MySQL 数据源中配置全量读取选项,即将 snapshot.isolation.level 参数设置为 repeatable_read。具体来说,可以使用以下代码:

java

Copy

Properties properties = new Properties();

properties.setProperty("snapshot.isolation.level", "repeatable_read");

上述代码中,通过 properties 对象设置 snapshot.isolation.level 参数为 repeatable_read,表示使用全量读取模式捕获数据变更。

在 Flink CDC 中,使用 StartupOptions.initial() 进行全量监听 MySQL 写入 Redis 数据时,如果开启了多并行度,写入到 Redis 的顺序可能会乱序。这是因为在并行处理数据的情况下,不同任务的执行速度和网络延迟等因素都可能导致数据的乱序。

如果您需要保证历史数据的顺序性,可以考虑以下方法:

1. 使用单并行度:将 Flink CDC 的并行度设置为 1,这样所有的数据都将由单个任务处理,从而保证顺序性。

2. 增加排序操作:在写入 Redis 之前,可以通过增加排序操作来恢复数据的顺序。例如,使用 Flink 的 keyBy 操作按照某个字段进行分区,并在处理数据时保持分区内的顺序。然后,在写入 Redis 之前,再次将数据按照顺序合并。

3. 实时处理增量数据:对于历史数据要保持顺序的需求,可以先使用 StartupOptions.initial() 进行全量加载,然后切换到增量模式继续实时处理数据。在增量模式中,Flink CDC 默认的并行度为 1,保证了增量数据的顺序。

历史数据不是顺序的(如果开启多并行度),到增量阶段,增量数据并行度有且是1,保证是顺序的,历史数据保证顺序不太需要,等慢慢追到就行了,此回答整理自钉群“Flink CDC 社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。