flink cdc解析mysql binlog出现中文乱码有什么办法解决吗?在flink-conf.yaml里面加过 env.java.opts: -Dfile.encoding=UTF-8 参数了,测试下来还是会有中文乱码?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

如果在使用 Flink CDC 解析 MySQL binlog 时出现中文乱码问题,您可以尝试以下几种方法解决:

1. 在 Flink 的配置文件(flink-conf.yaml)中设置字符集为 UTF-8。您可以在配置文件中添加以下配置: yaml env.java.opts: "-Dfile.encoding=UTF-8" 这样可以确保 Flink CDC 在读取和解析 MySQL binlog 时使用 UTF-8 字符集,避免中文乱码问题。

2. 在创建 Flink CDC Source 对象时,设置 MySQL 数据库连接的字符集为 UTF-8。您可以使用 FlinkCDCSource.Builder 中的 charset() 方法设置字符集,示例如下: java FlinkCDCSource source = FlinkMySQLSource.builder() .hostname("localhost") .port(3306) .database("mydb") .table("my_table") .username("root") .password("root") .charset("UTF-8") .startupOptions(StartupOptions.latest()) .deserializer(new StringDeserializer()) .build(); 这样可以确保 Flink CDC 在读取和解析 MySQL binlog 时使用正确的字符集,避免中文乱码问题。

3. 在 MySQL 数据库中设置字符集为 UTF-8。您可以使用以下 SQL 语句将 MySQL 数据库和表的字符集设置为 UTF-8: sql ALTER DATABASE mydb CHARACTER SET utf8mb4 COLLATE utf8mb4_unicode_ci; ALTER TABLE my_table CONVERT TO CHARACTER SET utf8mb4 COLLATE utf8mb4_unicode_ci; 这样可以确保 MySQL 数据库和表在存储数据时使用 UTF-8 字符集,与 Flink CDC 解析的字符集保持一致。

通过以上方法中的一种或多种组合,您应该能够解决 Flink CDC 解析 MySQL binlog 出现中文乱码的问题。

果在使用 Flink CDC 解析 MySQL binlog 时出现中文乱码,可能是由于字符集不匹配导致的。您可以尝试以下几个方法解决该问题:

在 Flink 的配置文件(flink-conf.yaml)中设置字符集为 UTF-8。可以在配置文件中添加以下配置:

yaml

Copy

env.java.opts: "-Dfile.encoding=UTF-8"

这样可以确保 Flink CDC 在读取和解析 MySQL binlog 时使用 UTF-8 字符集,避免中文乱码问题。

在创建 FlinkCDCSource 对象时,设置 MySQL 数据库连接的字符集为 UTF-8。可以使用 FlinkCDCSource.Builder 中的 charset() 方法设置字符集,例如:

java

Copy

FlinkCDCSource source = FlinkMySQLSource.builder()

.hostname("localhost")

.port(3306)

.database("mydb")

.table("my_table")

.username("root")

.password("root")

.charset("UTF-8")

.startupOptions(StartupOptions.latest())

.deserializer(new StringDeserializer())

.build();

这样可以确保 Flink CDC 在读取和解析 MySQL binlog 时使用正确的字符集,避免中文乱码问题。

在 MySQL 数据库中设置字符集为 UTF-8。可以使用以下 SQL 语句设置 MySQL 数据库和表的字符集为 UTF-8:

你是datastream吗,UTF-8

UTF-8

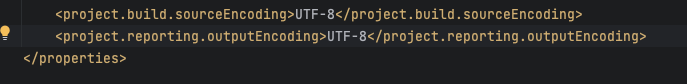

pom的properties里面加这两个 ,此回答整理自钉群“Flink CDC 社区”

,此回答整理自钉群“Flink CDC 社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。