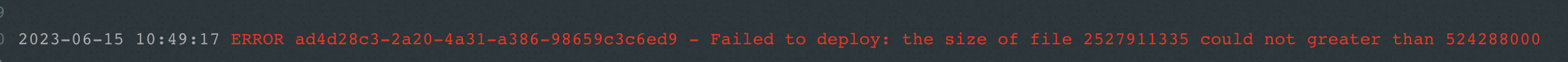

设置了层,但是每次部署都会报 size 过大,这个怎么解啊?

设置了层,但是每次部署都会报 size 过大,这个怎么解啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

缩小输入数据:如果您的输入数据集非常大,可以考虑缩小数据集的大小。

调整Batch size: 通过调整batch size来减少每次迭代所需的内存。

使用更高内存的计算资源:尝试将模型部署到更高内存的计算资源,例如云服务器等。

可以尝试修改模型架构来缩小模型的总参数数量。

根据具体的实际情况,您可以尝试其中的一些或多个解决方案来解决这个问题。

2023-06-16 15:10:15赞同 展开评论 -

公众号:网络技术联盟站,InfoQ签约作者,阿里云社区签约作者,华为云 云享专家,BOSS直聘 创作王者,腾讯课堂创作领航员,博客+论坛:https://www.wljslmz.cn,工程师导航:https://www.wljslmz.com

在阿里云函数计算中,每个函数的代码包大小都有一定的限制。如果您在函数中引用了层,并且每次部署时都会提示层的大小超过限制,那么可能是因为您的层文件过大。

针对这种情况,您可以考虑以下解决方案:

-

分离层文件:将您的层文件拆分成多份,以便缩小每个文件的大小。例如,将一个大型文件分割成多个小文件并分别上传。

-

压缩层文件:将您的层文件压缩成zip格式,并使用阿里云函数计算控制台或CLI工具上传层文件。这样可以有效减小文件大小,同时也提高了上传速度。

-

删除不必要的文件:在上传层文件之前,您可以先对文件进行筛选,删除不必要的文件或代码,以减小文件大小。例如,删除一些不需要的依赖库或测试代码。

在阿里云函数计算中,每个函数的代码和层文件总大小不能超过50MB。如果您的代码和层文件加起来大小仍然超过限制,您可以考虑使用其他部署方式,如OSS触发器或API网关触发器等。

2023-06-16 15:06:36赞同 展开评论 -

-

北京阿里云ACE会长

如果您在部署函数时,设置了层(Layer),但是每次部署都会报 size 过大,可能是因为层的大小超过了云服务商的限制。不同的云服务商对层的大小限制不同,例如 AWS Lambda 对层的大小限制为 50 MB,阿里云函数计算对层的大小限制为 50 MB(不包括预安装的依赖包)。

为了解决这个问题,您可以考虑以下几个方面进行优化:

压缩层:可以将层的文件进行压缩,例如使用 gzip、zip 等压缩工具对文件进行压缩,减小文件大小。在部署函数时,需要将压缩后的文件上传到云服务商的平台,并在函数配置中指定压缩文件的路径。

精简层:可以分析层的依赖,移除不必要的依赖或者使用更小的依赖替代原有依赖。例如,可以使用更轻量的 Flask 而不是 Django,或者使用更小的数据库驱动包等。

减少层的大小:可以考虑将层拆分成多个小层,分别部署到云服务商的平台上。这样可以避免单个层文件过大的问题,并且可以更灵活地管理和更新层。

使用云服务商提供的解决方案:一些云服务商提供了层的管理和优化工具,例如 AWS Lambda Layers Manager、阿里云函数计算层托管等,可以帮助您更方便地管理和优化层,避免出现大小超限的问题。

调整函数代码:可以考虑将函数代码和依赖包直接打包到函数中,避免使用层。这样可以避免层大小超限的问题,但同时也会增加函数代码的大小,需要根据实际情况进行权衡。

2023-06-16 08:02:45赞同 展开评论 -

-

值得去的地方都没有捷径

这个问题一般是因为模型参数过大,导致模型无法在可用内存中运行所致。以下是一些可能的解决方案:

对模型进行精简:这可能包括剪枝、量化、分散训练等技术,以降低模型的大小。

使用分布式训练:将训练任务分片,分布式训练可以在多个计算节点上同时进行训练,这通常可以加快训练速度并减少内存占用。

缩小输入数据:如果您的输入数据集非常大,可以考虑缩小数据集的大小。

调整Batch size: 通过调整batch size来减少每次迭代所需的内存。

使用更高内存的计算资源:尝试将模型部署到更高内存的计算资源,例如云服务器等。

可以尝试修改模型架构来缩小模型的总参数数量。

根据具体的实际情况,您可以尝试其中的一些或多个解决方案来解决这个问题。

2023-06-15 16:09:01赞同 展开评论 -

AWS Lambda 限制层的大小不能超过 50MB,因此如果您设置了层并且每次部署都会报“size 过大”的错误信息,那么很可能是因为您的层文件超过了这个限制。

为了解决这个问题,您可以考虑以下几种方法:

-

压缩文件:将您的层文件压缩成 ZIP 或 TAR 格式,以减小文件大小。通常情况下,压缩文件可以显著地减小文件大小,并使其更易于传输和部署。

-

移除不必要的文件和依赖项:如果您的层包含不必要的文件或依赖项,可以尝试移除它们以缩小文件大小。您可以使用工具如 npm prune 或 yarn install --production 等来删除不必要的依赖项。

-

拆分层:如果您的层文件太大而无法满足限制,请考虑拆分层,将其分成多个较小的层。这样做可以避免单个层文件过大,并提供更好的灵活性和可重用性。

-

使用其他存储服务:如果您需要使用大量的库或数据,可以考虑使用 AWS S3、DynamoDB 等其他 AWS 存储服务来存储这些数据。这些服务可以提供更高的存储容量和更强大的数据处理能力,并且可以与 Lambda 函数进行集成,以提供更加完整的解决方案。

需要注意的是,AWS Lambda 的限制层大小和其他限制都是为了保护 AWS 系统和资源不受恶意用户的攻击或滥用。因此,请确保您的代码和文件符合 AWS 的最佳实践和安全规范,并遵守 AWS 的使用条款和条件。

2023-06-15 15:53:31赞同 展开评论 -

-

在部署时遇到 size 过大错误通常是由于打包后生成的文件或数据量太大而导致的。这个错误可以通过优化代码来解决。

以下是几个可能导致代码文件或数据量过大的原因:

- 打包文件中包含了太多的第三方库或插件,或者这些库或插件中又包含了其他第三方库或插件。

解决方法:使用按需加载的技术来加载所需的库或插件,而不是将所有库或插件都打包到一个文件中。此外,应该尽量避免使用过多的第三方库或插件,只选择必要的功能,并对这些库或插件进行优化。

- 打包文件中包含了过多的图片或其他媒体文件。

解决方法:优化图片或媒体文件的大小,并使用图片压缩、懒加载等技术来减少文件的大小。

- 打包文件中包含了大量重复的代码或未使用的代码。

解决方法:进行代码优化,删除重复的或未使用的代码,缩小代码文件的体积。

- 数据库中存储了大量无用的数据。

解决方法:清理数据,删除不需要的数据,以减少数据库中数据的总量。

如果以上解决方法无法解决部署时 size 过大的问题,可以考虑使用类似分块上传、数据分片等技术来将数据分成多个块进行上传或处理。这些技术可以有效地减少单个文件或数据量的大小,从而解决 size 过大的问题。

2023-06-15 14:31:05赞同 展开评论 -

当在函数中使用层(Layer)时,有一个限制是单个层文件的大小不能超过特定的限制。不同函数计算平台或工具对层大小的限制可能会有所不同,通常在几百兆字节到几个千兆字节之间。 如果您的层文件大小超过了平台的限制,部署时会出现报错提示 "size 过大"。在这种情况下,您有几个解决方案可尝试:

压缩文件:尝试使用压缩工具(例如 zip)对层文件进行压缩,以减小文件大小。确保在压缩后的文件可以在平台上被解压和识别。 减少层的依赖:检查层中的依赖项,并只包含必要的库和文件。如果有不需要的文件或库,可以移除它们以减小层的大小。 拆分层:如果层文件特别大,您可以尝试将其拆分为多个层。这样可以将功能相关的文件放在一个层中,并通过多个层提供所需的功能。 使用其他存储方式:如果层文件超过平台限制,考虑使用其他存储服务如对象存储服务(如阿里云 OSS、亚马逊 S3)等,将文件存储在这些服务中,并在函数代码中进行下载和使用。

2023-06-15 11:52:40赞同 展开评论