请教一个问题,flinkKafka 怎么配置两个不同sasl.mechanism?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Apache Flink 与 Apache Kafka 集成时,可以使用 Kafka 的 SASL 安全性功能。但是,SASL 机制(如PLAIN, SCRAM-SHA-256等)在 Kafka 中是全局配置的,不能在同一个 Kafka broker 上为不同的 topic 设置不同的 SASL 机制。

如果你需要为不同的客户端或应用设置不同的 SASL 机制,通常需要在客户端进行配置。例如,如果你使用 Flink Kafka Consumer,你可以在创建 consumer 时指定所需的 SASL 机制。

示例代码:

Properties props = new Properties();

props.setProperty("bootstrap.servers", "your-kafka-broker:9092");

props.setProperty("security.protocol", "SASL_PLAINTEXT"); // 或者 "SASL_SSL"

props.setProperty("sasl.mechanism", "SCRAM-SHA-256"); // 或者 "PLAIN"

// 其他配置...

FlinkKafkaConsumer<String> consumer = new FlinkKafkaConsumer<>(

"your-topic",

new SimpleStringSchema(),

props,

new DefaultDeserializationSchemaWrapper<>(new StringSchema()));

如果你需要在 Kafka broker 级别为每个 topic 设置不同的 SASL 机制,那么你需要创建多个 Kafka broker 实例,每个实例配置不同的 SASL 机制,然后让 Flink 与这些 broker 进行交互。

如果你正在使用 YARN 或其他集群管理器来部署你的 Flink 应用,那么你也可以在集群级别配置 SASL,这样所有的 Flink 应用都可以使用这个配置。

Apache Flink 是一个流处理框架,而 Kafka 是一个分布式流平台。当你想在 Flink 和 Kafka 之间使用 SASL(Simple Authentication and Security Layer)进行安全通信时,你需要配置 Flink 的 Kafka 连接器以使用 SASL。

但是,Flink Kafka Connector 并不直接支持为同一 Kafka 集群配置多个 SASL 机制。你只能为整个连接器配置一个 SASL 机制。

如果你确实需要为不同的 Kafka 主题或组使用不同的 SASL 机制,你可能需要采用以下方法之一:

配置与Kafka进行连接时支持两种或多种不同的SASL机制,可以通过为每个Flink Kafka消费或生产客户端单独配置属性来实现。例如,如果您需要连接到两个具有不同SASL认证机制的Kafka集群,可以分别为这两个集群创建独立的Flink Kafka Consumer或Producer,并分别配置它们。

Apache Flink 是一个流处理框架,而 Kafka 是一个分布式流平台。在 Flink 与 Kafka 集成时,可以使用 Flink Kafka Consumer 来消费 Kafka 中的数据。当 Kafka 需要进行身份验证和授权时,可以使用 SASL(Simple Authentication and Security Layer)来提供安全性。

如果你想要配置两个不同的 SASL 机制,例如同时使用 SCRAM 和 PLAIN,那么需要分两步来实现:

创建两个不同的 Flink Kafka Consumers:

第一个 Consumer 使用 PLAIN SASL 机制。

第二个 Consumer 使用 SCRAM SASL 机制。

配置这两个 Consumer:

在 Flink 的 flink-conf.yaml 或 flink-conf.properties 文件中配置 SASL 的相关属性。例如:

yamlsecurity.kerberos.login.use-ticket-cache: false

security.kerberos.login.keytab: /path/to/keytab

security.kerberos.login.principal: user@realm

security.sasl.mechanism.plain: "KERBEROS"

对于 SCRAM,你可能需要配置其他的属性,如 security.sasl.mechanism.scram.password-secret 来指定密码秘钥。

在 Flink SQL 或应用程序中创建源表:

创建两个源表,每个源表对应一个不同的 Consumer 和 SASL 机制。

处理数据:

从这两个源表中读取数据并进行处理。

注意:确保你的 Kafka 集群配置了相应的 SASL 机制和权限,以便与 Flink 进行正确通信。同时,为了测试目的,可以先在一个环境中配置和测试,然后再应用到生产环境中。

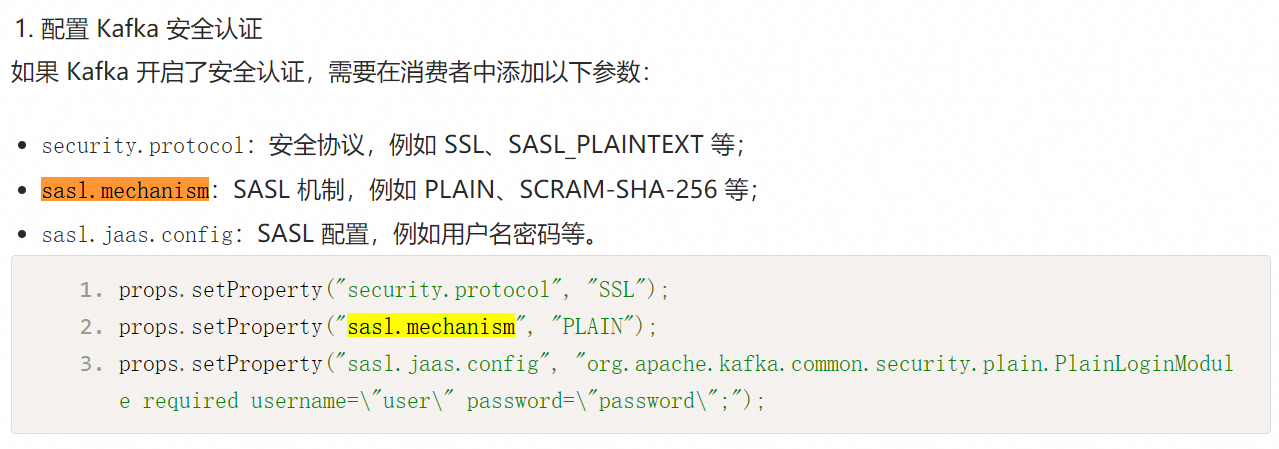

Apache Flink 支持多种 SASL mechanism 来保护 Kafka consumer 或 producer 与 Kafka broker 之间的通讯安全性。当使用 SASL PLAIN authentication scheme 并希望指定特定的安全机制时,可以通过设置 sasl.mechanism 属性来达到目的。

假设你想分别配置两个不同的 SASL mechanisms,一个是用于生产者,另一个则应用于消费者。在这种情况下,你可以创建两个独立的任务来管理这两个组件的不同行为。然后,你在各自的 task 设置中单独配置对应的 SASL mechanism。

举个例子来说,如果你想要使用 GSSAPI as your primary mechanism and then use SCRAM-SHA-256 as secondary one.

对于生产者部分,添加以下配置项至 Flink's configuration file (flink-conf.yaml):

# For producers

kafka.producer.bootstrap.servers=broker1.example.com,broker2.example.com,...

kafka.producer.security.protocol=SASL_PLAINTEXT

# Configure GSSAPI mechanism for producers

kafka.producer.sasl.kerberos.service.name=kafka

kafka.producer.sasl.jaas.config="com.sun.security.auth.module.Krb5LoginModule required \

debug=true \

useKeyTab=false \

keyTab="/etc/security/keytabs/kafka.keytab" \

principal="<EMAIL>" \

serviceName="kafka";

";

# Configure SCRAM-SHA-256 mechanism for producers

kafka.producer.sasl.mechanism=GSSAPI;

而对于消费者部分,同样也需要添加相似的配置选项:

# For consumers

kafka.consumer.bootstrap.servers=broker1.example.com,broker2.example.com,...,

kafka.consumer.security.protocol=SASL_PLAINTEXT,

# Configure GSSAPI mechanism for consumers

kafka.consumer.sasl.kerberos.service.name=kafka

kafka.consumer.sasl.jaas.config="com.sun.security.auth.module.Krb5LoginModule required \

debug=true \

useKeyTab=false \

keyTab="/etc/security/keytabs/kafka.client.keytab" \

principal="<EMAIL>" \

serviceName="kafka";

"

# Configure SCRAM-SHA-256 mechanism for consumers

kafka.consumer.sasl.mechanism=GSSAPI;

当然,在实际项目中,你应当谨慎选择适合自己的安全机制组合,并遵守最佳实践指南。上面的例子仅是为了说明如何配置两种不同的 SASL mechnisms。

Apache Flink 的 Kafka Connector 支持多种安全认证方式,包括 SASL 机制。然而,Flink Kafka Connector 本身并不直接支持单个 connector 同时配置两个不同的 SASL 机制,因为它针对的是单个 Kafka 集群的连接和认证。

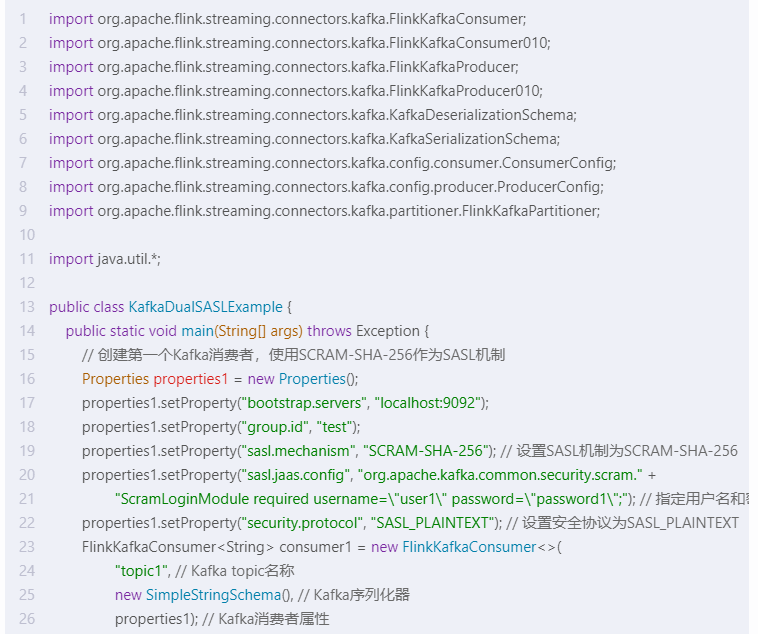

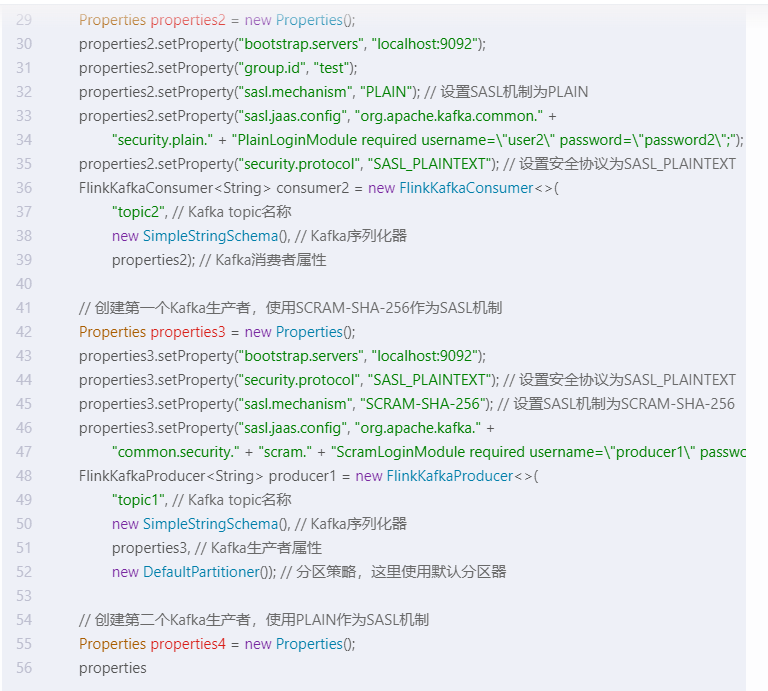

如果你需要连接到两个使用不同 SASL 机制的 Kafka 集群,你应当创建两个独立的 Flink Kafka Consumer 或 Producer,并分别为每个集群配置相应的 SASL 机制。下面是一个示例,展示如何分别为两个集群配置不同的 SASL 机制:

# Flink Table API 示例

# 第一个 Kafka Source

source1:

type: kafka

topic: topic1

properties.bootstrap.servers: "kafka-cluster1:9092"

properties.sasl.mechanism: PLAIN

properties.security.protocol: SASL_SSL

# 其他相关认证属性,如 sasl.jaas.config 等...

# 第二个 Kafka Source

source2:

type: kafka

topic: topic2

properties.bootstrap.servers: "kafka-cluster2:9092"

properties.sasl.mechanism: SCRAM-SHA-256

properties.security.protocol: SASL_SSL

# 其他相关认证属性,如 sasl.jaas.config 等...

# 创建两个表源并关联到各自的 Kafka 配置

CREATE TABLE table1 (

[...]

) WITH (

'connector' = 'source1', -- 使用上面定义的 source1 配置

[...]

);

CREATE TABLE table2 (

[...]

) WITH (

'connector' = 'source2', -- 使用上面定义的 source2 配置

[...]

);

# 类似的,对于 Flink DataStream API,也会创建两个单独的 FlinkKafkaConsumer 实例

这里的配置是抽象的,实际应用中需要将它们转换为具体的 Flink 配置形式,例如在 Table API 中使用 TableEnvironment.createTemporaryTable 方法配合 Properties 参数,或者在 DataStream API 中直接初始化 FlinkKafkaConsumer 时传入带有不同 SASL 机制配置的 Properties 对象。

在Flink Kafka中,可以通过配置多个SASL机制来实现两个不同的认证方式。具体步骤如下:

# 定义第一个SASL机制

sasl.mechanism.INTERNAL.protocol=PLAIN

sasl.mechanism.INTERNAL.jaas.config=org.apache.kafka.common.security.plain.PlainLoginModule required username="${secret.user}"; password="${secret.password}";

# 定义第二个SASL机制

sasl.mechanism.EXTERNAL.protocol=SCRAM-SHA-256

sasl.mechanism.EXTERNAL.jaas.config=org.apache.kafka.common.security.scram.ScramLoginModule required username="${secret.user}"; password="${secret.password}";

# 指定要使用的SASL机制

security.protocol=SASL_SSL

sasl.enabled.mechanisms=INTERNAL,EXTERNAL

Properties properties = new Properties();

properties.setProperty("bootstrap.servers", "localhost:9092");

properties.setProperty("group.id", "test");

properties.setProperty("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

properties.setProperty("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

properties.setProperty("security.protocol", "SASL_SSL");

properties.setProperty("sasl.mechanism", "INTERNAL");

properties.setProperty("sasl.jaas.config", "org.apache.kafka.common.security.plain.PlainLoginModule required username=\"${secret.user}\"; password=\"${secret.password}\";");

Consumer<String, String> consumer = new KafkaConsumer<>(properties);

consumer.subscribe(Arrays.asList("test"));

通过以上步骤,就可以实现在Flink Kafka中配置两个不同的SASL机制。

在 Flink Kafka 中,您可以通过在 flink-conf.yaml 文件中配置两个不同的 SASL 机制来实现使用两个不同的 SASL.mechanism。

首先,您需要在 flink-conf.yaml 文件中添加两个 Kafka 连接器,每个连接器使用不同的 SASL 机制。例如:

kafka:

bootstrap-servers: localhost:9092

sasl-mechanism: PLAIN

security-protocol: SASL_PLAINTEXT

sasl-jaas-config: org.apache.kafka.common.security.plain.PlainLoginModule required username='username' password='password';

CopyCopy

在这个例子中,我们配置了一个使用 PLAIN SASL 机制的 Kafka 连接器。接下来,我们再配置另一个使用 SCRAM-SHA-256 SASL 机制的 Kafka 连接器:

kafka:

bootstrap-servers: localhost:9092

sasl-mechanism: SCRAM-SHA-256

security-protocol: SASL_PLAINTEXT

sasl-jaas-config: org.apache.kafka.common.security.scram.ScramLoginModule required username='username' password='password';

CopyCopy

在这个例子中,我们将 SASL 机制更改为 SCRAM-SHA-256。

请注意,您需要根据您的 Kafka 集群配置相应的 bootstrap-servers、security-protocol 和 sasl-jaas-config。同时,请确保 Flink 版本支持您所选择的 SASL 机制。

完成配置后,您可以通过 flink 命令行启动 Flink 集群,并在 Flink 应用程序中使用这两个 Kafka 连接器。

在Apache Flink与Apache Kafka集成时,我们可以通过properties配置来为不同的Kafka topic设置不同的SASL机制。下面是一个示例代码片段,演示如何为不同的Kafka topic配置不同的SASL机制。

可以通过配置KafkaConsumer的properties参数来设置两个不同的SASL机制。

Properties对象,用于存储Kafka消费者的配置信息。Properties properties = new Properties();

properties.setProperty("security.protocol", "SASL_PLAINTEXT");

properties.setProperty("sasl.mechanism", "PLAIN");

properties.setProperty("sasl.jaas.config", "org.apache.kafka.common.security.plain.PlainLoginModule required username=\"your-username\" password=\"your-password\";");

properties.setProperty("security.protocol", "SASL_SCRAM_SHA_256");

properties.setProperty("sasl.mechanism", "SCRAM-SHA-256");

properties.setProperty("sasl.jaas.config", "org.apache.kafka.common.security.scram.ScramLoginModule required username=\"your-username\" password=\"your-password\";");

Properties对象传递给KafkaConsumer的构造函数。FlinkKafkaConsumer<String> kafkaConsumer = new FlinkKafkaConsumer<>(topic, new SimpleStringSchema(), properties);

参考:kafka的sasl配置https://blog.csdn.net/asdfsadfasdfsa/article/details/104546740

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。