老师,这是咋回事呢??Flink CDC1.15.3不支持?? 我本地跑可以

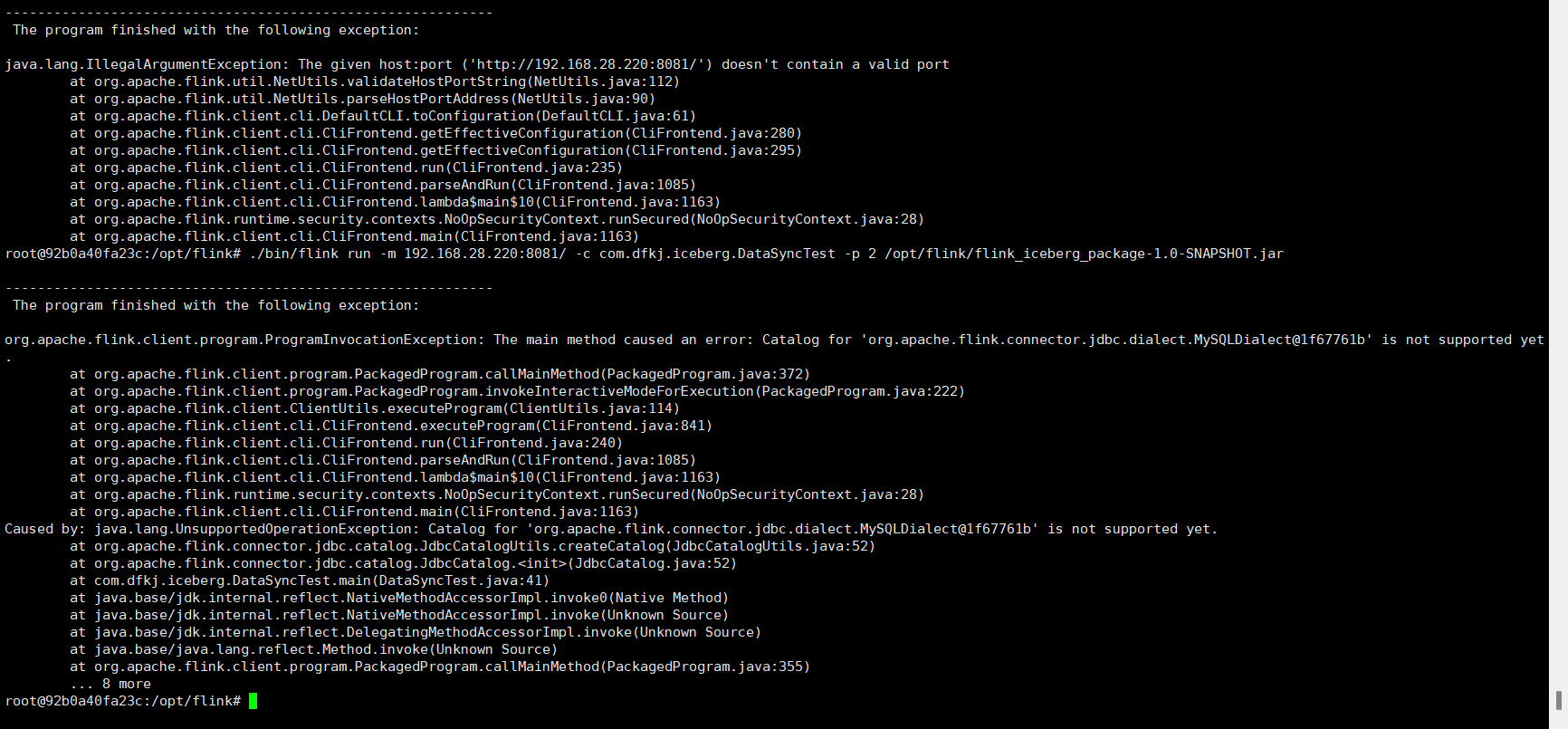

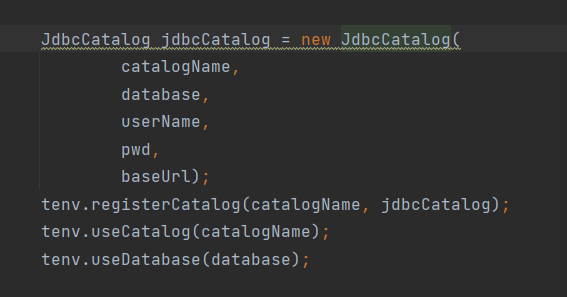

我本地跑可以 这段代码在我本地可以跑,但是上了服务器他就报Caused by: java.lang.UnsupportedOperationException: Catalog for 'org.apache.flink.connector.jdbc.dialect.MySQLDialect@1f67761b' is not supported yet.

这段代码在我本地可以跑,但是上了服务器他就报Caused by: java.lang.UnsupportedOperationException: Catalog for 'org.apache.flink.connector.jdbc.dialect.MySQLDialect@1f67761b' is not supported yet.

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的错误信息和知识库中的相关资料,以下是问题的详细分析和解决方案:

错误信息:

Caused by: java.lang.UnsupportedOperationException: Catalog for 'org.apache.flink.connector.jdbc.dialect.MySQLDialect@1f67761b' is not supported yet.

该错误表明当前使用的Flink CDC版本(1.15.3)在服务器环境中不支持MySQLDialect相关的Catalog功能。结合知识库内容,可能的原因包括以下几点:

Flink CDC版本与Flink引擎版本不匹配

Flink CDC连接器的版本需要与Flink运行时的版本严格匹配。如果服务器上的Flink引擎版本与本地开发环境的版本不同,可能会导致兼容性问题。

Catalog功能未启用或不受支持

某些Flink CDC版本可能尚未完全支持特定的Catalog功能(如MySQLDialect)。这可能是由于Flink CDC社区版的功能限制或阿里云实时计算平台的定制化实现差异。

依赖冲突或缺失

如果服务器环境中缺少必要的依赖包,或者存在依赖冲突(例如使用了不兼容的JAR包),也可能导致此问题。

环境配置差异

本地开发环境与服务器环境可能存在配置差异,例如JDK版本、Python版本或其他运行时依赖的差异。

根据知识库中提供的CDC与VVR版本对应关系,请确认服务器上使用的Flink引擎版本是否与Flink CDC 1.15.3兼容。如果不兼容,请升级或降级Flink CDC版本以匹配服务器环境。

检查方法:

在服务器上运行以下命令,查看Flink引擎版本:

flink --version

根据返回的版本号,参考知识库中的版本对应表,选择合适的Flink CDC版本。

调整版本:

如果服务器上的Flink引擎版本为vvr-6.0.2-flink-1.15,则应使用Flink CDC release-2.3或更高版本。

如果您的代码中使用了Catalog功能(例如通过CREATE TABLE语句动态注册表),请确认当前Flink CDC版本是否支持MySQLDialect的Catalog功能。

MySQLDialect的最新版本。CREATE TABLE mysql_source (

id INT,

name STRING,

PRIMARY KEY (id) NOT ENFORCED

) WITH (

'connector' = 'mysql-cdc',

'hostname' = 'your-mysql-host',

'port' = '3306',

'username' = 'your-username',

'password' = 'your-password',

'database-name' = 'your-database',

'table-name' = 'your-table'

);

确保服务器环境中包含了所有必要的依赖包,并且没有版本冲突。

检查方法:

查看服务器上的lib目录,确认是否存在以下JAR包:

flink-sql-connector-mysql-cdc-xxx.jar(FAT JAR,包含所有依赖)flink-connector-mysql-cdc-xxx.jar(仅包含连接器代码,需手动管理依赖)如果使用的是flink-connector-mysql-cdc-xxx.jar,请确保手动添加了所有依赖包,并排除可能的冲突依赖。

解决方法:

如果存在依赖冲突,可以通过exclude和shade处理冲突依赖。例如,在Maven项目中添加以下配置:

<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-mysql-cdc</artifactId>

<version>1.15.3</version>

<exclusions>

<exclusion>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.11</artifactId>

</exclusion>

</exclusions>

</dependency>

根据知识库中的限制说明,请确认服务器环境是否满足以下要求: - JDK版本:仅支持JDK 8或JDK 11。 - Python版本:如果使用了PyFlink作业,请确认Python版本是否与Flink引擎版本匹配。 - 网络配置:确保Flink能够正常连接到MySQL数据库。如果是同VPC环境,请使用内网地址并添加白名单;如果是公网连接,请配置NAT访问公网。

如果上述方法仍无法解决问题,可以通过调整日志级别获取更详细的错误信息。

log4j.properties文件中添加以下配置:

logger.flink.name = org.apache.flink

logger.flink.level = DEBUG

根据以上分析,建议您按照以下步骤排查和解决问题: 1. 确认Flink CDC版本与Flink引擎版本的兼容性,并调整版本。 2. 检查是否使用了不支持的Catalog功能,并尝试手动注册表。 3. 检查依赖冲突,并通过exclude和shade处理冲突依赖。 4. 确认服务器环境配置是否符合要求。 5. 调整日志级别以获取更多调试信息。

如果问题仍未解决,请提供更多上下文信息(例如完整的代码和配置),以便进一步分析。您也可以通过ECS一键诊断全面排查并修复ECS问题。