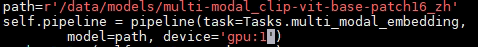

你好,请问ModelScope我指定显卡1为什么一直在调用0? clip是不是有 默认GPU加载,所以我指定没用?

clip是不是有 默认GPU加载,所以我指定没用?

您好!根据您描述的问题,您在使用ModelScope时指定了显卡1,但系统却一直在调用显卡0。这可能与环境变量配置或默认行为有关。以下是详细分析和解决方法:

在使用GPU资源时,容器内可见的GPU设备是通过环境变量ALIYUN_COM_GPU_VISIBLE_DEVICES来控制的。如果未正确设置该环境变量,或者系统存在默认加载行为,则可能导致指定的显卡未被正确调用。

ALIYUN_COM_GPU_VISIBLE_DEVICES,系统可能会默认使用显卡0。确保在部署服务时正确设置了ALIYUN_COM_GPU_VISIBLE_DEVICES环境变量。例如: - 如果您希望使用显卡1,可以设置为:

ALIYUN_COM_GPU_VISIBLE_DEVICES=1

ALIYUN_COM_GPU_VISIBLE_DEVICES=1,2

此环境变量的作用是指定容器内可见的GPU设备号或UUID。如果不设置或设置为0,则默认使用显卡0。

在容器启动后,可以通过以下命令验证当前容器是否正确绑定了显卡1:

nvidia-smi

该命令会列出当前容器内可见的GPU设备。如果输出中仅显示显卡1的信息,则说明配置成功。

部分模型(如CLIP)可能在代码中硬编码了默认使用的GPU设备(通常是cuda:0)。您需要检查模型代码,确保其正确指定了目标设备。例如,在PyTorch中,可以通过以下方式指定设备:

import torch

# 指定使用显卡1

device = torch.device("cuda:1")

model.to(device)

如果显卡1被其他进程占用,可能导致系统回退到显卡0。您可以通过以下命令检查显卡1的使用情况:

nvidia-smi

如果发现显卡1已被占用,您可以尝试释放资源,或者调整环境变量以使用其他空闲显卡。

CLIP模型本身并没有强制要求加载到显卡0,但某些实现可能会默认使用cuda:0作为设备。因此,建议您检查模型加载代码,确保显卡设备被正确指定。

ALIYUN_COM_GPU_MEM_CONTAINER设置容器内可见的显存大小。通过正确设置ALIYUN_COM_GPU_VISIBLE_DEVICES环境变量,并检查模型代码中的设备绑定逻辑,可以解决显卡0被默认调用的问题。如果问题仍然存在,建议进一步排查多进程冲突或资源分配限制。

希望以上解答对您有所帮助!如有其他疑问,请随时提问。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352