大佬们 请教个问题 在开启flink分区发现Kafka partition的时候,扩分区后会导致任务重报错咋回事?

java.lang.RuntimeException: One or more fetchers have encountered exception at org.apache.flink.connector.base.source.reader.fetcher.SplitFetcherManager.checkErrors(SplitFetcherManager.java:223) at org.apache.flink.connector.base.source.reader.SourceReaderBase.getNextFetch(SourceReaderBase.java:154) at org.apache.flink.connector.base.source.reader.SourceReaderBase.pollNext(SourceReaderBase.java:116) at org.apache.flink.streaming.api.operators.SourceOperator.emitNext(SourceOperator.java:294) at org.apache.flink.streaming.runtime.io.StreamTaskSourceInput.emitNext(StreamTaskSourceInput.java:69) at org.apache.flink.streaming.runtime.io.StreamOneInputProcessor.processInput(StreamOneInputProcessor.java:66) at org.apache.flink.streaming.runtime.tasks.StreamTask.processInput(StreamTask.java:423) at org.apache.flink.streaming.runtime.tasks.mailbox.MailboxProcessor.runMailboxLoop(MailboxProcessor.java:204) at org.apache.flink.streaming.runtime.tasks.StreamTask.runMailboxLoop(StreamTask.java:684) at org.apache.flink.streaming.runtime.tasks.StreamTask.executeInvoke(StreamTask.java:639) at org.apache.flink.streaming.runtime.tasks.StreamTask.runWithCleanUpOnFail(StreamTask.java:650) at org.apache.flink.streaming.runtime.tasks.StreamTask.invoke(StreamTask.java:623) at org.apache.flink.runtime.taskmanager.Task.doRun(Task.java:779) at org.apache.flink.runtime.taskmanager.Task.run(Task.java:566) at java.lang.Thread.run(Thread.java:748) Caused by: java.lang.RuntimeException: SplitFetcher thread 0 received unexpected exception while polling the records at org.apache.flink.connector.base.source.reader.fetcher.SplitFetcher.runOnce(SplitFetcher.java:148) at org.apache.flink.connector.base.source.reader.fetcher.SplitFetcher.run(SplitFetcher.java:103) at java.util.concurrent.Executors$RunnableAdapter.call(Executors.java:511) at java.util.concurrent.FutureTask.run(FutureTask.java:266) at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1149) at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624) ... 1 more Caused by: org.apache.kafka.common.errors.WakeupException at org.apache.kafka.clients.consumer.internals.ConsumerNetworkClient.maybeTriggerWakeup(ConsumerNetworkClient.java:511) at org.apache.kafka.clients.consumer.internals.ConsumerNetworkClient.poll(ConsumerNetworkClient.java:275) at org.apache.kafka.clients.consumer.internals.ConsumerNetworkClient.poll(ConsumerNetworkClient.java:233) at org.apache.kafka.clients.consumer.internals.ConsumerNetworkClient.poll(ConsumerNetworkClient.java:212) at org.apache.kafka.clients.consumer.internals.ConsumerCoordinator.fetchCommittedOffsets(ConsumerCoordinator.java:799) at org.apache.kafka.clients.consumer.internals.ConsumerCoordinator.refreshCommittedOffsetsIfNeeded(ConsumerCoordinator.java:750) at org.apache.kafka.clients.consumer.KafkaConsumer.updateFetchPositions(KafkaConsumer.java:2338) at org.apache.kafka.clients.consumer.KafkaConsumer.position(KafkaConsumer.java:1725) at org.apache.kafka.clients.consumer.KafkaConsumer.position(KafkaConsumer.java:1684) at org.apache.flink.connector.kafka.source.reader.KafkaPartitionSplitReader.removeEmptySplits(KafkaPartitionSplitReader.java:362) at org.apache.flink.connector.kafka.source.reader.KafkaPartitionSplitReader.handleSplitsChanges(KafkaPartitionSplitReader.java:247) at org.apache.flink.connector.base.source.reader.fetcher.AddSplitsTask.run(AddSplitsTask.java:49) at org.apache.flink.connector.base.source.reader.fetcher.SplitFetcher.runOnce(SplitFetcher.java:140) ... 6 more

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Apache Flink与Kafka集成时,遇到扩分区后任务重报错的问题,通常是因为Flink的Kafka消费者未能正确处理分区数量的变化。具体到您提供的错误信息,问题可能出在以下几个方面:

WakeupException: 这个异常通常是由于在消费过程中调用了consumer.wakeup()方法导致的,这是正常的关闭或中断消费者的手段。但在您的场景中,如果这个操作不是预期中的(例如,没有主动关闭消费者),那么可能是并发修改配置或者资源竞争导致的意外唤醒。

分区发现机制: Flink Kafka Connector支持动态发现新的分区,但对已存在的分区扩缩容的处理可能不够平滑。当Kafka分区数量变化时,Flink作业需要重新调整其分配的source reader以适应新的分区布局。如果这个过程处理不当,可能会导致数据重复消费或丢失。

Offset管理: 扩展分区可能导致消费者尝试从不存在的旧偏移量读取数据,尤其是在使用特定的offset恢复策略(如EARLIEST/LATEST)时,如果Flink未能正确地更新其内部的offset状态,就可能出现异常。

解决这个问题可以尝试以下步骤:

确保兼容性: 确认使用的Flink和Kafka版本之间是兼容的,有时候特定版本组合可能存在已知问题。

优雅重启: 在进行Kafka分区扩缩容操作前后,考虑优雅地重启Flink作业,这样可以让Flink有机会重新初始化其Kafka消费者,并根据最新的分区情况来调整。

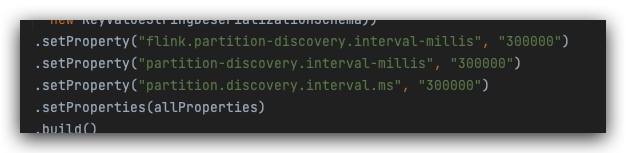

配置检查: 检查Flink作业的Kafka源配置,确保启用了分区发现功能,并且设置合适的offset commit策略。例如,可以设置flink kafka consumer set-startup-mode latest-offsets来避免从历史偏移量读取数据。

手动处理分区变化: 如果自动处理不理想,可以编写自定义的逻辑来监听Kafka主题的分区变化事件,并在检测到变化时通过Flink的Savepoint机制重启作业。

日志分析: 详细查看Flink作业的日志,特别是与Kafka消费者初始化、分区分配相关的部分,这有助于定位问题的具体原因。

资源与并发度: 调整Flink作业的并行度,确保有足够的source reader来处理所有分区,同时注意不要过度分配资源导致资源竞争。

如果上述方法都不能解决问题,建议查阅Flink社区的相关讨论或者提交一个issue到Flink的GitHub仓库,以便获得更专业的帮助。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。