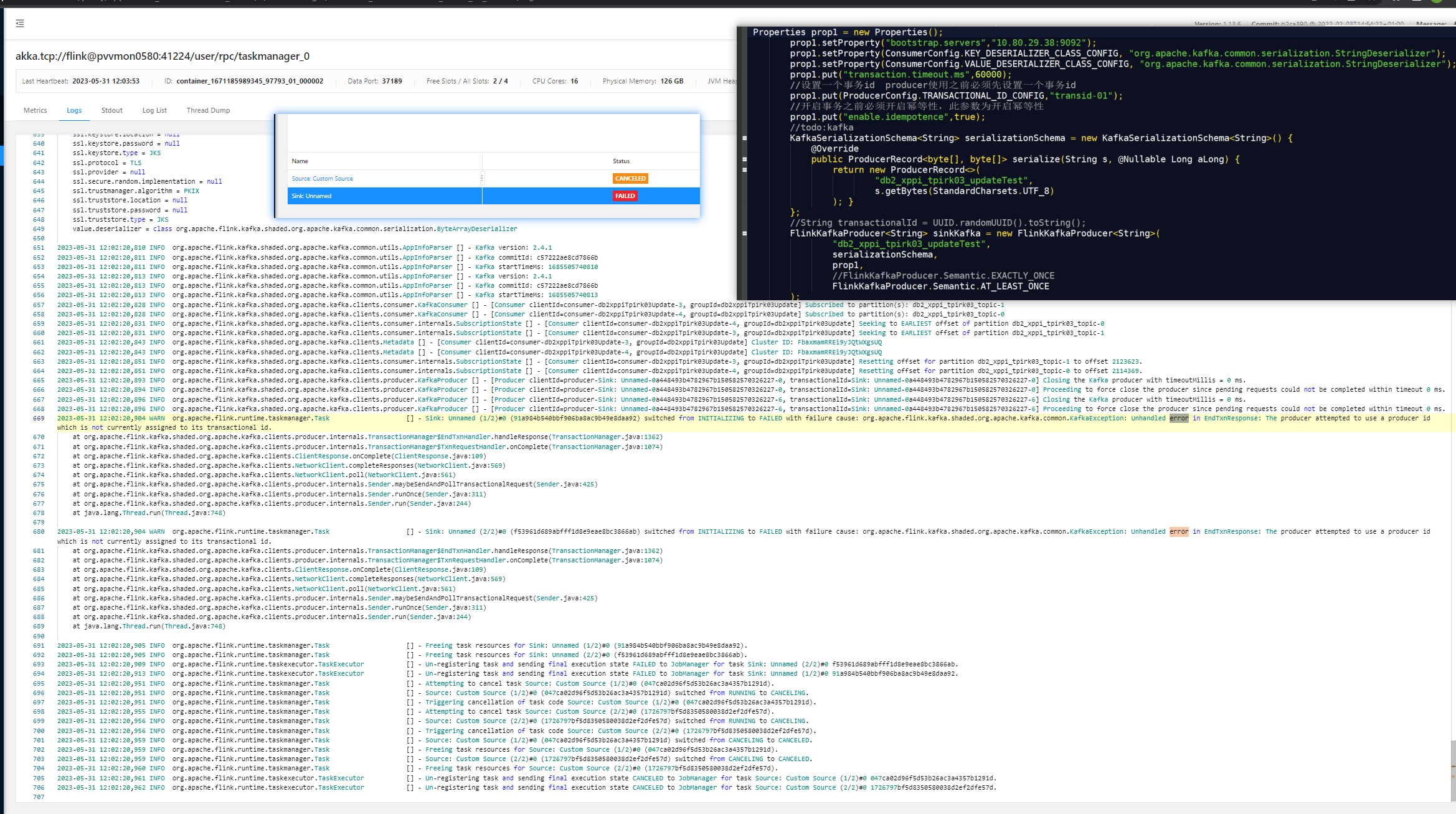

大佬们请教一个Flink CDC重启生产者的问题,我通过检查点重启作业,但是sink的Kafka topic换了,就一直报错说生产者尝试使用producer id,但是当前没有给其分配对应的transactional id,这个怎么解决?我通过网上了解到的 producer启动时Kafka会为其分配一个唯一的producer id,这个transactional id是我们自己手动指定的?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,Flink CDC作业在通过检查点重启时,由于Kafka Sink的Topic发生了变更,导致报错提示“生产者尝试使用producer id,但当前没有分配对应的transactional id”。以下是针对该问题的详细分析和解决方案:

在Flink Kafka Sink中,当启用exactly-once语义时,Kafka事务机制会为每个并发的Producer分配一个唯一的transactional.id。这个transactional.id是基于用户配置的sink.transactional-id-prefix生成的。

transactional.id未正确更新或重新分配,可能会导致以下问题:

transactional.id,从而拒绝Producer的事务请求。transactional.id,导致报错。此外,producer id是由Kafka自动分配的,而transactional.id需要用户手动指定前缀(sink.transactional-id-prefix),并由Flink根据并发度动态生成完整的ID。

exactly-once语义检查您的Flink作业配置,确保sink.delivery-guarantee参数设置为exactly-once。如果未启用exactly-once语义,则无需配置transactional.id,也不会出现此问题。

'sink.delivery-guarantee' = 'exactly-once'

transactional.id-prefix在Flink Kafka Sink中,必须为exactly-once语义配置sink.transactional-id-prefix。该参数用于生成唯一的transactional.id,以确保事务的正确性。

示例配置如下:

'sink.transactional-id-prefix' = 'flink-kafka-txn-'

注意:transactional.id-prefix的值应具有全局唯一性,避免与其他Flink作业或Kafka Producer冲突。

如果Kafka Sink的Topic发生了变更,建议采取以下措施:

清理旧的事务状态

在Kafka中,旧的transactional.id可能仍然存在,导致新作业无法正常启动。可以通过以下方式清理旧的事务状态:

transactional.id相关的事务日志。transactional.id-prefix与旧的前缀不同,以避免冲突。重新初始化Flink作业

如果Topic变更较大,建议重新初始化Flink作业,而不是从检查点恢复。具体操作包括:

transactional.id-prefix重新提交作业。在exactly-once语义下,Flink Kafka Producer会使用一个固定大小的Producer池。如果并发的Checkpoint数量超过Producer池的大小,可能会导致作业失败。建议根据实际需求调整Producer池大小和最大并发Checkpoint数量。

确保网络连通性

确认Flink与Kafka之间的网络连通性正常,并且Flink能够访问Kafka Broker的Endpoint信息。如果Endpoint中使用了域名,请为Flink配置正确的域名解析服务。

避免在第一个Checkpoint完成前缩减并行度

在exactly-once语义下,缩减并行度可能会导致事务状态不一致。建议在第一个Checkpoint完成后再进行并行度调整。

检查权限配置

确保Flink作业使用的Kafka用户具有写入目标Topic的权限。如果权限不足,可能会导致事务提交失败。

通过上述步骤,您可以解决因Kafka Topic变更导致的transactional.id分配问题。关键在于正确配置sink.transactional-id-prefix,并确保事务状态的一致性。如果问题仍然存在,建议检查Kafka的日志和Flink作业的详细错误信息,进一步定位问题根源。

希望以上解答对您有所帮助!您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。