Flink CDC 数据还没同步完,日志显示全量数据读取完了?这种情况是不是没法做断点续传了

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

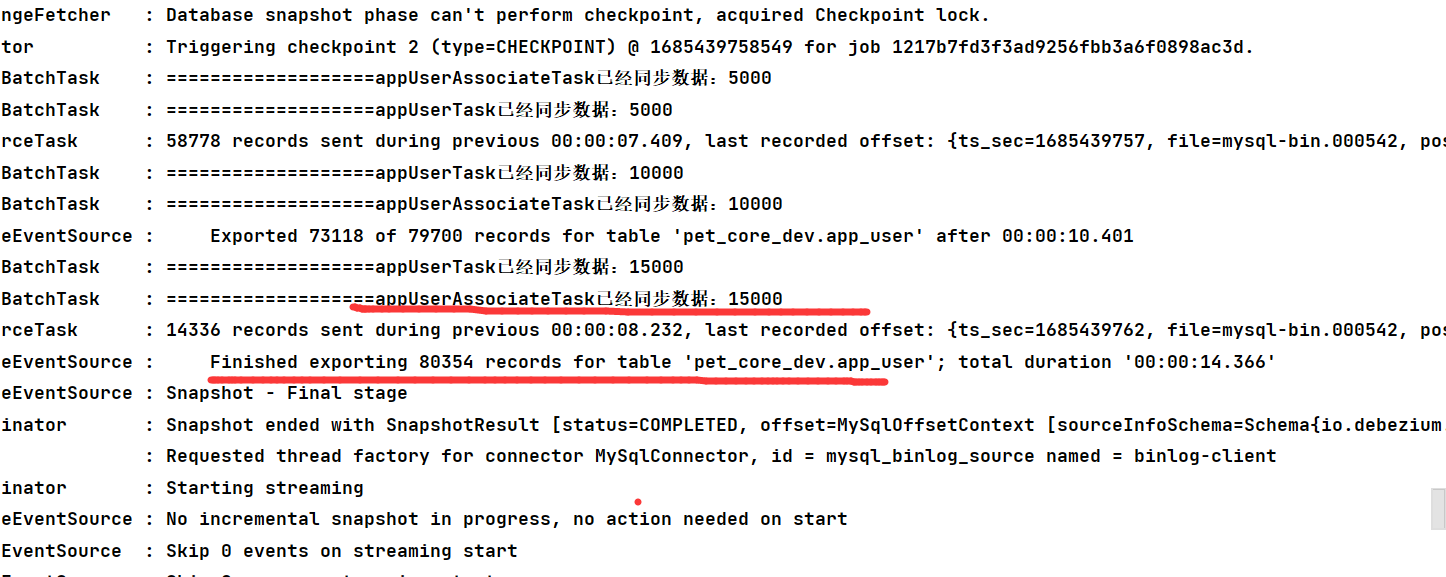

根据您描述的情况,Flink CDC 日志显示全量数据已经读取完成,但实际数据同步尚未完成。这种情况下,是否还能实现断点续传需要结合具体场景和配置来分析。

Flink CDC 在全量阶段完成后会自动切换到增量阶段(Binlog 读取)。可以通过以下方式确认全量数据是否真正完成: - 监控指标:通过 currentEmitEventTimeLag 指标判断。当该指标大于 0 时,表示作业已完成全量数据同步,进入 Binlog 读取阶段。 - 日志排查:在 MySQL CDC 源表所在的 TaskManager (TM) 日志中查找 BinlogSplitReader is created 的日志,确认是否已切换到增量阶段。

如果上述条件均已满足,则说明全量数据读取确实已完成,且系统已进入增量阶段。

Flink CDC 支持断点续传功能,即使在全量阶段或增量阶段发生故障,也可以从断点处继续处理数据。以下是断点续传的关键机制: - 全量阶段:Flink CDC 使用增量快照算法,支持无锁读取和断点续传。即使全量读取过程中发生故障,恢复后可以从上次的断点继续读取。 - 增量阶段:Flink CDC 通过 Binlog 的位点信息记录当前读取进度。如果作业重启,会从最近的 Checkpoint 或 Savepoint 恢复,确保不丢失数据。

因此,即使日志显示全量数据读取完成,只要作业配置了 Checkpoint 或 Savepoint,仍然可以实现断点续传。

如果日志显示全量数据读取完成,但下游数据仍未同步完整,可能是以下原因导致:

execution.checkpointing.interval: 5min

execution.checkpointing.mode: EXACTLY_ONCE

为了确认数据是否完整同步,可以采取以下步骤: 1. 全量数据验证: - 查询下游存储中的数据总量,与源数据库中的数据总量进行对比。 - 示例 SQL: sql SELECT COUNT(*) FROM target_table; - 确保下游数据量与源数据库一致。

增量数据验证:

SELECT * FROM target_table ORDER BY update_time DESC LIMIT 10;

监控指标:

currentEmitEventTimeLag 指标,确保其值稳定且大于 0,表明增量数据正在正常同步。希望以上解答能帮助您解决问题!如有其他疑问,请随时提问。